Method Article

Bir Köpeğin Gözünden: Köpek Korteksinden Doğal Videoların fMRI Kod Çözme

Bu Makalede

Özet

Makine öğrenimi algoritmaları, insanlara sunulan uyaranları "çözmek" için beyin aktivitesi kalıplarını kullanmak üzere eğitilmiştir. Burada, aynı tekniğin iki evcil köpeğin beyninden doğal video içeriğini çözebileceğini gösteriyoruz. Videolardaki eylemlere dayalı kod çözücülerin köpeklerde başarılı olduğunu bulduk.

Özet

İnsan ve insan olmayan korteksten gelen görsel uyaranları çözmek için makine öğrenimi ve fonksiyonel manyetik rezonans görüntüleme (fMRI) kullanan son gelişmeler, algının doğasına ilişkin yeni anlayışlarla sonuçlandı. Bununla birlikte, bu yaklaşım henüz primatlar dışındaki hayvanlara büyük ölçüde uygulanmamıştır ve bu da hayvanlar alemindeki bu tür temsillerin doğası hakkında soruları gündeme getirmektedir. Burada, iki evcil köpek ve iki insanda, her biri özel olarak oluşturulmuş köpeğe uygun doğal videoları izlerken elde edilen uyanık fMRI kullandık. Daha sonra, video içeriğini her birinden toplam 90 dakikalık kaydedilmiş beyin aktivitesinden sınıflandırmak için bir sinir ağı (Ivis) eğittik. Hem köpek, insan ve araba gibi kategorileri ayırt etmeye çalışan nesne tabanlı bir sınıflandırıcıyı hem de yemek yeme, koklama ve konuşma gibi kategorileri ayırt etmeye çalışan eylem tabanlı bir sınıflandırıcıyı test ettik. Her iki sınıflandırıcı türünün de şansın çok üzerinde performans gösterdiği iki insan denekle karşılaştırıldığında, köpeklerden gelen video içeriğinin kodunu çözmede yalnızca eyleme dayalı sınıflandırıcılar başarılı oldu. Bu sonuçlar, bir etoburun beyninden doğal videoları çözmek için makine öğreniminin bilinen ilk uygulamasını gösteriyor ve köpeğin dünyaya bakışının bizimkinden oldukça farklı olabileceğini gösteriyor.

Giriş

İnsanların beyinleri, diğer primatlar gibi, görsel akışın farklı ve iyi bilinen işlevlere sahip dorsal ve ventral yollara parsellenmesini gösterir - nesnelerin "ne" ve "nerede"1. Bu ne/nerede ikilemi, onlarca yıldır yararlı bir sezgisel yöntem olmuştur, ancak anatomik temelinin artık çok daha karmaşık olduğu bilinmektedir ve birçok araştırmacı, eyleme karşı tanımaya dayalı bir parselasyonu tercih etmektedir ("ne" ve "nasıl")2,3,4,5. Ek olarak, primat görsel sisteminin organizasyonu hakkındaki anlayışımız rafine edilmeye ve tartışılmaya devam ederken, diğer memeli türlerinin beyinlerinin görsel bilgiyi nasıl temsil ettiği hakkında çok şey bilinmemektedir. Kısmen, bu lacuna, görsel sinirbilimde bir avuç türe tarihsel odaklanmanın bir sonucudur. Bununla birlikte, beyin görüntülemeye yönelik yeni yaklaşımlar, memeli sinir sisteminin organizasyonu hakkında yeni bilgiler sağlayabilecek olan daha geniş bir hayvan yelpazesinin görsel sistemlerini invaziv olmayan bir şekilde inceleme olasılığını ortaya çıkarmaktadır.

Köpekler (Canis lupus familiaris), primatlardan evrimsel olarak uzak bir türdeki görsel uyaranların temsilini incelemek için zengin bir fırsat sunar, çünkü sedasyon veya kısıtlamalara ihtiyaç duymadan MRG taramasına işbirliği içinde katılmak için eğitilebilecek tek hayvan olabilirler 6,7,8. Son 15.000 yılda insanlarla birlikte evrimleşmeleri nedeniyle, köpekler de çevremizde yaşar ve bir MRI tarayıcısında uyaranları sunmanın tercih edilen yolu olan video ekranları da dahil olmak üzere, insanların günlük olarak karşılaştığı birçok uyarana maruz kalırlar. Öyle olsa bile, köpekler bu ortak çevresel uyaranları insanlardan oldukça farklı şekillerde işleyebilir ve bu da görsel kortekslerinin nasıl organize edildiği sorusunu akla getirir. Bir fovea eksikliği veya bir dikromat olma gibi temel farklılıklar, yalnızca alt düzey görsel algı için değil, aynı zamanda daha üst düzey görsel temsil için de önemli aşağı yönlü sonuçlara sahip olabilir. Köpeklerde yapılan birkaç fMRI çalışması, primatlarda görülen genel dorsal / ventral akış mimarisini takip ediyor gibi görünen hem yüz hem de nesne işleme bölgelerinin varlığını göstermiştir, ancak köpeklerin kendi başına yüz işleme bölgelerine sahip olup olmadığı veya bu bölgelerin başın morfolojisi için seçici olup olmadığı belirsizliğini korumaktadır (örneğin, köpek ve insan)9, 10,11,12,13. Ne olursa olsun, bir köpeğin beyninin çoğu primattan daha küçük olduğu ve daha az modüler olacağı tahmin edilmektedir14, bu nedenle akışlarda bilgi türlerinin daha fazla karışması ve hatta eylemler gibi belirli bilgi türlerinin ayrıcalığı olabilir. Örneğin, hareketin köpek görsel algısında doku veya renkten daha belirgin bir özellik olabileceği öne sürülmüştür15. Ek olarak, köpeklerin dünyayla etkileşime girdiğimiz birincil araçlardan biri olan elleri olmadığından, özellikle nesnelerin görsel olarak işlenmesi, primatlarınkinden oldukça farklı olabilir. Buna paralel olarak, son zamanlarda nesnelerle ağızdan pençeye karşı etkileşimin, köpek beynindeki nesne seçici bölgelerde daha fazla aktivasyonla sonuçlandığına dair kanıtlar bulduk16.

Köpekler ev ortamlarında video ekranlarına alışkın olsalar da, bu, deneysel bir ortamda görüntülere bir insanın yapacağı gibi bakmaya alışkın oldukları anlamına gelmez. Daha doğal uyaranların kullanılması bu soruların bazılarının çözülmesine yardımcı olabilir. Son on yılda, makine öğrenimi algoritmaları, insan beyni aktivitesinden doğal görsel uyaranların kodunu çözmede önemli bir başarı elde etti. İlk başarılar, hem bir bireyin gördüğü uyaran türlerini hem de bu temsilleri kodlayan beyin ağlarını sınıflandırmak için beyin aktivitesini kullanmak için klasik, engellenmiş tasarımları uyarlamaya odaklandı 17,18,19. Daha güçlü algoritmalar, özellikle sinir ağları geliştirildikçe, doğal videolar da dahil olmak üzere daha karmaşık uyaranların kodu çözülebildi20,21. Tipik olarak bu videolara verilen sinirsel tepkiler üzerinde eğitilen bu sınıflandırıcılar, yeni uyaranlara genelleştirerek, fMRI yanıtı sırasında belirli bir deneğin neyi gözlemlediğini belirlemelerine olanak tanır. Örneğin, filmlerdeki zıplama ve dönme gibi belirli eylem türleri insan beyninden doğru bir şekilde çözülebilirken, diğerleri (örneğin sürükleme)22 yapamaz. Benzer şekilde, birçok nesne türü fMRI yanıtlarından çözülebilse de, genel kategoriler daha zor görünmektedir. Beyin kod çözme insanlarla sınırlı değildir ve bilginin diğer türlerin beyinlerinde nasıl organize edildiğini anlamak için güçlü bir araç sağlar. İnsan olmayan primatlarla yapılan benzer fMRI deneyleri, temporal lobda canlılık ve bedensellik/bedensellik boyutları için farklı temsiller bulmuştur, bu da insanlardakine paraleldir23.

Köpeklerin doğal görsel uyaran temsillerini anlamaya yönelik ilk adım olarak, köpeğe uygun videolara verilen kortikal tepkileri ölçmek için MRI konusunda oldukça usta olan iki evcil köpekte uyanık fMRI kullanıldı. Bu çalışmada, bir köpek için potansiyel olarak daha fazla ekolojik geçerlilikleri ve video içeriğini köpek hareketiyle eşleştiren sinir ağları ile gösterdikleri başarı nedeniyle natüralist videolar kullanılmıştır24. Üç ayrı oturumda, her köpeğin 256 benzersiz video klibe verdiği yanıtlardan 90 dakikalık fMRI verileri elde edildi. Karşılaştırma için, aynı prosedür iki insan gönüllü üzerinde de uygulandı. Daha sonra, bir sinir ağı kullanarak, değişen sayıda sınıf kullanarak "nesneleri" (örneğin, insan, köpek, araba) veya "eylemleri" (örneğin, konuşma, yemek yeme, koklama) ayırt etmek için sınıflandırıcıları eğittik ve test ettik. Bu çalışmanın amaçları iki yönlüydü: 1) doğal video uyaranlarının köpek korteksinden çözülüp çözülemeyeceğini belirlemek; ve 2) eğer öyleyse, organizasyonun insanlarınkine benzer olup olmadığına dair bir ilk bakış sağlayın.

Protokol

Köpek çalışması, Emory Üniversitesi IACUC (PROTO201700572) tarafından onaylandı ve tüm sahipler, köpeklerinin çalışmaya katılımı için yazılı onay verdi. İnsan çalışma prosedürleri Emory Üniversitesi IRB tarafından onaylandı ve tüm katılımcılar taramadan önce yazılı onay verdi (IRB00069592).

1. Katılımcılar

- Çalışmada sunulan uyaranlara daha önce maruz kalmamış katılımcıları (köpekler ve insanlar) seçin.

NOT: Köpek katılımcıları, sahipleri tarafından fMRI eğitimine katılmak ve daha önce tarif edilenle tutarlı taramak için gönüllü olan iki yerel evcil köpekti7. Bhubo 4 yaşında bir erkek Boksör karışımıydı ve Daisy 11 yaşında bir dişi Boston terrier karışımıydı. Her iki köpek de daha önce birkaç fMRI çalışmasına katılmıştı (Bhubo: 8 çalışma, Daisy: 11 çalışma), bazıları tarayıcıdayken bir ekrana yansıtılan görsel uyaranları izlemeyi içeriyordu. Sahipleri görüş alanı dışındayken uzun süre hareket etmeden tarayıcıda kalma yetenekleri nedeniyle seçildiler. Çalışmaya iki insan (bir erkek, 34 yaşında ve bir kadın, 25 yaşında) da katıldı. Ne köpekler ne de insanlar bu çalışmada gösterilen uyaranlara daha önce maruz kalmamıştı.

2. Uyaranlar

- Elde taşınan bir dengeleyici gimbal üzerine monte edilmiş videoları (1920 piksel x 1440 piksel, saniyede 60 kare [fps]) çekin.

NOT: Bu çalışmada videolar 2019 yılında Atlanta, Georgia'da çekilmiştir.- Gimbal'ı yaklaşık diz yüksekliğinde tutarak "köpeğin gözünden" doğal videolar çekin. Videoları bir köpeğin hayatındaki günlük senaryoları yakalamak için tasarlayın.

NOT: Bunlar arasında yürüme, beslenme, oynama, insanların etkileşime girmesi (birbirleriyle ve köpeklerle), köpeklerin birbirleriyle etkileşime girmesi, hareket halindeki araçlar ve köpek olmayan hayvanlar yer almaktadır (Şekil 1A; Tamamlayıcı Film 1). Bazı kliplerde, videodaki denekler, örneğin okşama, koklama veya onunla oynama gibi doğrudan kamerayla etkileşime girerken, diğerlerinde kamera göz ardı edildi. Yerel olarak yerleştirilmiş bir kamera tuzağından (1920 piksel x 1080 piksel, 30 fps) ek geyik görüntüleri elde edildi. - Videoları 256 benzersiz 7 sn "sahne" halinde düzenleyin. Her sahne, insanların sarılması, koşan bir köpek veya yürüyen bir geyik gibi tek bir olayı tasvir ediyordu. Her sahneye benzersiz bir numara atayın ve içeriğine göre etiketleyin (aşağıya bakın).

- Gimbal'ı yaklaşık diz yüksekliğinde tutarak "köpeğin gözünden" doğal videolar çekin. Videoları bir köpeğin hayatındaki günlük senaryoları yakalamak için tasarlayın.

- Sahneleri, her biri yaklaşık 6 dakikalık beş büyük derleme videosunda düzenleyin. Çok çeşitli uyaranları sırayla sunmak için uzun bir film yerine derleme videoları kullanın.

NOT: Videolar tek bir uzun "çekimde" çekildiyse, çok çeşitli uyaranlar sunmak zor olurdu. Bu, insanlarda yapılan fMRI kod çözme çalışmaları ile tutarlıdır20,22. Ek olarak, kısa kliplerin derlemelerinin sunulması, tek bir uzun film yerine tek tek klipleri uzatmak mümkün olduğundan, eğitilen algoritmanın test edilebileceği bir saklama setinin daha kolay oluşturulmasına olanak sağladı (aşağıdaki bölüm 7, analizlere bakın). Dört derleme videosunda 51 benzersiz sahne vardı ve birinde 52 sahne vardı. Sahneler arasında herhangi bir ara veya boş ekran yoktu. - Her videonun köpekler, insanlar, araçlar, insan olmayan hayvanlar ve etkileşimler gibi tüm ana etiket kategorilerinden örnekler içerdiğinden emin olmak için sahneleri yarı rastgele seçin.

NOT: Derleme işlemi sırasında, MRI projektörünün çözünürlüğüyle eşleşmesi için tüm sahneler 30 fps'de 1920 piksel x 1080 piksele düşürüldü.

3. Deneysel tasarım

- MRI deliğinin arkasına monte edilmiş bir ekrana yansıtılan derleme videolarını izlerken katılımcıları bir 3T MRI tarayıcısında tarayın.

- Videoları ses olmadan oynatın.

- Köpekler için, başlarını burnun ortasından mandibulanın arkasına kadar alt çeneye kalıplanmış özel yapım bir çene desteğine yerleştirmek için önceden eğitim alarak başın sabit bir şekilde konumlandırılmasını sağlayın.

- Çene desteğini, bobini kaplayan ancak altındaki pençeler için yeterli alana izin veren ahşap bir rafa sabitleyin, bu da her köpeğin bir "sfenks" pozisyonu almasına neden olur (Şekil 1B). Hiçbir kısıtlama kullanılmadı. Eğitim protokolü hakkında daha fazla bilgi için, önceki uyanık fMRI köpek çalışmalarınabakın 7.

- Deneklerin oturum başına beş koşuya katılmasına izin verin, her koşu baştan sona izlenen ve rastgele bir sırayla sunulan bir derleme videodan oluşur. Köpekler için, her koşu arasında kısa molalar verin. Bu molalar sırasında köpeğe yiyecek ödülleri verin.

- Her deneğin 2 hafta boyunca üç oturuma katılmasına izin verin. Bu, deneğin beş benzersiz derleme videosunun her birini üç kez izlemesine olanak tanır ve kişi başına toplam 90 dakikalık bir fMRI süresi sağlar.

4. Görüntüleme

- Önceki uyanık fMRI köpek çalışmalarındakullanılanla tutarlı bir protokolü izleyerek köpek katılımcılarını tarayın 7,25.

- %20 boşluklu 22 ardışık 2,5 mm'lik dilim hacimleri elde etmek için tek çekimlik bir eko-düzlemsel görüntüleme dizisi kullanarak işlevsel taramalar elde edin (TE = 28 ms, TR = 1.430 ms, çevirme açısı = 70°, 64 x 64 matris, 2,5 mm düzlem içi voksel boyutu, FOV = 160 mm).

- Köpekler için, köpekler MRG'de "sfenks" pozisyonunda, boynu beyinle aynı hizada olacak şekilde otururken, faz kodlama yönü sağdan sola olacak şekilde dilimleri beyne dorsal olarak yönlendirin. Sağdan sola faz kodlaması, boyundan başın önüne kadar etrafı saran artefaktları önler. Ek olarak, tarama köpeklerindeki en büyük duyarlılık artefaktı frontal sinüsten gelir ve bu da frontal lobun bozulmasına neden olur.

- İnsanlar için, ön-arka yönde faz kodlamalı eksenel dilimler elde edin.

- Köpek taramalarıyla (aynı TR / TE) karşılaştırmaya izin vermek için, çok bantlı hızlanma faktörü 2 olan insanlar için çok bantlı dilim alımı (CMRR, Minnesota Üniversitesi) kullanın (GRAPPA = 2, TE = 28 ms, TR = 1,430 ms, çevirme açısı = 55°, 88 x 88 matris, 2,5 mm düzlem içi voksel,% 20 boşluklu kırk dört 2,5 mm dilim).

- Köpekler için, 1,5 mm izotropik voksellere sahip bir turbo spin-eko dizisi kullanarak her katılımcı için tüm beynin T2 ağırlıklı bir yapısal görüntüsünü elde edin. İnsan katılımcılar için, 1 mm izotropik voksel içeren T1 ağırlıklı bir MPRAGE dizisi kullanın.

NOT: Üç oturum boyunca, her katılımcı için yaklaşık 4.000 işlevsel cilt elde edildi.

5. Uyaran etiketleri

- Videolarda sunulan içeriği sınıflandırmak için bir modeli eğitmek için önce sahneleri etiketleyin. Bunu yapmak için, her bir derleme videosunu oluşturan 7 s'lik sahneleri 1,4 sn'lik kliplere bölün. Tek tek kareler yerine kısa klipleri etiketleyin, çünkü hareketsiz kareler tarafından yakalanamayan video öğeleri vardır, bunlardan bazıları köpekler için özellikle dikkat çekici olabilir ve bu nedenle hareket gibi kod çözmede yararlı olabilir.

NOT: 1,4 s'lik bir klip uzunluğu seçildi çünkü bu, bu dinamik öğeleri yakalamak için yeterince uzundu ve 1,43 s'lik TR ile yakından eşleşti, bu da sınıflandırmanın hacim bazında yapılmasına izin veriyor. - Bu 1,4 sn'lik klipleri (n = 1.280) laboratuvar üyelerine rastgele dağıtın ve her klibi önceden programlanmış bir onay kutusu stili gönderme formu kullanarak manuel olarak etiketleyin.

NOT: Videolar arasında özne (ör. köpek, insan, kedi), denek sayısı (1, 2, 3+), nesneler (ör. araba, bisiklet, oyuncak), eylemler (ör. yemek yeme, koklama, konuşma), etkileşimler (ör. insan-insan, insan-köpek) ve ortam (iç mekan, dış mekan) dahil olmak üzere videoların mümkün olduğunca çok sayıda temel özelliğini kapsayacak şekilde 94 etiket seçilmiştir. Bu, her klip için 94 boyutlu bir etiket vektörü üretti (Ek Tablo 1). - Tutarlılık denetimi olarak, ikinci bir laboratuvar üyesi tarafından yeniden etiketlemek için rastgele bir alt küme seçin. Burada, etiketlerin bireyler arasında oldukça tutarlı olduğu bulundu (%>95). Tutarlı olmayan etiketler için, iki laboratuvar üyesinin söz konusu klibi yeniden izlemesine ve etiket üzerinde fikir birliğine varmasına izin verin.

- Her çalıştırma için, ilk tarama hacmine göre video uyaranının başlangıcını belirlemek için zaman damgalı günlük dosyalarını kullanın.

- Uyaran sunumu ile BOLD yanıtı arasındaki gecikmeyi hesaba katmak için, etiketleri bir çift gama hemodinamik yanıt fonksiyonu (HRF) ile birleştirin ve Python fonksiyonlarını numpy.convolve() ve interp() kullanarak işlevsel görüntülerin TR'sine (1.430 ms) enterpolasyon yapın.

NOT: Sonuç, her katılımcı için toplam tarama hacmi sayısına göre birleştirilmiş etiketlerden oluşan bir matristi (Daisy, Bhubo, Human 1 ve Human 2 için sırasıyla 94 etiket x 3.932, 3.920, 3.939 ve 3.925 cilt). - Daha fazla analiz için makro etiketler oluşturmak üzere bu etiketleri gerektiği yerlerde gruplandırın. Örneğin, bir "yürüyüş" etiketi oluşturmak için tüm yürüme örneklerini (köpek gezdirme, insan yürüyüşü, eşek yürüyüşü) birleştirin.

- Etiket kümesindeki fazlalığı daha da ortadan kaldırmak için, yüksek oranda ilişkili olduğu açık olan makro etiketler hariç olmak üzere her etiket için varyans enflasyon faktörünü (VIF) hesaplayın.

NOT: VIF, öngörücü değişkenlerdeki çoklu doğrusallığın bir ölçüsüdür ve her bir öngörücünün birbirine karşı gerilemesiyle hesaplanır. Daha yüksek VIF'ler daha yüksek korelasyonlu öngörücüleri gösterir. Bu çalışma, 94 etiketi 52 benzersiz, büyük ölçüde ilişkisiz etikete indirgeyen 2'lik bir VIF eşiği kullanmıştır (Ek Tablo 1).

6. fMRI ön işleme

- Ön işleme, AFNI paketi (NIH) ve ilgili işlevleri26,27 kullanarak hareket düzeltme, sansürleme ve normalleştirmeyi içerir. Hacimleri, katılımcının koşular boyunca ortalama baş pozisyonunu temsil eden bir hedef hacme hizalamak için iki geçişli, altı parametreli sert gövdeli hareket düzeltmesi kullanın.

- Taramalar arasında 1 mm'den fazla yer değiştirmeye sahip hacimlerin yanı sıra aykırı voksel sinyal yoğunluğu %0,1'den fazla olan hacimleri kaldırmak için sansür uygulayın. Her iki köpek için de sansürlemeden sonra hacimlerin %80'inden fazlası korundu ve insanlar için %90'dan fazlası korundu.

- Tek tek voksellerin sinyal-gürültü oranını iyileştirmek için, 3dmerge ve tam genişlikte yarı maksimumda 4 mm Gauss çekirdeği kullanarak hafif uzamsal yumuşatma gerçekleştirin.

- Uyarana göre farklılık gösterebilen hareket veya hız gibi düşük seviyeli görsel özelliklerin etkisini kontrol etmek için, video kliplerin22,28 ardışık kareleri arasındaki optik akışı hesaplayın. Saniyede 10 kareye kadar altörneklemeden sonra OpenCV'deki Farneback algoritmasını kullanarak optik akışı hesaplayın29.

- Her karedeki hareket enerjisini tahmin etmek için, her pikselin optik akışının karelerinin toplamını hesaplayın ve sonucun karekökünü alın, bir kareden diğerine28,30 Öklid ortalama optik akışını etkin bir şekilde hesaplayın. Bu, her derleme videosu için zaman rotaları hareket enerjisi üretir.

- Bunları, fMRI verilerinin zamansal çözünürlüğüne uyacak şekilde yeniden örnekleyin, yukarıdaki gibi bir çift gama hemodinamik yanıt fonksiyonu (HRF) ile birleştirildi ve her denek için uyaran sunumuyla uyumlu olacak şekilde birleştirildi.

- Bu zaman seyrini, yukarıda açıklanan hareket düzeltmesinden oluşturulan hareket parametreleriyle birlikte, AFNI'nin 3dDeconvolve'u ile her voksel için tahmin edilen genel bir doğrusal modele (GLM) tek regresör olarak kullanın. Bu modelin artıklarını aşağıda açıklanan makine öğrenimi algoritmasına giriş olarak kullanın.

7. Analizler

- Beynin görsel uyaranların sınıflandırılmasına önemli ölçüde katkıda bulunan bölgelerinin kodunu çözün ve her bir katılımcı için daha sonra katılımcıların beyin verilerine dayalı olarak video içeriğini sınıflandırmak için kullanılabilecek bir model eğitin. Yüksek boyutlu biyolojik veriler üzerinde başarı gösteren, Siyam sinir ağlarına (SNN'ler) dayalı doğrusal olmayan bir yöntem olan Ivis makine öğrenimi algoritmasını kullanın31.

NOT: SNN'ler, denetimli veya denetimsiz modlardaki girişlerin benzerliğini öğrenmek için kullanılan iki özdeş alt ağ içerir. Sinir ağları, destek vektör makineleri (SVM'ler) gibi doğrusal yöntemler üzerinde genellikle daha fazla güce sahip olmaları nedeniyle beyin kod çözme için popülerlik kazanmış olsa da, sınıf dengesizliğine karşı sağlamlığı ve daha az örneğe ihtiyaç duyması nedeniyle burada bir SNN kullandık. Aynı veriler üzerinde eğitilen destek vektör makineleri (SVM) ve rastgele orman (RF) sınıflandırıcıları ile karşılaştırıldığında, Ivis'in ortalama F1 puanı, kesinlik, hatırlama ve test doğruluğu dahil olmak üzere çeşitli metriklerle belirlendiği gibi beyin verilerini birden fazla etiket kombinasyonunda sınıflandırmada daha başarılı olduğunu bulduk (aşağıya bakın). - Her katılımcı için, tüm beyin artıklarını Ivis sinir ağına giriş için uygun bir formata dönüştürün. Üç oturumun her birinde beş çalıştırmayı birleştirin ve maskeleyin, yalnızca beyin voksellerini koruyun.

- Uzamsal boyutu düzleştirin, böylece zamana göre iki boyutlu bir voksel matrisi elde edin.

- Her çalıştırmada gösterilen videoların çarpık etiketlerini birleştirin, böylece fMRI çalıştırmalarına karşılık gelir.

- Hem fMRI verilerini hem de ilgili etiketleri, ön işlemede işaretlenen birimlere göre sansürleyin.

- Kodu çözülecek hedef etiketleri seçin (bundan böyle "sınıflar" olarak anılacaktır) ve yalnızca bu sınıfları içeren birimleri saklayın. Basitlik için, sınıfları birbirini dışlayan olarak ele alın ve kod çözme için birden çok sınıfa ait birimleri içermeyin, yalnızca saf örnekler bırakın.

- Verileri eğitim ve test kümelerine bölün. Test seti olarak hareket etmek için sahnelerin %20'sini rastgele seçerek beşe bölünmüş bir bölme kullanın.

NOT: Bu, test seti için belirli bir sahne seçildiğinde, bu sahne sırasında elde edilen tüm kliplerin ve işlevsel hacimlerin eğitim setinden çıkarıldığı anlamına gelir. Bölme sahneden bağımsız olarak gerçekleştirilmiş olsaydı, aynı sahneden ciltler hem eğitim setinde hem de test setinde görünecekti ve sınıflandırıcının bunları sınıflandırmada başarılı olması için yalnızca o belirli sahneyle eşleştirmesi gerekecekti. Bununla birlikte, yeni sahnelerden tutulan birimleri doğru bir şekilde sınıflandırmak için, sınıflandırıcının bunları daha genel, sahneden bağımsız bir sınıfla eşleştirmesi gerekiyordu. Bu, sınıflandırıcının başarısının genelleştirilebilirliğinin, tek tek klipleri tutmaya kıyasla daha sağlam bir testiydi. - scikit-learn paketini kullanarak en küçük sınıfınkiyle eşleşecek şekilde her sınıftaki hacim sayısını az örnekleyerek eğitim setini dengeleyin.

- Her katılımcı için, her seferinde benzersiz bir test-tren ayrımı kullanarak Ivis algoritmasını 100 yinelemede eğitin ve test edin (Ivis parametreleri: k = 5, model = "maaten", n_epochs_without_progress = 30, supervision_weight = 1). Bu parametre değerleri, algoritmanın yazarları tarafından belgelerinde32 önerildiği gibi veri kümesi boyutu ve karmaşıklığı temelinde büyük ölçüde seçilmiştir. "İlerleme kaydedilmemiş dönem sayısı" ve "denetim ağırlığı" (denetimsiz için 0, denetimli için 1) modeli optimize etmek için ek parametre ayarlamasına tabi tutuldu.

- Sınıflandırıcıyı tüm beyinden yalnızca en bilgilendirici voksellere eğitmek için kullanılan özelliklerin sayısını azaltmak için, her bir vokseli özellik önemine göre sıralamak için scikit-learn kullanarak rastgele bir orman sınıflandırıcısı (RFC) kullanın.

NOT: RFC kendi başına şansın üzerinde performans göstermese de, Ivis algoritmasına yalnızca gürültüye katkıda bulunacak olan bilgilendirici olmayan vokselleri elemek gibi yararlı bir amaca hizmet etti. Bu, sınıflandırıcı33'e geçmeden önce özellik seçimi için F-testlerini kullanmaya benzer. Eğitim setindeki voksellerin yalnızca ilk %5'i eğitim ve testte kullanıldı. Sinir ağını eğitmeden önce bilgilendirici olmayan voksel sayısını azaltmak amacıyla tercih edilen voksel sayısı konservatif eşik olarak %5 olarak seçildi. Daha büyük bir voksel oranı kullanıldığında hem insanlar hem de köpekler için niteliksel olarak benzer sonuçlar elde edildi. İnsan beyni köpek beyinlerinden daha büyük olmasına rağmen, insan modelleri, köpek modellerinde bulunanlara eşit, voksellerin %5'inden çok daha küçük olan mutlak sayıda voksel üzerinde eğitildiğinde de başarılı olmuştur (~ 250 voksel; tümü ortalama LRAP puanları >99. yüzdelik dilim). Tutarlılık için, bu nedenle, her iki tür için de voksellerin ilk %5'ini kullanarak sonuçları sunuyoruz. - 100 koşunun tamamında ortalama %5'lik en bilgilendirici vokselleri normalleştirin, her katılımcının yapısal alanına ve ardından grup atlas alanına (atlaslar: insanlar34 ve köpekler35) dönüştürün ve her tür için katılımcılar arasında toplayın. Atlasların üzerine özellik önemini yerleştirin ve ITK-SNAP36 kullanarak önem puanına göre renklendirin.

Sonuçlar

Makine öğrenimi analizlerinde model performansını değerlendirmek için en yaygın metrikler arasında hassasiyet, doğruluk, geri çağırma ve F1 puanı yer alır. Doğruluk, doğru veriler göz önüne alındığında doğru olan model tahminlerinin genel yüzdesidir. Kesinlik, modelin gerçekten pozitif olan pozitif tahminlerinin yüzdesidir (yani, gerçek pozitif oran), hatırlama ise modelin başarılı bir şekilde tahmin edebildiği orijinal verilerdeki gerçek pozitiflerin yüzdesidir. F1 puanı, hassasiyet ve geri çağırmanın ağırlıklı ortalamasıdır ve sınıf dengesizliğine karşı daha sağlam olan alternatif bir doğruluk ölçüsü görevi görür. Bununla birlikte, Ivis, çıktısının ikili olmaması nedeniyle yaygın olarak kullanılan diğer makine öğrenimi algoritmalarından farklıdır. Belirli bir beyin voksel girdisi verildiğinde, her çıktı elemanı, sınıfların her birine karşılık gelen olasılıkları temsil eder. Bu çıktılar için doğruluk, kesinlik, geri çağırma ve F1'in hesaplanması, bunların "kazanan her şeyi alır" şeklinde ikili hale getirilmesini gerektiriyordu, burada en yüksek olasılığa sahip sınıf, o hacim için tahmin edilen sınıf olarak kabul edildi. Bu yaklaşım, modelin kalitesini değerlendirmekle ilgili olan bu olasılıkların sıralaması hakkında önemli bilgileri ortadan kaldırdı. Bu nedenle, bu geleneksel metrikleri hesaplamaya devam ederken, test setindeki modelin doğruluğunu hesaplamak için birincil metrik olarak Etiket Sıralaması Ortalama Hassasiyet (LRAP) puanını kullandık. Bu metrik, esasen sınıflandırıcının gerçek etiketlere ne ölçüde daha yüksek olasılıklar atadığınıölçer 37.

Farklı derecelerde, sinir ağı sınıflandırıcısı hem insanlar hem de köpekler için başarılı oldu. İnsanlar için algoritma, her ikisi için de ortalama %70'lik bir doğruluk elde eden üç sınıflı modellerle hem nesneleri hem de eylemleri sınıflandırabildi. LRAP skoru, test setindeki modelin doğruluğunu hesaplamak için birincil metrik olarak kullanıldı; Bu metrik, sınıflandırıcının gerçek etiketlere ne ölçüde daha yüksek olasılıklar atadığınıölçer 37. Her iki insan için de medyan LRAP puanları, test edilen tüm modeller için rastgele permütasyona tabi tutulmuş bir etiket setinin 99. yüzdelik diliminden daha büyüktü (Tablo 1; Şekil 2). Köpekler için, yalnızca eylem modeli, her iki katılımcıda da şanstan önemli ölçüde daha yüksek bir medyan LRAP yüzdelik sıralamasına sahipti (Tablo 1; nesneler için p = 0.13 ve eylemler için p < 0.001; köpekler için ortalama üç sınıflı eylem modeli LRAP puanı = 78. yüzdelik dilim). Bu sonuçlar, tüm denekler için ayrı ayrı ve türlere göre gruplandırıldığında doğruydu.

Sınıflandırıcının başarısı göz önüne alındığında, modelin sınırlarını belirlemek için ek sınıflarla eğittik ve test ettik. Bu, Python paketi scipy'nin hiyerarşik kümeleme algoritmasını kullanarak, ikili korelasyon ile tanımlandığı gibi, bir bireyin beyin tepkisinin benzerliğine dayalı olarak sınıfları kümeleyen 52 potansiyel ilgi sınıfının tamamı için farklılık matrislerinin hesaplanmasını içeriyordu. Test edilen ek modellerden, her iki köpekte de en yüksek medyan LRAP yüzdelik sıralamasına sahip modelin beş sınıfı vardı: orijinal "konuşma", "yeme" ve "koklama", artı iki yeni sınıf, "sevişme" ve "oynama" (Şekil 2). Bu model, tüm katılımcılar için şans eseri tahmin edilenden önemli ölçüde daha yüksek bir medyan LRAP yüzdelik sıralamasına sahipti (Tablo 1; p < hem köpekler hem de insanlar için 0.001; köpekler için ortalama beş sınıflı eylem modeli LRAP puanı = 81. yüzdelik dilim).

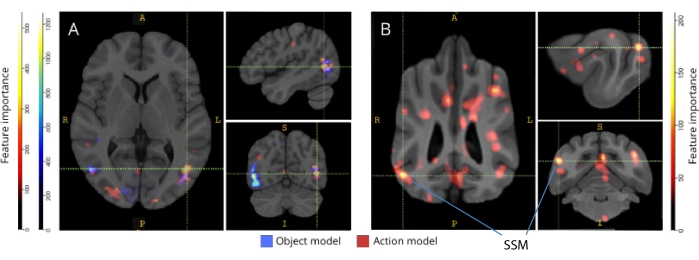

İlgili beyin atlaslarına geri eşlendiğinde, voksellerin özellik önem puanları, hem köpeklerin hem de insanların oksipital, parietal ve temporal kortekslerinde bir dizi bilgilendirici voksel kümesini ortaya çıkardı (Şekil 3). İnsanlarda, nesne tabanlı ve eylem tabanlı modeller, nesne tabanlı voksellerin ve eylem tabanlı voksellerin uzamsal konumunda küçük farklılıklar olmasına rağmen, köpeklerden ve tipik olarak nesne tanıma ile ilişkili bölgelerden daha odaklı bir model ortaya çıkardı.

Bu tür farklılıklarının, köpeklerin bazı video türlerine diğerlerinden daha fazla hareket etmelerinin görevle ilişkili hareketinin bir sonucu olmadığını kontrol ettik (örneğin, köpekler dışındaki videolar, örneğin arabalar). Altı hareket parametresinin Öklid normunu hesapladık ve R paketi lme4'ü kullanarak, sabit bir etki olarak sınıf ve her köpek için rastgele bir etki olarak çalışma sayısı ile doğrusal bir karma etki modeli uydurduk. Son modellerin her biri için, Daisy (F(2, 2252) = 0.83, nesne tabanlı için p = 0.44 ve F(4, 1235) = 1.87, eylem tabanlı için p = 0.11) veya Bhubo (F(2, 2231) = 1.71, nesne tabanlı için p = 0.18 ve F(4, 1221) = 0.94, eylem tabanlı için p = 0.45) için sınıf türünün hareket üzerinde anlamlı bir etkisi bulamadık.

Şekil 1: MRG deliğinde natüralist videolar ve sunum. (A) Katılımcılara gösterilen video kliplerden örnek kareler. (B) 4 yaşında bir Boxer karışımı olan Bhubo, uyanık fMRI geçirirken video izliyor. Bu rakamın daha büyük bir sürümünü görüntülemek için lütfen buraya tıklayın.

Şekil 2: Köpeklerde ve insanlarda model performansı. Boş dağılımlarının yüzdelik sıralamaları olarak sunulan LRAP puanlarının dağılımı, üç sınıflı nesne tabanlı bir model, üç sınıflı eylem tabanlı model ve beş sınıflı eylem tabanlı model için Ivis makine öğrenimi algoritmasının 100'den fazla eğitim ve test yinelemesi, modellerin aracılığıyla elde edilen doğal video uyaranlarına BOLD yanıtlarını sınıflandırmaya çalıştığı beş sınıflı eylem tabanlı model köpeklerde ve insanlarda uyanık fMRI. Puanlar türlere göre toplanır. Çok yüksek bir yüzdelik sıralamaya sahip bir LRAP puanı, modelin bu LRAP puanını şans eseri elde etme olasılığının çok düşük olduğunu gösterir. Şanstan daha iyi performans göstermeyen bir model, ~50 medyan LRAP puanı yüzdelik sıralamasına sahip olacaktır. Kesikli çizgiler, 100 çalıştırmanın tamamında her tür için medyan LRAP puanı yüzdelik sıralamasını temsil eder. Bu rakamın daha büyük bir sürümünü görüntülemek için lütfen buraya tıklayın.

Şekil 3: Üç sınıflı nesne ve beş sınıflı eylem modellerinin ayrımı için önemli bölgeler. (A) İnsan ve (B) köpek katılımcıları. Vokseller, modellerin tüm yinelemelerinde ortalaması alınan rastgele bir orman sınıflandırıcısı kullanılarak özellik önemlerine göre sıralandı. Voksellerin ilk %5'i (yani, modelleri eğitmek için kullanılanlar) burada sunulmakta, türlere göre toplanmış ve görselleştirme amacıyla grup alanına dönüştürülmüştür (atlaslar: insanlar34 ve köpekler35). Etiketler, Johnson ve ark.35 tarafından tanımlananlara dayanarak, yüksek özellik önem puanlarına sahip köpek beyin bölgelerini gösterir. Kısaltma: SSM = suprasylvian gyrus. Bu rakamın daha büyük bir sürümünü görüntülemek için lütfen buraya tıklayın.

| Model Türü | Eğitim Doğruluğu | Test Doğruluğu | F1 Skoru | Kesinlik | Anımsamak | LRAP puanı medyan yüzdelik dilim | |

| İnsan 1 | Nesne (3 sınıf) | 0.98 | 0.69 | 0.48 | 0.52 | 0.49 | >99 |

| Eylem (3 sınıf) | 0.98 | 0.72 | 0.51 | 0.54 | 0.54 | >99 | |

| Eylem (5 sınıf) | 0.97 | 0.51 | 0.28 | 0.37 | 0.27 | >99 | |

| İnsan 2 | Nesne (3 sınıf) | 0.98 | 0.68 | 0.45 | 0.5 | 0.47 | >99 |

| Eylem (3 sınıf) | 0.98 | 0.69 | 0.46 | 0.5 | 0.48 | >99 | |

| Eylem (5 sınıf) | 0.97 | 0.53 | 0.3 | 0.4 | 0.27 | >99 | |

| Bhubo Belediyesi | Nesne (3 sınıf) | 0.99 | 0.61 | 0.38 | 0.41 | 0.39 | 57 |

| Eylem (3 sınıf) | 0.98 | 0.63 | 0.38 | 0.4 | 0.4 | 87 | |

| Eylem (5 sınıf) | 0.99 | 0.45 | 0.16 | 0.29 | 0.13 | 88 | |

| Papatya | Nesne (3 sınıf) | 1 | 0.61 | 0.38 | 0.43 | 0.39 | 43 |

| Eylem (3 sınıf) | 0.97 | 0.62 | 0.35 | 0.38 | 0.35 | 60 | |

| Eylem (5 sınıf) | 0.99 | 0.44 | 0.16 | 0.27 | 0.13 | 76 |

Tablo 1: Köpeklerde ve insanlarda uyanık fMRI yoluyla elde edilen doğal video uyaranlara BOLD yanıtları üzerinde 100'den fazla eğitim ve test yinelemesi olan Ivis makine öğrenimi algoritmasının toplu ölçümleri. Nesne modellerinin üç hedef sınıfı ("köpek", "insan", "araba") ve eylem modellerinin üç veya beş sınıfı vardı (üç sınıf: "konuşma", "yeme", "koklama"; beş sınıf: "konuşma", "yeme", "koklama", "sevişme", "oynama"). Şanstan önemli ölçüde büyük değerler kalın olarak gösterilir.

Ek Tablo 1: Sınıf etiketleri. Bu dosyayı indirmek için lütfen buraya tıklayın.

Ek Film 1: Örnek video klip. Bu dosyayı indirmek için lütfen buraya tıklayın.

Tartışmalar

Bu çalışmanın sonuçları, natüralist videoların köpeklerin beyinlerinde, hem insanlarda hem de maymunlarda elde edilen sonuçlara benzer şekilde fMRI ile çözülebilecek kadar çoklu görüntüleme seanslarında yeterince kararlı temsillere neden olduğunu göstermektedir20,23. Köpek görsel sisteminin önceki fMRI çalışmaları, nötr bir arka plana karşı bir yüz veya nesne gibi sadeleştirilmiş uyaranlar sunmuş olsa da, buradaki sonuçlar, birden fazla insan ve nesnenin birbiriyle etkileşime girdiği doğal videoların, köpek korteksinde aktivasyon modellerine neden olduğunu göstermektedir. Bu yaklaşım, köpeğin görsel sisteminin nasıl organize edildiğine dair yeni araştırma yolları açar.

Köpek fMRI alanı hızla büyümüş olsa da, bugüne kadar bu deneyler, nötr arka planlara karşı insan veya nesne resimleri gibi nispeten fakir uyaranlara dayanıyordu 10,12,13. Ek olarak, bu deneyler, yüz işlemede yer alan primat fusiform yüz alanına (FFA) ve nesne işleme için lateral oksipital kortekse (LOC) benzer beyin bölgelerini tanımlamaya başlamış olsa da, köpeklerin primatlarla benzer göze çarpan özelliklere yanıt veren yüz bölgelerine sahip olup olmadığı veya köpekler ve insanlar veya yüzler ve kafalar için ayrı temsilleri olup olmadığı gibi bu temsillerin doğası üzerinde anlaşmazlık devam etmektedir. Örneğin 9,13. Köpekler elbette primat değiller ve bu yapay uyaranları sesler ve kokularla olağan çoklu duyusal bağlamlarından ayrı olarak nasıl yorumladıklarını bilmiyoruz. Bazı kanıtlar, köpeklerin nesnelerin görüntülerini gerçek şeylerin temsilleri olarak ele almadıklarını göstermektedir12. Tarayıcıda gerçek bir çoklu duyusal deneyim yaratmak mümkün olmasa da, natüralist videoların kullanılması, en azından bir köpeğe gerçek dünyayla daha yakından eşleşen dinamik uyaranlar sağlayarak yapaylığın bir kısmını azaltabilir. Aynı nedenlerden ötürü, insan fMRI araştırmalarında natüralist uyaranların kullanımı popülerlik kazanmıştır, örneğin, bir filmdeki olay dizilerinin kortekste birden fazla zaman ölçeğinde temsil edildiğini ve filmlerin güvenilir duygu aktivasyonunu indüklemede etkili olduğunu göstermiştir38. Bu nedenle, natüralist videolar nispeten fakir uyaranlar olarak kalırken, insan sinirbilimindeki başarıları, köpeklerde benzer sonuçların elde edilip edilemeyeceği sorusunu akla getiriyor.

Sonuçlarımız, bir sinir ağı sınıflandırıcısının, köpek beyinlerinden gelen bazı doğal içerik türlerinin kodunu çözmede başarılı olduğunu göstermektedir. Bu başarı, uyaranların karmaşıklığı göz önüne alındığında etkileyici bir başarıdır. Daha da önemlisi, sınıflandırıcı görünmeyen video klipler üzerinde test edildiğinden, kod çözme modeli, tek tek sahnelere özgü özellikler yerine klipler arasında tanımlanabilen geniş kategorileri aldı. Bir makine öğrenimi sınıflandırıcısının performansını ölçmek için birden fazla ölçüm olduğunu unutmamalıyız (Tablo 1). Natüralist videolar, doğaları gereği tüm sınıflar arasında eşit oluşumlara sahip olmayacağından, etiketlerin rastgele permütasyonundan boş bir dağılım oluşturarak ve buna atıfta bulunulan önemi değerlendirerek ihtiyatlı bir yaklaşım benimsedik. Daha sonra, köpek modellerinin başarısının istatistiksel olarak anlamlı olduğunu, 75. - 90. yüzdelik puanlara ulaştığını, ancak yalnızca videoların oyun oynama veya konuşma gibi mevcut eylemlere dayalı olarak kodlandığında bulduk.

Test setleri, eğitim setlerinden farklı olarak, sınıflar arasında dengeli değildi. Verilerin yalnızca %20'sini oluşturan, en küçük sınıf boyutuna yetersiz örnekleme, her sınıf için çok küçük örneklem boyutlarına neden olurdu, öyle ki hesaplanan herhangi bir istatistik güvenilmez olurdu. Bu dengesizlikten kaynaklanan şişirilmiş doğruluk olasılığını önlemek için, LRAP'ın boş dağılımı, her model yinelemesi için sınıfların sırasının 1.000 kez rastgele permütasyona tabi tutulmasıyla hesaplandı. Bu boş dağılım, modelin şans eseri ne kadar iyi performans göstereceğine dair bir referans görevi gördü. Daha sonra, gerçek LRAP daha sonra bu boş dağıtımda yüzdelik bir sıralamaya dönüştürüldü. Çok yüksek bir yüzdelik sıralama, örneğin, %95, bu kadar yüksek bir puanın 1.000 rastgele permütasyonda zamanın yalnızca %5'inde ortaya çıktığını gösterir. Bu nedenle, böyle bir modelin şansın çok üzerinde performans gösterdiği kabul edilebilir. Bu yüzdelik sıralamaların şans eseri beklenenden önemli ölçüde daha büyük olup olmadığını belirlemek için, yani istatistiksel olarak 50. yüzdelik dilim olmak üzere, her model için 100 yinelemenin tamamında medyan LRAP yüzdelik sıralaması hesaplandı ve tek örneklemli bir Wilcoxon işaretli sıra testi yapıldı.

Birincil amaç, köpekler için doğal görsel uyaranların bir kod çözücüsünü geliştirmek olsa da, insanlarla karşılaştırmalar kaçınılmazdır. Burada, iki büyük farka dikkat çekiyoruz: her bir sınıflandırıcı türü için, insan modelleri köpek modellerinden daha iyi performans gösterdi; Ve insan modelleri hem nesne hem de eylem tabanlı modeller için iyi performans gösterirken, köpek modelleri yalnızca eylem tabanlı için performans gösterdi. İnsan modellerinin üstün performansı birkaç faktöre bağlı olabilir. İnsan beyni, köpek beyninden yaklaşık 10 kat daha büyüktür, bu nedenle bir sınıflandırıcı oluşturmayı seçebileceğiniz daha fazla voksel vardır. Modelleri eşit bir temele oturtmak için, aynı sayıda voksel kullanılmalıdır, ancak bu mutlak veya göreceli anlamda olabilir. Nihai model, her beyindeki bilgilendirici voksellerin ilk %5'ine (göreceli bir ölçü) dayanmasına rağmen, sabit sayıda voksel kullanılarak benzer sonuçlar elde edildi. Bu nedenle, performans farklılıklarının insanların ve köpeklerin video uyaranlarını nasıl algıladıklarıyla ilgili olması daha muhtemel görünmektedir. Yukarıda belirtildiği gibi, köpekler ve insanlar algılarında çok duyusal olsa da, uyaranlar bir köpek için bir insandan daha fakir olabilir. Örneğin, boyut ipuçları kaybolabilir ve her şey gerçek dünyanın oyuncak versiyonu gibi görünebilir. Köpeklerin nesneleri şekilden önce boyut ve dokuya göre sınıflandırdığına dair bazı kanıtlar vardır, bu da insanların neredeyse tersidir39. Ek olarak, burada ele alınmayan koku, köpeklerde, özellikle türdeşlerin veya insanların tanımlanmasında, nesne ayrımcılığı için muhtemelen önemli bir bilgi kaynağıdır40,41,42. Bununla birlikte, boyut veya koku ipuçlarının yokluğunda bile, MRI tarayıcısının olağandışı ortamında, sınıflandırıcının hiç çalışmadığı gerçeği, köpeklerle ilgili beyinlerinden kurtarılabilecek bilgilerin hala olduğunu söylüyor. Sadece iki köpek ve iki insanla, tür farklılıkları bireysel farklılıklardan da kaynaklanıyor olabilir. Bununla birlikte, iki köpek, MRI ile eğitilmiş köpeklerin en iyisini temsil ediyordu ve video izlerken hareketsiz durma konusunda mükemmeldi. Daha büyük bir örneklem büyüklüğü, türler arasında daha güvenilir ayrımlar yapılmasına kesinlikle izin verirken, uyanık fMRI yapabilen ve yeterince uzun süre video izleyebilecek az sayıda köpek, tüm köpeklere genellenebilirliği her zaman sınırlayacaktır. Tazı gibi özel ırkların daha ince ayarlanmış görsel beyin tepkilerine sahip olması mümkün olsa da, bireysel mizaç ve eğitimin bir köpeğin beyninden neyin kurtarılabileceğinin ana belirleyicileri olma olasılığının daha yüksek olduğuna inanıyoruz.

Bu tür farklılıkları, köpeklerin videoların hangi yönüne dikkat ettiği sorusunu gündeme getiriyor. Bu soruyu yanıtlamanın bir yaklaşımı, daha basit video uyaranlarına dayanır. Daha sonra, insanların, köpeklerin ve arabaların izole edilmiş görüntülerini kullanarak, hem ayrı ayrı hem de nötr arka planlara karşı, göze çarpan boyutları bir köpeğe tersine çevirebiliriz. Bununla birlikte, bu hem metodolojik olarak verimsizdir hem de gerçek dünyadan gelen uyaranları daha da fakirleştirir. Dikkat sorunu, yalnızca kod çözme yaklaşımıyla, aslında, neyin ilgilenildiğini belirlemek için model performansını kullanarakçözülebilir 43. Bu doğrultuda, buradaki sonuçlar, insanların hem aktörlere hem de eylemlere katılırken, köpeklerin eylemlere daha fazla odaklandığını göstermektedir. Bu, bireylerin yemek yerken oynarken hareket sıklığı gibi düşük seviyeli hareket özelliklerindeki farklılıklardan kaynaklanabilir veya bu aktivitelerin daha yüksek bir seviyede kategorik bir temsilinden kaynaklanıyor olabilir. Bilgilendirici voksellerin köpeğin korteksi boyunca dağılımı, bu temsillerin sadece görsel bölgelerle sınırlı kalacak düşük seviyeli özellikler olmadığını göstermektedir. Daha geniş bir yelpazede video uyaranları kullanılarak yapılan daha fazla çalışma, köpekler tarafından kategori ayrımcılığında hareketin rolünü aydınlatabilir.

Özetle, bu çalışma, insan korteksi için yapıldığı gibi fMRI kullanarak köpek korteksinden doğal görsel bilgilerin kurtarılmasının fizibilitesini göstermiştir. Bu gösteri, ses veya koku olmasa bile, karmaşık sahnelerin göze çarpan boyutlarının köpeklerin video izlemesi tarafından kodlandığını ve bu boyutların beyinlerinden kurtarılabileceğini göstermektedir. İkincisi, bu tür bir görevi yapabilen az sayıda köpeğe dayanarak, bilgi kortekste insanlarda tipik olarak görülenden daha geniş bir şekilde dağıtılabilir ve eylem türleri, aktörlerin veya nesnelerin kimliğinden daha kolay kurtarılabilir gibi görünmektedir. Bu sonuçlar, köpeklerin video ekranları da dahil olmak üzere insanlarla paylaştıkları ortamları nasıl algıladıklarını incelemek için yeni bir yol açıyor ve kendilerinin ve diğer primat olmayan hayvanların dünyayı nasıl "gördüklerini" araştırmak için zengin yollar öneriyor.

Açıklamalar

Hiç kimse.

Teşekkürler

Bu analizin geliştirilmesindeki yardımcı görüşleri için Kate Revill, Raveena Chhibber ve Jon King'e, MRI için köpekleri işe alma ve eğitme konusundaki yardımı için Mark Spivak'a ve video oluşturma ve etiketleme konusundaki yardımı için Phyllis Guo'ya teşekkür ederiz. Ayrıca kendini işine adamış köpek sahiplerimiz Rebecca Beasley (Daisy) ve Ashwin Sakhardande'ye (Bhubo) teşekkür ederiz. İnsan çalışmaları, Ulusal Göz Enstitüsü'nden bir hibe ile desteklenmiştir (Grant R01 EY029724 D.D.D.'ye).

Malzemeler

| Name | Company | Catalog Number | Comments |

| 3 T MRI Scanner | Siemens | Trio | |

| Audio recordings of scanner noise | homemade | none | |

| Camera gimbal | Hohem | iSteady PRO 3 | |

| Dog-appropriate videos | homemade | none | |

| fMRI processing software | AFNI | 20.3.01 | |

| Mock scanner components | homemade | none | Mock head coil and scanner tube |

| Neural net software | Ivis | 1.7.1 | |

| Optical flow software | OpenCV | 4.2.0.34 | |

| Projection system for scanner | homemade | none | |

| Trophy Cam HD | Bushnell | 119874 | |

| Video camera | GoPro | HERO7 | |

| Visualization software | ITK-SNAP | 3.6.0 | |

| Windows Video Editor | Microsoft | Windows 11 version |

Referanslar

- Mishkin, M., Ungerleider, L. G., Macko, K. A. Object vision and spatial vision: Two cortical pathways. Trends in Neurosciences. 6, 414-417 (1983).

- de Haan, E. H. F., Cowey, A. On the usefulness of 'what' and 'where' pathways in vision. Trends in Cognitive Sciences. 15 (10), 460-466 (2011).

- Freud, E., Plaut, D. C., Behrmann, M. What' is happening in the dorsal visual pathway. Trends in Cognitive Sciences. 20 (10), 773-784 (2016).

- Goodale, M. A., Milner, A. D. Separate visual pathways for perception and action. Trends in Neurosciences. 15 (1), 20-25 (1992).

- Schenk, T., McIntosh, R. D. Do we have independent visual streams for perception and action? Do we have independent visual streams for perception and action. Cognitive Neuroscience. 1 (1), 52-78 (2010).

- Andics, A., Gácsi, M., Faragó, T., Kis, A., Miklós, Á Report voice-sensitive regions in the dog and human brain are revealed by comparative fMRI. Current Biology. 24 (5), 574-578 (2014).

- Berns, G. S., Brooks, A. M., Spivak, M. Functional MRI in awake unrestrained dogs. PLoS One. 7 (5), 38027(2012).

- Karl, S., et al. Training pet dogs for eye-tracking and awake fMRI. Behaviour Research Methods. 52, 838-856 (2019).

- Bunford, N., et al. Comparative brain imaging reveals analogous and divergent patterns of species and face sensitivity in humans and dogs. Journal of Neuroscience. 40 (43), 8396-8408 (2020).

- Cuaya, L. V., Hernández-Pérez, R., Concha, L. Our faces in the dog's brain: Functional imaging reveals temporal cortex activation during perception of human faces. PLoS One. 11 (3), 0149431(2016).

- Dilks, D. D., et al. Awake fMRI reveals a specialized region in dog temporal cortex for face processing. PeerJ. 2015 (8), 1115(2015).

- Prichard, A., et al. 2D or not 2D? An fMRI study of how dogs visually process objects. Animal Cognition. 24 (5), 1143-1151 (2021).

- Thompkins, A. M., et al. Separate brain areas for processing human and dog faces as revealed by awake fMRI in dogs (Canis familiaris). Learning & Behavior. 46 (4), 561-573 (2018).

- Zhang, K., Sejnowski, T. J. A universal scaling law between gray matter and white matter of cerebral cortex. Proceedings of the National Academy of Sciences of the United States of America. 97 (10), 5621-5626 (2000).

- Bradshaw, J., Rooney, N. Dog Social Behavior and Communication. The Domestic Dog: Its Evolution, Behavior and Interactions with People. Serpell, J. , Cambridge University Press. Cambridge, UK. 133-160 (2017).

- Prichard, A., et al. The mouth matters most: A functional magnetic resonance imaging study of how dogs perceive inanimate objects. The Journal of Comparative Neurology. 529 (11), 2987-2994 (2021).

- Haxby, J. V., Connolly, A. C., Guntupalli, J. S. Decoding neural representational spaces using multivariate pattern analysis. Annual Review of Neuroscience. 37, 435-456 (2014).

- Kamitani, Y., Tong, F. Decoding the visual and subjective contents of the human brain. Nature Neuroscience. 8 (5), 679-685 (2005).

- Kay, K. N., Naselaris, T., Prenger, R. J., Gallant, J. L. Identifying natural images from human brain activity. Nature. 452 (7185), 352-355 (2008).

- Nishimoto, S., et al. Reconstructing visual experiences from brain activity evoked by natural movies. Current Biology. 21 (19), 1641-1646 (2011).

- vander Meer, J. N., Breakspear, M., Chang, L. J., Sonkusare, S., Cocchi, L. Movie viewing elicits rich and reliable brain state dynamics. Nature Communications. 11 (1), 5004(2020).

- Huth, A. G., De Heer, W. A., Griffiths, T. L., Theunissen, F. E., Gallant, J. L. Natural speech reveals the semantic maps that tile human cerebral cortex. Nature. 532 (7600), 453-458 (2016).

- Kriegeskorte, N., et al. Matching categorical object representations in inferior temporal cortex of man and monkey. Neuron. 60 (6), 1126-1141 (2008).

- Ehsani, K., Bagherinezhad, H., Redmon, J., Mottaghi, R., Farhadi, A. Who let the dogs out? Modeling dog behavior from visual data. Proceedings of the IEEE Conference on Computer Vision and Pattern. 2018, 4051-4060 (2018).

- Berns, G. S., Brooks, A., Spivak, M. Replicability and heterogeneity of awake unrestrained canine fMRI responses. PLoS One. 9 (5), 98421(2013).

- Cox, R. W. AFNI: Software for analysis and visualization of functional magnetic resonance neuroimages. Computers and Biomedical Research. 29 (3), 162-173 (1996).

- Prichard, A., Chhibber, R., Athanassiades, K., Spivak, M., Berns, G. S. Fast neural learning in dogs: A multimodal sensory fMRI study. Scientific Reports. 8, 14614(2018).

- Russ, B. E., Kaneko, T., Saleem, K. S., Berman, R. A., Leopold, D. A. Distinct fMRI responses to self-induced versus stimulus motion during free viewing in the macaque. The Journal of Neuroscience. 36 (37), 9580-9589 (2016).

- Farnebäck, G. Two-Frame Motion Estimation Based on Polynomial Expansion. In Image Analysis. Scandinavian Conference on Image Analysis. Lecture Notes in Computer Science. Bigun, J., Gustavsson, T. 2749, Springer. Berlin, Heidelberg. 363-370 (2003).

- Elias, D. O., Land, B. R., Mason, A. C., Hoy, R. R. Measuring and quantifying dynamic visual signals in jumping spiders). Journal of Comparative Physiology A. 192, 799-800 (2006).

- Szubert, B., Cole, J. E., Monaco, C., Drozdov, I. Structure-preserving visualisation of high dimensional single-cell datasets. Scientific Reports. 9, 8914(2019).

- Tian, H., Tao, P. IVIS dimensionality reduction framework for biomacromolecular simulations. Journal of Chemical Information and Modeling. 60 (10), 4569-4581 (2020).

- Hebart, M. N., Gorgen, K., Haynes, J. The decoding toolbox (TDT): A versatile software package for multivariate analyses of functional imaging data. Frontiers in Neuroinformatics. 8, 88(2015).

- Mazziotta, J., et al. A probabilistic atlas and reference system for the human brain: International Consortium for Brain Mapping (ICBM). Philosophical Transactions of the Royal Society B: Biological Sciences. 356 (1412), 1293-1322 (2001).

- Johnson, P. J., et al. Stereotactic cortical atlas of the domestic canine brain. Scientific Reports. 10, 4781(2020).

- Yushkevich, P. A., et al. User-guided 3D active contour segmentation of anatomical structures: Significantly improved efficiency and reliability. NeuroImage. 31 (3), 1116-1128 (2006).

- Fürnkranz, J., Hüllermeier, E., Loza Mencía, E., Brinker, K. Multilabel classification via calibrated label ranking. Machine Learning. 73 (2), 133-153 (2008).

- Sonkusare, S., Breakspear, M., Guo, C. Naturalistic stimuli in neuroscience: Critically acclaimed. Trends in Cognitive Sciences. 23 (8), 699-714 (2019).

- vander Zee, E., Zulch, H., Mills, D. Word generalization by a dog (Canis familiaris): Is shape important. PLoS One. 7 (11), 49382(2012).

- Bekoff, M. Observations of scent-marking and discriminating self from others by a domestic dog (Canis familiaris): Tales of displaced yellow snow. Behavioural Processes. 55 (2), 75-79 (2001).

- Berns, G. S., Brooks, A. M., Spivak, M. Scent of the familiar: An fMRI study of canine brain responses to familiar and unfamiliar human and dog odors. Behavioural Processes. 110, 37-46 (2015).

- Schoon, G. A. A., de Bruin, J. C. The ability of dogs to recognize and cross-match human odours. Forensic Science International. 69 (2), 111-118 (1994).

- Kamitani, Y., Tong, F. Decoding seen and attended motion directions from activity in the human visual cortex. Current Biology. 16 (11), 1096-1102 (2006).

Yeniden Basımlar ve İzinler

Bu JoVE makalesinin metnini veya resimlerini yeniden kullanma izni talebi

Izin talebiThis article has been published

Video Coming Soon

JoVE Hakkında

Telif Hakkı © 2020 MyJove Corporation. Tüm hakları saklıdır