Method Article

À travers les yeux d’un chien : décodage par IRMf de vidéos naturalistes du cortex canin

Dans cet article

Résumé

Des algorithmes d’apprentissage automatique ont été entraînés à utiliser des modèles d’activité cérébrale pour « décoder » les stimuli présentés aux humains. Ici, nous démontrons que la même technique peut décoder du contenu vidéo naturaliste à partir du cerveau de deux chiens domestiques. Nous constatons que les décodeurs basés sur les actions dans les vidéos ont été efficaces chez les chiens.

Résumé

Les progrès récents utilisant l’apprentissage automatique et l’imagerie par résonance magnétique fonctionnelle (IRMf) pour décoder les stimuli visuels du cortex humain et non humain ont permis de mieux comprendre la nature de la perception. Cependant, cette approche n’a pas encore été appliquée de manière substantielle à d’autres animaux que les primates, ce qui soulève des questions sur la nature de ces représentations dans le règne animal. Ici, nous avons utilisé l’IRMf éveillée chez deux chiens domestiques et deux humains, obtenue pendant que chacun regardait des vidéos naturalistes spécialement créées pour les chiens. Nous avons ensuite entraîné un réseau neuronal (Ivis) à classer le contenu vidéo à partir d’un total de 90 minutes d’activité cérébrale enregistrée de chacun. Nous avons testé à la fois un classificateur basé sur les objets, qui tente de discriminer des catégories telles que chien, humain et voiture, et un classificateur basé sur l’action, qui tente de discriminer des catégories telles que manger, renifler et parler. Par rapport aux deux sujets humains, pour lesquels les deux types de classificateurs ont fonctionné bien au-dessus du hasard, seuls les classificateurs basés sur l’action ont réussi à décoder le contenu vidéo des chiens. Ces résultats démontrent la première application connue de l’apprentissage automatique pour décoder des vidéos naturalistes du cerveau d’un carnivore et suggèrent que la vision du monde à vue d’un chien peut être très différente de la nôtre.

Introduction

Le cerveau des humains, comme celui d’autres primates, démontre la fragmentation du flux visuel en voies dorsales et ventrales avec des fonctions distinctes et bien connues - le « quoi » et le « où » des objets1. Cette dichotomie quoi/où a été une heuristique utile pendant des décennies, mais sa base anatomique est maintenant connue pour être beaucoup plus complexe, de nombreux chercheurs privilégiant une parcellation basée sur la reconnaissance plutôt que l’action (« quoi » vs « comment »)2,3,4,5. De plus, alors que notre compréhension de l’organisation du système visuel des primates continue d’être affinée et débattue, beaucoup de choses restent inconnues sur la façon dont le cerveau d’autres espèces de mammifères représente l’information visuelle. Cette lacune est en partie le résultat de l’accent historique mis sur une poignée d’espèces dans les neurosciences visuelles. Cependant, de nouvelles approches de l’imagerie cérébrale ouvrent la possibilité d’étudier de manière non invasive les systèmes visuels d’un plus large éventail d’animaux, ce qui pourrait fournir de nouvelles connaissances sur l’organisation du système nerveux des mammifères.

Les chiens (Canis lupus familiaris) offrent une riche opportunité d’étudier la représentation des stimuli visuels chez une espèce éloignée des primates sur le plan de l’évolution, car ils peuvent être le seul animal qui peut être entraîné à participer en coopération à l’IRM sans avoir besoin de sédation ou de contention 6,7,8. En raison de leur coévolution avec les humains au cours des 15 000 dernières années, les chiens habitent également nos environnements et sont exposés à de nombreux stimuli auxquels les humains sont confrontés quotidiennement, y compris les écrans vidéo, qui sont la façon préférée de présenter les stimuli dans un scanner IRM. Même ainsi, les chiens peuvent traiter ces stimuli environnementaux communs d’une manière très différente de celle des humains, ce qui soulève la question de l’organisation de leur cortex visuel. Des différences fondamentales, telles que l’absence de fovéa ou le fait d’être dichromate, peuvent avoir des conséquences importantes en aval non seulement pour la perception visuelle de bas niveau, mais aussi pour la représentation visuelle de haut niveau. Plusieurs études d’IRMf chez le chien ont démontré l’existence de régions de traitement du visage et de l’objet qui semblent suivre l’architecture générale du flux dorsal/ventral observée chez les primates, bien qu’il ne soit pas clair si les chiens ont des régions de traitement du visage en soi ou si ces régions sont sélectives pour la morphologie de la tête (par exemple, chien vs humain)9. 10,11,12,13. Quoi qu’il en soit, le cerveau d’un chien, étant plus petit que celui de la plupart des primates, serait moins modulaire14, de sorte qu’il pourrait y avoir plus de mélange de types d’informations dans les flux ou même privilégier certains types d’informations, comme les actions. Il a été suggéré, par exemple, que le mouvement pourrait être une caractéristique plus saillante dans la perception visuelle canine que la texture ou la couleur15. De plus, comme les chiens n’ont pas de mains, l’un des principaux moyens par lesquels nous interagissons avec le monde, leur traitement visuel, en particulier des objets, peut être très différent de celui des primates. Dans le même ordre d’idées, nous avons récemment trouvé des preuves que l’interaction avec les objets par la bouche par rapport à la patte entraînait une plus grande activation dans les régions sélectives d’objets dans le cerveau du chien16.

Bien que les chiens soient habitués aux écrans vidéo dans leur environnement domestique, cela ne signifie pas qu’ils sont habitués à regarder des images dans un cadre expérimental de la même manière qu’un humain. L’utilisation de stimuli plus naturalistes peut aider à résoudre certaines de ces questions. Au cours de la dernière décennie, les algorithmes d’apprentissage automatique ont connu un succès considérable dans le décodage des stimuli visuels naturalistes de l’activité cérébrale humaine. Les premiers succès se sont concentrés sur l’adaptation de modèles classiques et bloqués pour utiliser l’activité cérébrale à la fois pour classer les types de stimuli qu’un individu voyait, ainsi que les réseaux cérébraux qui encodaient ces représentations 17,18,19. Au fur et à mesure que des algorithmes plus puissants ont été développés, en particulier des réseaux neuronaux, des stimuli plus complexes ont pu être décodés, y compris des vidéos naturalistes20,21. Ces classificateurs, qui sont généralement entraînés sur les réponses neuronales à ces vidéos, se généralisent à de nouveaux stimuli, ce qui leur permet d’identifier ce qu’un sujet particulier observait au moment de la réponse IRMf. Par exemple, certains types d’actions dans les films peuvent être décodés avec précision à partir du cerveau humain, comme sauter et tourner, tandis que d’autres (par exemple, glisser) ne le peuvent pas. De même, bien que de nombreux types d’objets puissent être décodés à partir des réponses IRMf, les catégories générales semblent plus difficiles. Le décodage cérébral ne se limite pas aux humains, fournissant un outil puissant pour comprendre comment l’information est organisée dans le cerveau d’autres espèces. Des expériences analogues d’IRMf avec des primates non humains ont trouvé des représentations distinctes dans le lobe temporal pour les dimensions de l’animation et de la facicité/corps, ce qui est parallèle à celui des humains23.

Comme première étape vers la compréhension des représentations des stimuli visuels naturalistes par les chiens, l’IRMf éveillée a été utilisée chez deux chiens domestiques très adeptes de l’IRM pour mesurer les réponses corticales à des vidéos adaptées aux chiens. Dans cette étude, des vidéos naturalistes ont été utilisées en raison de leur validité écologique potentiellement plus grande pour un chien et en raison de leur succès démontré avec des réseaux neuronaux qui associent le contenu vidéo au mouvement du chien24. Au cours de trois séances distinctes, 90 minutes de données d’IRMf ont été obtenues à partir des réponses de chaque chien à 256 clips vidéo uniques. À titre de comparaison, la même procédure a été réalisée sur deux volontaires humains. Ensuite, à l’aide d’un réseau neuronal, nous avons entraîné et testé des classificateurs pour discriminer soit des « objets » (par exemple, un humain, un chien, une voiture), soit des « actions » (par exemple, parler, manger, renifler) en utilisant un nombre variable de classes. Les objectifs de cette étude étaient doubles : 1) déterminer si les stimuli vidéo naturalistes pouvaient être décodés à partir du cortex du chien ; et 2) si c’est le cas, fournir un premier aperçu pour savoir si l’organisation était similaire à celle des humains.

Protocole

L’étude sur les chiens a été approuvée par l’IACUC de l’Université Emory (PROTO201700572), et tous les propriétaires ont donné leur consentement écrit pour la participation de leur chien à l’étude. Les procédures d’étude sur l’homme ont été approuvées par l’IRB de l’Université Emory, et tous les participants ont fourni un consentement écrit avant le balayage (IRB00069592).

1. Les participants

- Sélectionnez les participants (chiens et humains) qui n’ont jamais été exposés aux stimuli présentés dans l’étude.

REMARQUE : Les chiens participants étaient deux chiens de compagnie locaux proposés par leurs propriétaires pour participer à une formation et à un balayage IRMf conformes à ce qui a été décrit précédemment7. Bhubo était un boxer croisé mâle de 4 ans, et Daisy était une femelle Boston terrier mixte de 11 ans. Les deux chiens avaient déjà participé à plusieurs études d’IRMf (Bhubo : 8 études, Daisy : 11 études), dont certaines consistaient à regarder des stimuli visuels projetés sur un écran pendant qu’ils étaient dans le scanner. Ils ont été sélectionnés en raison de leur capacité démontrée à rester dans le scanner sans bouger pendant de longues périodes avec leur propriétaire hors de vue. Deux humains (un mâle de 34 ans et une femelle de 25 ans) ont également participé à l’étude. Ni les chiens ni les humains n’avaient été exposés auparavant aux stimuli montrés dans cette étude.

2. Les stimuli

- Filmez les vidéos (1920 pixels x 1440 pixels, 60 images par seconde [fps]) montées sur un cardan stabilisateur portable.

REMARQUE : Dans cette étude, les vidéos ont été filmées à Atlanta, en Géorgie, en 2019.- Filmez des vidéos naturalistes à partir d’une « vue d’œil de chien », en tenant le cardan à peu près à la hauteur du genou. Concevez les vidéos pour capturer des scénarios quotidiens dans la vie d’un chien.

REMARQUE : Il s’agit notamment de scènes de marche, de repas, de jeu, d’interaction entre humains (entre eux et avec des chiens), d’interactions entre chiens, de véhicules en mouvement et d’animaux non canins (figure 1A ; Film supplémentaire 1). Dans certains clips, les sujets de la vidéo interagissaient directement avec la caméra, par exemple en les caressant, en les reniflant ou en jouant avec, tandis que dans d’autres, la caméra était ignorée. Des images supplémentaires de cerfs ont été obtenues à partir d’un piège photographique placé localement (1920 pixels x 1080 pixels, 30 fps). - Modifiez les vidéos en 256 « scènes » uniques de 7 s. Chaque scène représentait un événement unique, comme des humains qui s’embrassent, un chien qui court ou un cerf qui se promène. Attribuez à chaque scène un numéro unique et étiquetez-la en fonction de son contenu (voir ci-dessous).

- Filmez des vidéos naturalistes à partir d’une « vue d’œil de chien », en tenant le cardan à peu près à la hauteur du genou. Concevez les vidéos pour capturer des scénarios quotidiens dans la vie d’un chien.

- Montez les scènes en cinq grandes vidéos de compilation d’environ 6 minutes chacune. Utilisez des vidéos de compilation plutôt qu’un long film pour présenter une grande variété de stimuli en séquence.

REMARQUE : Présenter une grande variété de stimuli serait difficile à réaliser si les vidéos étaient capturées en une seule longue « prise ». Ceci est cohérent avec les études de décodage de l’IRMf chez l’homme20,22. De plus, la présentation de compilations de courts clips a permis de créer plus facilement un ensemble de suspension sur lequel l’algorithme entraîné pouvait être testé (voir la section 7, analyses, ci-dessous), car il était possible de présenter les clips individuels au lieu d’un long film. Quatre vidéos de compilation comportaient 51 scènes uniques, et une en avait 52. Il n’y avait pas de pauses ou d’écrans vides entre les scènes. - Sélectionnez les scènes de manière semi-aléatoire pour vous assurer que chaque vidéo contient des exemples de toutes les principales catégories du label : chiens, humains, véhicules, animaux non humains et interactions.

REMARQUE : Au cours du processus de compilation, toutes les scènes ont été réduites à 1920 pixels x 1080 pixels à 30 ips pour correspondre à la résolution du projecteur IRM.

3. Conception expérimentale

- Scannez les participants dans un scanner IRM 3T tout en regardant les vidéos de compilation projetées sur un écran monté à l’arrière de l’alésage IRM.

- Lisez les vidéos sans son.

- Pour les chiens, obtenez un positionnement stable de la tête en suivant une formation préalable pour placer leur tête dans une mentonnière sur mesure, moulée à la mâchoire inférieure du milieu du museau à l’arrière de la mandibule.

- Fixez la mentonnière à une étagère en bois qui enjambe la bobine mais laisse suffisamment d’espace pour les pattes en dessous, ce qui permet à chaque chien d’adopter une position de « sphinx » (figure 1B). Aucune contrainte n’a été utilisée. Pour plus d’informations sur le protocole de dressage, voir les études précédentes sur l’IRMf éveillée chez le chien7.

- Laissez les sujets participer à cinq séries par session, chaque série consistant en une vidéo de compilation visionnée du début à la fin, présentée dans un ordre aléatoire. Pour les chiens, faites de courtes pauses entre chaque course. Offrez des récompenses alimentaires pendant ces pauses au chien.

- Laissez chaque sujet participer à trois séances sur 2 semaines. Cela permet au sujet de regarder chacune des cinq vidéos de compilation uniques trois fois, ce qui donne un temps total d’IRMf de 90 minutes par individu.

4. Imagerie

- Scanner les participants canins en suivant un protocole cohérent avec celui utilisé dans les études précédentes sur les chiens IRMf éveillés 7,25.

- Obtenez les balayages fonctionnels à l’aide d’une séquence d’imagerie écho-planaire à prise unique pour acquérir des volumes de 22 coupes séquentielles de 2,5 mm avec un écart de 20 % (TE = 28 ms, TR = 1 430 ms, angle de retournement = 70°, matrice 64 x 64, taille de voxel dans le plan de 2,5 mm, champ de vision = 160 mm).

- Pour les chiens, orientez les tranches dorsalement vers le cerveau avec le sens de codage de phase de droite à gauche, car les chiens sont assis dans l’IRM en position de « sphinx », avec le cou aligné avec le cerveau. L’encodage de phase de droite à gauche évite les artefacts enveloppants du cou vers l’avant de la tête. De plus, le principal artefact de sensibilité chez les chiens de balayage provient du sinus frontal, ce qui entraîne une distorsion du lobe frontal.

- Pour l’homme, obtenir des coupes axiales avec codage de phase dans le sens antéro-postérieur.

- Pour permettre la comparaison avec les balayages canins (même TR/TE), utilisez l’acquisition de tranches multibandes (CMRR, Université du Minnesota) pour les humains avec un facteur d’accélération multibande de 2 (GRAPPA = 2, TE = 28 ms, TR = 1 430 ms, angle de retournement = 55°, matrice 88 x 88, voxels dans le plan de 2,5 mm, quarante-quatre tranches de 2,5 mm avec un écart de 20 %).

- Pour les chiens, acquérez également une image structurelle pondérée T2 de l’ensemble du cerveau pour chaque participant à l’aide d’une séquence d’écho de spin turbo avec des voxels isotropes de 1,5 mm. Pour les participants humains, utilisez une séquence MPRAGE pondérée T1 avec des voxels isotropes de 1 mm.

REMARQUE : Au cours de trois sessions, environ 4 000 volumes fonctionnels ont été obtenus pour chaque participant.

5. Étiquettes de relance

- Afin d’entraîner un modèle à classer le contenu présenté dans les vidéos, étiquetez d’abord les scènes. Pour ce faire, divisez les scènes de 7 s qui composent chaque vidéo de compilation en clips de 1,4 s. Étiquetez les clips courts plutôt que les images individuelles, car il y a des éléments de la vidéo qui ne peuvent pas être capturés par des images fixes, dont certains peuvent être particulièrement saillants pour les chiens et, par conséquent, utiles pour le décodage, comme le mouvement.

REMARQUE : Une longueur de clip de 1,4 s a été choisie car elle était suffisamment longue pour capturer ces éléments dynamiques et correspondait étroitement au TR de 1,43 s, ce qui permet d’effectuer la classification volume par volume. - Distribuez au hasard ces clips de 1,4 s (n = 1 280) aux membres du laboratoire pour qu’ils étiquettent manuellement chaque clip à l’aide d’un formulaire de soumission de type case à cocher préprogrammé.

REMARQUE : 94 étiquettes ont été choisies pour englober le plus grand nombre possible de caractéristiques clés des vidéos, y compris les sujets (p. ex., chien, humain, chat), le nombre de sujets (1, 2, 3+), les objets (p. ex., voiture, vélo, jouet), les actions (p. ex., manger, renifler, parler), les interactions (p. ex., humain-humain, humain-chien) et le cadre (intérieur, extérieur), entre autres. Cela a produit un vecteur d’étiquetage en 94 dimensions pour chaque clip (tableau supplémentaire 1). - Dans le cadre d’une vérification de cohérence, sélectionnez un sous-ensemble aléatoire à réétiqueter par un deuxième membre du laboratoire. Ici, les étiquettes étaient très uniformes d’un individu à l’autre (>95 %). Pour les étiquettes qui n’étaient pas cohérentes, permettez aux deux membres du laboratoire de revoir le clip en question et de parvenir à un consensus sur l’étiquette.

- Pour chaque exécution, utilisez des fichiers journaux horodatés pour déterminer le début du stimulus vidéo par rapport au premier volume de balayage.

- Pour tenir compte du délai entre la présentation du stimulus et la réponse BOLD, convolutez les étiquettes avec une fonction de réponse hémodynamique gamma double (HRF) et interpolez au TR des images fonctionnelles (1 430 ms) à l’aide des fonctions Python numpy.convolve() et interp().

REMARQUE : Le résultat final a été une matrice d’étiquettes alvéolées en fonction du nombre total de volumes de balayage pour chaque participant (94 étiquettes x 3 932, 3 920, 3 939 et 3 925 volumes pour Daisy, Bhubo, Human 1 et Human 2, respectivement). - Regroupez ces étiquettes si nécessaire pour créer des macro-étiquettes pour une analyse plus approfondie. Par exemple, combinez toutes les instances de marche (promenade du chien, promenade humaine, promenade de l’âne) pour créer une étiquette « marche ».

- Pour éliminer davantage la redondance dans l’ensemble d’étiquettes, calculez le facteur d’inflation de la variance (VIF) pour chaque étiquette, à l’exclusion des macro-étiquettes, qui sont évidemment fortement corrélées.

REMARQUE : La VIF est une mesure de la multicolinéarité des variables prédictives, calculée en régressant chaque prédicteur par rapport à tous les autres. Des VIF plus élevés indiquent des prédicteurs plus fortement corrélés. Dans le cadre de cette étude, nous avons utilisé un seuil VIF de 2, ce qui a réduit les 94 étiquettes à 52 étiquettes uniques, en grande partie non corrélées (tableau supplémentaire 1).

6. Prétraitement de l’IRMf

- Le prétraitement implique la correction de mouvement, la censure et la normalisation à l’aide de la suite AFNI (NIH) et de ses fonctions associées26,27. Utilisez une correction de mouvement de corps rigide en deux passages et à six paramètres pour aligner les volumes sur un volume cible représentatif de la position moyenne de la tête du participant sur l’ensemble des courses.

- Effectuez une censure pour supprimer les volumes dont le déplacement entre les balayages est supérieur à 1 mm, ainsi que ceux dont l’intensité du signal de voxel aberrant est supérieure à 0,1 %. Pour les deux chiens, plus de 80 % des volumes ont été conservés après la censure, et pour les humains, plus de 90 % ont été conservés.

- Pour améliorer le rapport signal/bruit des voxels individuels, effectuez un léger lissage spatial à l’aide de 3dmerge et d’un noyau gaussien de 4 mm à mi-hauteur maximale.

- Pour contrôler l’effet des caractéristiques visuelles de bas niveau, telles que le mouvement ou la vitesse, qui peuvent différer en fonction du stimulus, calculez le flux optique entre les images consécutives des clips vidéo22,28. Calculez le flux optique à l’aide de l’algorithme Farneback dans OpenCV après sous-échantillonnage à 10 images par seconde29.

- Pour estimer l’énergie de mouvement dans chaque image, calculez la somme des carrés du flux optique de chaque pixel et prenez la racine carrée du résultat, en calculant effectivement le flux optique moyen euclidien d’une image à l’autre28,30. Cela génère des cours temporels d’énergie de mouvement pour chaque vidéo de compilation.

- Rééchantillonnez-les pour correspondre à la résolution temporelle des données IRMf, convolutées avec une double fonction de réponse hémodynamique gamma (HRF) comme ci-dessus et concaténées pour s’aligner sur la présentation du stimulus pour chaque sujet.

- Utilisez cette évolution temporelle, ainsi que les paramètres de mouvement générés par la correction de mouvement décrite ci-dessus, comme seuls régresseurs d’un modèle linéaire général (GLM) estimé pour chaque voxel avec 3dDeconvolve d’AFNI. Utilisez les valeurs résiduelles de ce modèle comme entrées dans l’algorithme d’apprentissage automatique décrit ci-dessous.

7. Analyses

- Décodez les régions du cerveau qui contribuent de manière significative à la classification des stimuli visuels, en formant un modèle pour chaque participant individuel qui peut ensuite être utilisé pour classer le contenu vidéo en fonction des données cérébrales des participants. Utilisez l’algorithme d’apprentissage automatique Ivis, une méthode non linéaire basée sur les réseaux de neurones siamois (SNN) qui a fait ses preuves sur des données biologiques de grande dimension31.

REMARQUE : Les SNN contiennent deux sous-réseaux identiques qui sont utilisés pour apprendre la similitude des entrées en mode supervisé ou non supervisé. Bien que les réseaux neuronaux aient gagné en popularité pour le décodage cérébral en raison de leur puissance généralement supérieure à celle des méthodes linéaires telles que les machines à vecteurs de support (SVM), nous avons utilisé un SNN ici en raison de sa robustesse au déséquilibre de classe et de la nécessité de moins d’exemples. Par rapport aux machines à vecteurs de support (SVM) et aux classificateurs de forêt aléatoire (RF) entraînés sur les mêmes données, nous avons constaté qu’Ivis réussissait mieux à classer les données cérébrales à travers plusieurs combinaisons d’étiquettes, telles que déterminées par diverses mesures, notamment le score F1 moyen, la précision, le rappel et l’exactitude du test (voir ci-dessous). - Pour chaque participant, convertissez les résidus du cerveau entier dans un format approprié pour la saisie dans le réseau neuronal Ivis. Concaténez et masquez les cinq passages dans chacune de leurs trois sessions, en ne conservant que les voxels du cerveau.

- Aplatir la dimension spatiale, ce qui donne une matrice bidimensionnelle de voxels par le temps.

- Concaténer les étiquettes convolutées des vidéos affichées à chaque passage, correspondant ainsi aux passages d’IRMf.

- Censurez à la fois les données IRMf et les étiquettes correspondantes en fonction des volumes signalés lors du prétraitement.

- Sélectionnez les libellés cibles à décoder, ci-après dénommés « classes », et ne conservez que les volumes contenant ces classes. Par souci de simplicité, traitez les classes comme mutuellement exclusives et n’incluez pas les volumes appartenant à plusieurs classes pour le décodage, ne laissant que des exemples purs.

- Divisez les données en ensembles d’entraînement et de test. Utilisez une division en cinq parties, en sélectionnant au hasard 20 % des scènes pour servir de jeu de test.

REMARQUE : Cela signifiait que, si une scène donnée était sélectionnée pour le jeu de test, tous les clips et volumes fonctionnels obtenus au cours de cette scène étaient conservés à partir du jeu d’entraînement. Si la scission avait été effectuée indépendamment de la scène, les volumes de la même scène seraient apparus à la fois dans l’ensemble d’apprentissage et dans l’ensemble de test, et le classificateur n’aurait eu qu’à les faire correspondre à cette scène particulière pour réussir à les classer. Cependant, pour classer correctement les volumes retenus à partir de nouvelles scènes, le classificateur devait les faire correspondre à une classe plus générale et indépendante de la scène. Il s’agissait d’un test plus robuste de la généralisabilité du succès du classificateur par rapport à la présentation de clips individuels. - Équilibrez l’ensemble d’apprentissage en sous-échantillonnant le nombre de volumes dans chaque classe pour qu’il corresponde à celui de la plus petite classe à l’aide du package scikit-learn imbalanced-learn.

- Pour chaque participant, entraînez et testez l’algorithme Ivis sur 100 itérations, à chaque fois à l’aide d’un découpage test-train unique (paramètres Ivis : k = 5, modèle = « maaten », n_epochs_without_progress = 30, supervision_weight = 1). Ces valeurs de paramètres ont été largement sélectionnées sur la base de la taille et de la complexité de l’ensemble de données, comme le recommandent les auteurs de l’algorithme dans sa documentation32. Le « Nombre d’époques sans progression » et le « poids de supervision » (0 pour non supervisé, 1 pour supervisé) ont fait l’objet d’un réglage supplémentaire des paramètres afin d’optimiser le modèle.

- Pour réduire le nombre de caractéristiques utilisées pour entraîner le classificateur de l’ensemble du cerveau aux voxels les plus informatifs, utilisez un classificateur de forêt aléatoire (RFC) à l’aide de scikit-learn pour classer chaque voxel en fonction de son importance de caractéristique.

REMARQUE : Bien que la RFC n’ait pas fonctionné au-dessus du hasard par elle-même, elle a servi à filtrer les voxels non informatifs, qui n’auraient contribué qu’au bruit de l’algorithme Ivis. Cela revient à utiliser des tests F pour la sélection des caractéristiques avant de passer au classificateur33. Seuls les 5 % des voxels les plus performants de l’ensemble d’entraînement ont été utilisés lors de l’entraînement et des tests. Le nombre préféré de voxels a été sélectionné à 5 % comme seuil conservateur dans le but de réduire le nombre de voxels non informatifs avant l’entraînement du réseau neuronal. Des résultats qualitativement similaires ont également été obtenus pour les humains et les chiens lors de l’utilisation d’une plus grande proportion de voxels. Bien que les cerveaux humains soient plus grands que les cerveaux de chiens, les modèles humains ont également réussi lorsqu’ils ont été entraînés sur un nombre absolu de voxels égal à ceux inclus dans les modèles de chiens, bien inférieur à 5 % des voxels (~250 voxels ; tous les scores moyens LRAP >99e centile). Par souci de cohérence, nous présentons donc les résultats en utilisant les 5 % supérieurs des voxels pour les deux espèces. - Normalisez la moyenne de 5 % des voxels les plus informatifs sur les 100 passages, transformez-les dans l’espace structurel de chaque participant, puis dans l’espace de l’atlas de groupe (atlas : humains34 et chiens35), et additionnez-les entre les participants pour chaque espèce. Superposez l’importance des caractéristiques sur les atlas et coloriez-les en fonction du score d’importance à l’aide d’ITK-SNAP36.

Résultats

Les mesures les plus courantes pour évaluer les performances d’un modèle dans les analyses de machine learning sont la précision, l’exactitude, la mémorisation et le score F1. La précision est le pourcentage global de prédictions du modèle qui sont correctes, compte tenu des données réelles. La précision est le pourcentage de prédictions positives du modèle qui sont réellement positives (c’est-à-dire le taux de vrais positifs), tandis que le rappel est le pourcentage de vrais positifs dans les données d’origine que le modèle est capable de prédire avec succès. Le score F1 est la moyenne pondérée de la précision et de la mémorisation et agit comme une mesure alternative de la précision qui est plus robuste au déséquilibre de classe. Cependant, l’Ivis diffère des autres algorithmes d’apprentissage automatique couramment utilisés en ce que sa sortie n’est pas binaire. Étant donné une entrée particulière de voxels cérébraux, chaque élément de sortie représente les probabilités correspondant à chacune des classes. L’exactitude de calcul, la précision, le rappel et la valeur F1 de ces sorties nécessitait de les binariser de manière à ce que le gagnant rafle tout, où la classe avec la probabilité la plus élevée était considérée comme celle prédite pour ce volume. Cette approche a éliminé des renseignements importants sur le classement de ces probabilités qui étaient pertinents pour évaluer la qualité du modèle. Ainsi, bien que nous ayons continué à calculer ces métriques traditionnelles, nous avons utilisé le score LRAP (Label Ranking Average Precision) comme métrique principale pour calculer la précision du modèle sur l’ensemble de test. Cette mesure mesure essentiellement dans quelle mesure le classificateur a attribué des probabilités plus élevées aux vraies étiquettes37.

À des degrés divers, le classificateur de réseaux neuronaux a été couronné de succès tant pour les humains que pour les chiens. Pour les humains, l’algorithme a été capable de classer à la fois les objets et les actions, avec des modèles à trois classes pour les deux atteignant une précision moyenne de 70 %. Le score LRAP a été utilisé comme mesure principale pour calculer la précision du modèle sur l’ensemble de test ; Cette mesure mesure la mesure dans laquelle le classificateur a attribué des probabilités plus élevées aux vraies étiquettes37. Pour les deux humains, les scores médians du LRAP étaient supérieurs au 99e centile d’un ensemble d’étiquettes permutées au hasard pour tous les modèles testés (tableau 1 ; Figure 2). Pour les chiens, seul le modèle d’action avait un rang centile médian du LRAP significativement supérieur au hasard chez les deux participants (tableau 1 ; p = 0,13 pour les objets et p < 0,001 pour les actions ; score moyen LRAP du modèle d’action à trois classes pour les chiens = 78e centile). Ces résultats étaient vrais pour tous les sujets individuellement, ainsi que lorsqu’ils étaient regroupés par espèce.

Compte tenu du succès du classifieur, nous nous sommes entraînés et testés avec des classes supplémentaires pour déterminer les limites du modèle. Cela comprenait le calcul de matrices de dissimilitude pour l’ensemble des 52 classes potentielles d’intérêt à l’aide de l’algorithme de clustering hiérarchique du package Python scipy, qui regroupait les classes en fonction de la similitude de la réponse cérébrale d’un individu à chacune, telle que définie par corrélation par paire. Parmi les autres modèles testés, le modèle avec le classement médian le plus élevé du percentile LRAP chez les deux chiens comportait cinq classes : les classes originales « parler », « manger » et « renifler », ainsi que deux nouvelles classes, « caresser » et « jouer » (figure 2). Ce modèle avait un rang centile médian du PALT significativement supérieur à celui prédit par hasard pour tous les participants (tableau 1 ; p < 0,001 pour les chiens et les humains ; score LRAP moyen du modèle d’action à cinq classes pour les chiens = 81e centile).

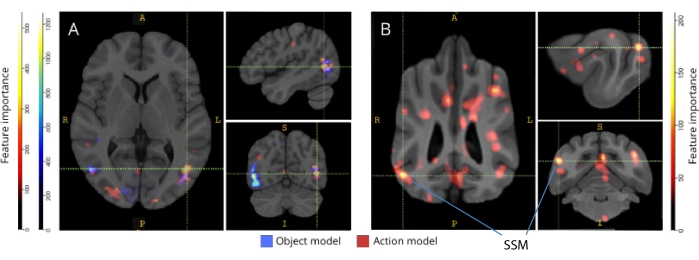

Lorsqu’ils ont été rétrocartographiés à leurs atlas cérébraux respectifs, les scores d’importance des caractéristiques des voxels ont révélé un certain nombre de groupes de voxels informatifs dans les cortex occipital, pariétal et temporal des chiens et des humains (Figure 3). Chez l’homme, les modèles basés sur les objets et basés sur l’action ont révélé un motif plus focal que chez les chiens et dans les régions généralement associées à la reconnaissance des objets, bien qu’avec de légères différences dans la localisation spatiale des voxels basés sur les objets et des voxels basés sur l’action.

Nous avons vérifié que ces différences d’espèces n’étaient pas le résultat du mouvement corrélé à la tâche des chiens se déplaçant davantage vers certains types de vidéos que d’autres (par exemple, des vidéos autres que des chiens, par exemple, des voitures). Nous avons calculé la norme euclidienne des six paramètres de mouvement et ajusté un modèle linéaire à effets mixtes à l’aide du package R lme4, avec la classe comme effet fixe et le nombre de course comme effet aléatoire pour chaque chien. Pour chacun des modèles finaux, nous n’avons trouvé aucun effet significatif du type de classe sur le mouvement pour Daisy (F(2, 2252) = 0,83, p = 0,44 pour l’action et F(4, 1235) = 1,87, p = 0,11 pour l’action) ou Bhubo (F(2, 2231) = 1,71, p = 0,18 pour l’action et F(4, 1221) = 0,94, p = 0,45 pour l’action).

Figure 1 : Vidéos naturalistes et présentation en IRM. (A) Exemples d’images de clips vidéo montrés aux participants. (B) Bhubo, un Boxer-mix de 4 ans, regardant des vidéos tout en subissant une IRMf éveillée. Veuillez cliquer ici pour voir une version agrandie de cette figure.

Figure 2 : Performance du modèle chez le chien et l’homme. La distribution des scores LRAP, présentés sous forme de classements centiles de leurs distributions nulles, sur 100 itérations d’entraînement et de test de l’algorithme d’apprentissage automatique Ivis pour un modèle basé sur l’objet à trois classes, un modèle basé sur l’action à trois classes et un modèle basé sur l’action à cinq classes, où les modèles ont tenté de classer les réponses BOLD à des stimuli vidéo naturalistes obtenus via IRMf éveillée chez le chien et l’homme. Les scores sont agrégés par espèce. Un score LRAP avec un classement centile très élevé indique qu’il est très peu probable que le modèle atteigne ce score LRAP par hasard. Un modèle dont les performances ne sont pas meilleures que celles du hasard aurait un classement centile médian du score LRAP de ~50. Les lignes pointillées représentent le classement centile médian du score du PALL pour chaque espèce sur les 100 passages. Veuillez cliquer ici pour voir une version agrandie de cette figure.

Figure 3 : Régions importantes pour la discrimination des modèles d’action à trois classes et à cinq classes. (A) Participants humains et (B) chiens. Les voxels ont été classés en fonction de leur importance de caractéristique à l’aide d’un classificateur de forêt aléatoire, moyenné sur toutes les itérations des modèles. Les 5 % supérieurs des voxels (c’est-à-dire ceux utilisés pour entraîner les modèles) sont présentés ici, agrégés par espèces et transformés en espace de groupe à des fins de visualisation (atlas : humains34 et chiens35). Les étiquettes montrent des régions du cerveau du chien avec des scores d’importance de caractéristique élevés, basés sur ceux identifiés par Johnson et al.35. Abréviation : SSM = gyrus suprasylvien. Veuillez cliquer ici pour voir une version agrandie de cette figure.

| Type de modèle | Précision de l’entraînement | Précision des tests | F1 Score | Précision | Rappeler | Percentile médian du score LRAP | |

| Humain 1 | Objet (3 classes) | 0.98 | 0.69 | 0.48 | 0.52 | 0.49 | >99 |

| Action (3 classes) | 0.98 | 0.72 | 0.51 | 0.54 | 0.54 | >99 | |

| Action (5 classes) | 0.97 | 0.51 | 0.28 | 0.37 | 0.27 | >99 | |

| Humain 2 | Objet (3 classes) | 0.98 | 0.68 | 0.45 | 0.5 | 0.47 | >99 |

| Action (3 classes) | 0.98 | 0.69 | 0.46 | 0.5 | 0.48 | >99 | |

| Action (5 classes) | 0.97 | 0.53 | 0.3 | 0.4 | 0.27 | >99 | |

| Bhubo | Objet (3 classes) | 0.99 | 0.61 | 0.38 | 0.41 | 0.39 | 57 |

| Action (3 classes) | 0.98 | 0.63 | 0.38 | 0.4 | 0.4 | 87 | |

| Action (5 classes) | 0.99 | 0.45 | 0.16 | 0.29 | 0.13 | 88 | |

| Pâquerette | Objet (3 classes) | 1 | 0.61 | 0.38 | 0.43 | 0.39 | 43 |

| Action (3 classes) | 0.97 | 0.62 | 0.35 | 0.38 | 0.35 | 60 | |

| Action (5 classes) | 0.99 | 0.44 | 0.16 | 0.27 | 0.13 | 76 |

Tableau 1 : Métriques agrégées de l’algorithme d’apprentissage automatique Ivis sur 100 itérations d’entraînement et de tests sur les réponses BOLD à des stimuli vidéo naturalistes obtenus via l’IRMf éveillée chez les chiens et les humains. Les modèles d’objets avaient trois classes cibles (« chien », « humain », « voiture »), et les modèles d’action avaient trois ou cinq classes (trois classes : « parler », « manger », « renifler » ; cinq classes : « parler », « manger », « renifler », « caresser », « jouer »). Les valeurs nettement supérieures au hasard sont indiquées en gras.

Tableau supplémentaire 1 : Étiquettes de classe. Veuillez cliquer ici pour télécharger ce fichier.

Vidéo supplémentaire 1 : Exemple de clip vidéo. Veuillez cliquer ici pour télécharger ce fichier.

Discussion

Les résultats de cette étude démontrent que les vidéos naturalistes induisent des représentations dans le cerveau des chiens qui sont suffisamment stables au cours de plusieurs séances d’imagerie pour pouvoir être décodées avec l’IRMf similaires aux résultats obtenus chez les humains et les singes20,23. Alors que des études antérieures d’IRMf du système visuel canin ont présenté des stimuli dépouillés, tels qu’un visage ou un objet sur un fond neutre, les résultats démontrent ici que les vidéos naturalistes, avec plusieurs personnes et objets interagissant les uns avec les autres, induisent des modèles d’activation dans le cortex canin qui peuvent être décodés avec une fiabilité approchant celle observée dans le cortex humain. Cette approche ouvre de nouvelles pistes d’investigation sur l’organisation du système visuel du chien.

Bien que le domaine de l’IRMf canine se soit rapidement développé, à ce jour, ces expériences se sont appuyées sur des stimuli relativement pauvres, tels que des images de personnes ou d’objets sur des fonds neutres 10,12,13. De plus, bien que ces expériences aient commencé à identifier des régions cérébrales analogues à la surface du visage fusiforme des primates (FFA), impliquée dans le traitement du visage, et au cortex occipital latéral (LOC), pour le traitement des objets, il reste un désaccord sur la nature de ces représentations, par exemple si les chiens ont des zones faciales en soi répondant à des caractéristiques saillantes similaires à celles des primates ou s’ils ont des représentations distinctes pour les chiens et les humains ou les visages et les têtes. par exemple 9,13. Les chiens, bien sûr, ne sont pas des primates, et nous ne savons pas comment ils interprètent ces stimuli artificiels séparés de leurs contextes multisensoriels habituels avec des sons et des odeurs. Certaines preuves suggèrent que les chiens ne traitent pas les images d’objets comme des représentations de choses réelles12. Bien qu’il ne soit pas possible de créer une véritable expérience multisensorielle dans le scanner, l’utilisation de vidéos naturalistes peut atténuer une partie de l’artificialité en fournissant des stimuli dynamiques qui correspondent plus étroitement au monde réel, du moins à un chien. Pour les mêmes raisons, l’utilisation de stimuli naturalistes dans la recherche sur l’IRMf humaine a gagné en popularité, démontrant, par exemple, que des séquences d’événements dans un film sont représentées dans le cortex sur plusieurs échelles de temps et que les films sont efficaces pour induire une activation émotionnelle fiable38. En tant que tel, alors que les vidéos naturalistes restent des stimuli relativement pauvres, leur succès en neurosciences humaines soulève la question de savoir si des résultats similaires peuvent être obtenus chez les chiens.

Nos résultats montrent qu’un classificateur de réseau neuronal a réussi à décoder certains types de contenu naturaliste à partir de cerveaux de chiens. Ce succès est un exploit impressionnant compte tenu de la complexité des stimuli. Il est important de noter que, comme le classificateur a été testé sur des clips vidéo invisibles, le modèle de décodage a détecté de grandes catégories identifiables à travers les clips plutôt que des propriétés spécifiques à des scènes individuelles. Il convient de noter qu’il existe plusieurs mesures permettant de quantifier les performances d’un classificateur d’apprentissage automatique (tableau 1). Comme les vidéos naturalistes, de par leur nature, n’auront pas les mêmes occurrences de toutes les classes, nous avons adopté une approche prudente en construisant une distribution nulle à partir de la permutation aléatoire d’étiquettes et en évaluant la signification référencée à celle-ci. Ensuite, nous avons constaté que le succès des modèles de chiens était statistiquement significatif, atteignant des scores de 75e à 90e centile, mais seulement lorsque les vidéos étaient codées en fonction des actions présentes, telles que jouer ou parler.

Les séries de tests, contrairement aux séries d’entraînement, n’étaient pas équilibrées entre les classes. Ne représentant que 20 % des données, le sous-échantillonnage pour la plus petite taille de classe aurait donné lieu à des échantillons de très petite taille pour chaque classe, de sorte que les statistiques calculées n’auraient pas été fiables. Pour éviter la possibilité d’une précision accrue due à ce déséquilibre, la distribution nulle du LRAP a été calculée en permutant aléatoirement l’ordre des classes 1 000 fois pour chaque itération du modèle. Cette distribution nulle servait de référence pour la performance probable du modèle par hasard. Ensuite, le véritable LRAP a ensuite été converti en un rang centile dans cette distribution nulle. Un classement centile très élevé, par exemple 95 %, indiquerait qu’un score aussi élevé n’est apparu que 5 % du temps dans 1 000 permutations aléatoires. Un tel modèle pourrait donc être considéré comme performant bien au-dessus du hasard. Pour déterminer si ces classements centiles sont significativement supérieurs à ceux attendus par le hasard, c’est-à-dire le 50e centile, statistiquement, le classement centile médian du LRAP sur les 100 itérations de chaque modèle a été calculé et un test de rang signé de Wilcoxon sur un échantillon a été effectué.

Bien que l’objectif principal soit de développer un décodeur de stimuli visuels naturalistes pour les chiens, les comparaisons avec les humains sont inévitables. Ici, nous notons deux différences majeures : pour chaque type de classificateur, les modèles humains ont obtenu de meilleurs résultats que les modèles canins ; Et les modèles humains ont obtenu de bons résultats pour les modèles basés sur l’objet et l’action, tandis que les modèles canins ont fonctionné uniquement pour les modèles basés sur l’action. Les performances supérieures des modèles humains pourraient être dues à plusieurs facteurs. Les cerveaux humains sont environ 10 fois plus grands que les cerveaux de chiens, il y a donc plus de voxels à partir desquels choisir de construire un classificateur. Pour mettre les modèles sur un pied d’égalité, il faut utiliser le même nombre de voxels, mais cela peut être dans un sens absolu ou relatif. Bien que le modèle final ait été basé sur les 5 % supérieurs des voxels informatifs dans chaque cerveau (une mesure relative), des résultats similaires ont été obtenus en utilisant un nombre fixe de voxels. Ainsi, il semble plus probable que les différences de performance soient liées à la façon dont les humains et les chiens perçoivent les stimuli vidéo. Comme indiqué ci-dessus, alors que les chiens et les humains sont tous deux multisensoriels dans leur perception, les stimuli peuvent être plus appauvris pour un chien qu’un humain. Les repères de taille, par exemple, peuvent être perdus, tout semblant être une version jouet du monde réel. Il existe des preuves que les chiens classent les objets en fonction de leur taille et de leur texture avant leur forme, ce qui est presque l’opposé des humains39. De plus, l’odeur, qui n’est pas prise en compte ici, est probablement une source d’information importante pour la discrimination d’objets chez les chiens, en particulier dans l’identification des congénères ou des humains 40,41,42. Cependant, même en l’absence de repères de taille ou d’odeur, dans l’environnement inhabituel de l’IRM, le fait que le classificateur ait fonctionné indique qu’il y avait encore des informations pertinentes pour les chiens qui pouvaient être récupérées de leur cerveau. Avec seulement deux chiens et deux humains, les différences d’espèces pourraient également être dues à des différences individuelles. Les deux chiens, cependant, représentaient les meilleurs des chiens entraînés à l’IRM et excellaient à rester immobiles tout en regardant des vidéos. Alors qu’une plus grande taille d’échantillon permettrait certainement d’établir des distinctions plus fiables entre les espèces, le petit nombre de chiens capables de faire de l’IRMf éveillés et qui regarderont des vidéos pendant des périodes assez longues limitera toujours la généralisabilité à tous les chiens. Bien qu’il soit possible que des races spécialisées, comme les lévriers, aient des réponses cérébrales visuelles plus fines, nous pensons que le tempérament et l’entraînement individuels sont plus susceptibles d’être les principaux déterminants de ce qui est récupérable du cerveau d’un chien.

Ces différences d’espèces soulèvent la question de savoir à quel aspect des vidéos les chiens prêtaient attention. Une approche pour répondre à cette question repose sur des stimuli vidéo plus simples. Ensuite, en utilisant des images isolées d’humains, de chiens et de voitures, à la fois individuellement et ensemble sur des arrière-plans neutres, nous pourrions être en mesure d’inverser les dimensions saillantes d’un chien. Cependant, cela est à la fois inefficace sur le plan méthodologique et appauvrit davantage les stimuli du monde réel. La question de l’attention peut être résolue par l’approche de décodage seule, en effet, en utilisant les performances du modèle pour déterminer ce qui est pris en charge43. Dans le même ordre d’idées, les résultats suggèrent que, alors que les humains s’occupaient à la fois des acteurs et des actions, les chiens étaient plus concentrés sur les actions elles-mêmes. Cela pourrait être dû à des différences dans les caractéristiques de mouvement de bas niveau, telles que la fréquence des mouvements lorsque les individus jouent ou mangent, ou cela pourrait être dû à une représentation catégorique de ces activités à un niveau supérieur. La distribution de voxels informatifs dans tout le cortex du chien suggère que ces représentations ne sont pas seulement des caractéristiques de bas niveau qui seraient autrement confinées aux régions visuelles. Une étude plus approfondie utilisant une plus grande variété de stimuli vidéo peut éclairer le rôle du mouvement dans la discrimination des catégories par les chiens.

En résumé, cette étude a démontré la faisabilité de récupérer des informations visuelles naturalistes du cortex canin à l’aide de l’IRMf de la même manière que pour le cortex humain. Cette démonstration montre que, même en l’absence de son ou d’odeurs, les dimensions saillantes de scènes complexes sont encodées par des chiens qui regardent des vidéos et que ces dimensions peuvent être récupérées de leur cerveau. Deuxièmement, sur la base du petit nombre de chiens qui peuvent effectuer ce type de tâche, l’information peut être plus largement distribuée dans le cortex que ce que l’on observe généralement chez les humains, et les types d’actions semblent être plus facilement récupérés que l’identité des acteurs ou des objets. Ces résultats ouvrent une nouvelle façon d’examiner comment les chiens perçoivent les environnements qu’ils partagent avec les humains, y compris les écrans vidéo, et suggèrent de riches pistes pour l’exploration future de la façon dont eux-mêmes et d’autres animaux non primates « voient » le monde.

Déclarations de divulgation

Aucun.

Remerciements

Nous remercions Kate Revill, Raveena Chhibber et Jon King pour leurs idées utiles dans le développement de cette analyse, Mark Spivak pour son aide au recrutement et à la formation de chiens pour l’IRM, et Phyllis Guo pour son aide dans la création et l’étiquetage des vidéos. Nous remercions également nos propriétaires de chiens dévoués, Rebecca Beasley (Daisy) et Ashwin Sakhardande (Bhubo). Les études sur l’homme ont été financées par une subvention du National Eye Institute (subvention R01 EY029724 à D.D.D.).

matériels

| Name | Company | Catalog Number | Comments |

| 3 T MRI Scanner | Siemens | Trio | |

| Audio recordings of scanner noise | homemade | none | |

| Camera gimbal | Hohem | iSteady PRO 3 | |

| Dog-appropriate videos | homemade | none | |

| fMRI processing software | AFNI | 20.3.01 | |

| Mock scanner components | homemade | none | Mock head coil and scanner tube |

| Neural net software | Ivis | 1.7.1 | |

| Optical flow software | OpenCV | 4.2.0.34 | |

| Projection system for scanner | homemade | none | |

| Trophy Cam HD | Bushnell | 119874 | |

| Video camera | GoPro | HERO7 | |

| Visualization software | ITK-SNAP | 3.6.0 | |

| Windows Video Editor | Microsoft | Windows 11 version |

Références

- Mishkin, M., Ungerleider, L. G., Macko, K. A. Object vision and spatial vision: Two cortical pathways. Trends in Neurosciences. 6, 414-417 (1983).

- de Haan, E. H. F., Cowey, A. On the usefulness of 'what' and 'where' pathways in vision. Trends in Cognitive Sciences. 15 (10), 460-466 (2011).

- Freud, E., Plaut, D. C., Behrmann, M. What' is happening in the dorsal visual pathway. Trends in Cognitive Sciences. 20 (10), 773-784 (2016).

- Goodale, M. A., Milner, A. D. Separate visual pathways for perception and action. Trends in Neurosciences. 15 (1), 20-25 (1992).

- Schenk, T., McIntosh, R. D. Do we have independent visual streams for perception and action? Do we have independent visual streams for perception and action. Cognitive Neuroscience. 1 (1), 52-78 (2010).

- Andics, A., Gácsi, M., Faragó, T., Kis, A., Miklós, Á Report voice-sensitive regions in the dog and human brain are revealed by comparative fMRI. Current Biology. 24 (5), 574-578 (2014).

- Berns, G. S., Brooks, A. M., Spivak, M. Functional MRI in awake unrestrained dogs. PLoS One. 7 (5), 38027(2012).

- Karl, S., et al. Training pet dogs for eye-tracking and awake fMRI. Behaviour Research Methods. 52, 838-856 (2019).

- Bunford, N., et al. Comparative brain imaging reveals analogous and divergent patterns of species and face sensitivity in humans and dogs. Journal of Neuroscience. 40 (43), 8396-8408 (2020).

- Cuaya, L. V., Hernández-Pérez, R., Concha, L. Our faces in the dog's brain: Functional imaging reveals temporal cortex activation during perception of human faces. PLoS One. 11 (3), 0149431(2016).

- Dilks, D. D., et al. Awake fMRI reveals a specialized region in dog temporal cortex for face processing. PeerJ. 2015 (8), 1115(2015).

- Prichard, A., et al. 2D or not 2D? An fMRI study of how dogs visually process objects. Animal Cognition. 24 (5), 1143-1151 (2021).

- Thompkins, A. M., et al. Separate brain areas for processing human and dog faces as revealed by awake fMRI in dogs (Canis familiaris). Learning & Behavior. 46 (4), 561-573 (2018).

- Zhang, K., Sejnowski, T. J. A universal scaling law between gray matter and white matter of cerebral cortex. Proceedings of the National Academy of Sciences of the United States of America. 97 (10), 5621-5626 (2000).

- Bradshaw, J., Rooney, N. Dog Social Behavior and Communication. The Domestic Dog: Its Evolution, Behavior and Interactions with People. Serpell, J. , Cambridge University Press. Cambridge, UK. 133-160 (2017).

- Prichard, A., et al. The mouth matters most: A functional magnetic resonance imaging study of how dogs perceive inanimate objects. The Journal of Comparative Neurology. 529 (11), 2987-2994 (2021).

- Haxby, J. V., Connolly, A. C., Guntupalli, J. S. Decoding neural representational spaces using multivariate pattern analysis. Annual Review of Neuroscience. 37, 435-456 (2014).

- Kamitani, Y., Tong, F. Decoding the visual and subjective contents of the human brain. Nature Neuroscience. 8 (5), 679-685 (2005).

- Kay, K. N., Naselaris, T., Prenger, R. J., Gallant, J. L. Identifying natural images from human brain activity. Nature. 452 (7185), 352-355 (2008).

- Nishimoto, S., et al. Reconstructing visual experiences from brain activity evoked by natural movies. Current Biology. 21 (19), 1641-1646 (2011).

- vander Meer, J. N., Breakspear, M., Chang, L. J., Sonkusare, S., Cocchi, L. Movie viewing elicits rich and reliable brain state dynamics. Nature Communications. 11 (1), 5004(2020).

- Huth, A. G., De Heer, W. A., Griffiths, T. L., Theunissen, F. E., Gallant, J. L. Natural speech reveals the semantic maps that tile human cerebral cortex. Nature. 532 (7600), 453-458 (2016).

- Kriegeskorte, N., et al. Matching categorical object representations in inferior temporal cortex of man and monkey. Neuron. 60 (6), 1126-1141 (2008).

- Ehsani, K., Bagherinezhad, H., Redmon, J., Mottaghi, R., Farhadi, A. Who let the dogs out? Modeling dog behavior from visual data. Proceedings of the IEEE Conference on Computer Vision and Pattern. 2018, 4051-4060 (2018).

- Berns, G. S., Brooks, A., Spivak, M. Replicability and heterogeneity of awake unrestrained canine fMRI responses. PLoS One. 9 (5), 98421(2013).

- Cox, R. W. AFNI: Software for analysis and visualization of functional magnetic resonance neuroimages. Computers and Biomedical Research. 29 (3), 162-173 (1996).

- Prichard, A., Chhibber, R., Athanassiades, K., Spivak, M., Berns, G. S. Fast neural learning in dogs: A multimodal sensory fMRI study. Scientific Reports. 8, 14614(2018).

- Russ, B. E., Kaneko, T., Saleem, K. S., Berman, R. A., Leopold, D. A. Distinct fMRI responses to self-induced versus stimulus motion during free viewing in the macaque. The Journal of Neuroscience. 36 (37), 9580-9589 (2016).

- Farnebäck, G. Two-Frame Motion Estimation Based on Polynomial Expansion. In Image Analysis. Scandinavian Conference on Image Analysis. Lecture Notes in Computer Science. Bigun, J., Gustavsson, T. 2749, Springer. Berlin, Heidelberg. 363-370 (2003).

- Elias, D. O., Land, B. R., Mason, A. C., Hoy, R. R. Measuring and quantifying dynamic visual signals in jumping spiders). Journal of Comparative Physiology A. 192, 799-800 (2006).

- Szubert, B., Cole, J. E., Monaco, C., Drozdov, I. Structure-preserving visualisation of high dimensional single-cell datasets. Scientific Reports. 9, 8914(2019).

- Tian, H., Tao, P. IVIS dimensionality reduction framework for biomacromolecular simulations. Journal of Chemical Information and Modeling. 60 (10), 4569-4581 (2020).

- Hebart, M. N., Gorgen, K., Haynes, J. The decoding toolbox (TDT): A versatile software package for multivariate analyses of functional imaging data. Frontiers in Neuroinformatics. 8, 88(2015).

- Mazziotta, J., et al. A probabilistic atlas and reference system for the human brain: International Consortium for Brain Mapping (ICBM). Philosophical Transactions of the Royal Society B: Biological Sciences. 356 (1412), 1293-1322 (2001).

- Johnson, P. J., et al. Stereotactic cortical atlas of the domestic canine brain. Scientific Reports. 10, 4781(2020).

- Yushkevich, P. A., et al. User-guided 3D active contour segmentation of anatomical structures: Significantly improved efficiency and reliability. NeuroImage. 31 (3), 1116-1128 (2006).

- Fürnkranz, J., Hüllermeier, E., Loza Mencía, E., Brinker, K. Multilabel classification via calibrated label ranking. Machine Learning. 73 (2), 133-153 (2008).

- Sonkusare, S., Breakspear, M., Guo, C. Naturalistic stimuli in neuroscience: Critically acclaimed. Trends in Cognitive Sciences. 23 (8), 699-714 (2019).

- vander Zee, E., Zulch, H., Mills, D. Word generalization by a dog (Canis familiaris): Is shape important. PLoS One. 7 (11), 49382(2012).

- Bekoff, M. Observations of scent-marking and discriminating self from others by a domestic dog (Canis familiaris): Tales of displaced yellow snow. Behavioural Processes. 55 (2), 75-79 (2001).

- Berns, G. S., Brooks, A. M., Spivak, M. Scent of the familiar: An fMRI study of canine brain responses to familiar and unfamiliar human and dog odors. Behavioural Processes. 110, 37-46 (2015).

- Schoon, G. A. A., de Bruin, J. C. The ability of dogs to recognize and cross-match human odours. Forensic Science International. 69 (2), 111-118 (1994).

- Kamitani, Y., Tong, F. Decoding seen and attended motion directions from activity in the human visual cortex. Current Biology. 16 (11), 1096-1102 (2006).

Réimpressions et Autorisations

Demande d’autorisation pour utiliser le texte ou les figures de cet article JoVE

Demande d’autorisationThis article has been published

Video Coming Soon