Method Article

Através dos olhos de um cachorro: decodificação de fMRI de vídeos naturalistas do córtex canino

Neste Artigo

Resumo

Algoritmos de aprendizado de máquina foram treinados para usar padrões de atividade cerebral para "decodificar" estímulos apresentados aos humanos. Aqui, demonstramos que a mesma técnica pode decodificar conteúdo de vídeo naturalista do cérebro de dois cães domésticos. Descobrimos que os decodificadores baseados nas ações dos vídeos foram bem-sucedidos em cães.

Resumo

Avanços recentes usando aprendizado de máquina e ressonância magnética funcional (fMRI) para decodificar estímulos visuais do córtex humano e não humano resultaram em novos insights sobre a natureza da percepção. No entanto, essa abordagem ainda não foi aplicada substancialmente a outros animais além dos primatas, levantando questões sobre a natureza de tais representações em todo o reino animal. Aqui, usamos fMRI acordado em dois cães domésticos e dois humanos, obtidos enquanto cada um assistia a vídeos naturalistas especialmente criados para cães. Em seguida, treinamos uma rede neural (Ivis) para classificar o conteúdo do vídeo de um total de 90 minutos de atividade cerebral registrada de cada um. Testamos um classificador baseado em objetos, tentando discriminar categorias como cachorro, humano e carro, e um classificador baseado em ação, tentando discriminar categorias como comer, cheirar e falar. Em comparação com os dois sujeitos humanos, para os quais ambos os tipos de classificadores tiveram um desempenho bem acima do acaso, apenas os classificadores baseados em ação foram bem-sucedidos na decodificação do conteúdo de vídeo dos cães. Esses resultados demonstram a primeira aplicação conhecida de aprendizado de máquina para decodificar vídeos naturalistas do cérebro de um carnívoro e sugerem que a visão do mundo com o olho do cão pode ser bem diferente da nossa.

Introdução

Os cérebros dos humanos, como de outros primatas, demonstram o parcelamento do fluxo visual em vias dorsais e ventrais com funções distintas e bem conhecidas - o "o quê" e o "onde" dos objetos1. Essa dicotomia o que/onde tem sido uma heurística útil por décadas, mas sua base anatômica agora é conhecida por ser muito mais complexa, com muitos pesquisadores favorecendo uma parcelação baseada em reconhecimento versus ação ("o que" vs. "como")2,3,4,5. Além disso, embora nossa compreensão da organização do sistema visual dos primatas continue a ser refinada e debatida, muito permanece desconhecido sobre como os cérebros de outras espécies de mamíferos representam a informação visual. Em parte, essa lacuna é resultado do foco histórico em um punhado de espécies na neurociência visual. Novas abordagens para imagens cerebrais, no entanto, estão abrindo a possibilidade de estudar de forma não invasiva os sistemas visuais de uma gama mais ampla de animais, o que pode produzir novos insights sobre a organização do sistema nervoso dos mamíferos.

Os cães (Canis lupus familiaris) apresentam uma rica oportunidade para estudar a representação de estímulos visuais em uma espécie evolutivamente distante dos primatas, pois podem ser o único animal que pode ser treinado para participar cooperativamente de exames de ressonância magnética sem a necessidade de sedação ou restrições 6,7,8. Devido à sua coevolução com os humanos nos últimos 15.000 anos, os cães também habitam nossos ambientes e são expostos a muitos dos estímulos que os humanos encontram diariamente, incluindo telas de vídeo, que são a forma preferida de apresentar estímulos em um scanner de ressonância magnética. Mesmo assim, os cães podem processar esses estímulos ambientais comuns de maneiras bem diferentes dos humanos, o que levanta a questão de como seu córtex visual é organizado. Diferenças básicas - como a falta de uma fóvea ou o fato de ser um dicromata - podem ter consequências significativas a jusante, não apenas para a percepção visual de nível inferior, mas também para a representação visual de nível superior. Vários estudos de fMRI em cães demonstraram a existência de regiões de processamento facial e de objeto que parecem seguir a arquitetura geral do fluxo dorsal/ventral observada em primatas, embora ainda não esteja claro se os cães têm regiões de processamento facial per se ou se essas regiões são seletivas para a morfologia da cabeça (por exemplo, cão vs. humano)9, 10,11,12,13. Independentemente disso, o cérebro de um cão, sendo menor do que a maioria dos primatas, seria previsto para ser menos modularizado14, então pode haver mais mistura de tipos de informação nos fluxos ou mesmo privilegiar certos tipos de informação, como ações. Foi sugerido, por exemplo, que o movimento pode ser uma característica mais saliente na percepção visual canina do que a textura ou a cor15. Além disso, como os cães não têm mãos, um dos principais meios pelos quais interagimos com o mundo, seu processamento visual, principalmente de objetos, pode ser bem diferente do dos primatas. Em consonância com isso, recentemente encontramos evidências de que a interação com objetos pela boca versus pata resultou em maior ativação em regiões seletivas de objetos no cérebro do cão16.

Embora os cães possam estar acostumados a telas de vídeo em seu ambiente doméstico, isso não significa que eles estejam acostumados a ver imagens em um ambiente experimental da mesma forma que um humano faria. O uso de estímulos mais naturalistas pode ajudar a resolver algumas dessas questões. Na última década, os algoritmos de aprendizado de máquina alcançaram um sucesso considerável na decodificação de estímulos visuais naturalistas da atividade cerebral humana. Os primeiros sucessos se concentraram na adaptação de designs clássicos e bloqueados para usar a atividade cerebral para classificar os tipos de estímulos que um indivíduo estava vendo, bem como as redes cerebrais que codificavam essas representações 17,18,19. À medida que algoritmos mais poderosos foram desenvolvidos, especialmente redes neurais, estímulos mais complexos puderam ser decodificados, incluindo vídeos naturalistas20,21. Esses classificadores, que normalmente são treinados em respostas neurais a esses vídeos, generalizam para novos estímulos, permitindo que eles identifiquem o que um determinado sujeito estava observando no momento da resposta de fMRI. Por exemplo, certos tipos de ações em filmes podem ser decodificados com precisão do cérebro humano, como pular e girar, enquanto outros (por exemplo, arrastar) não podem22. Da mesma forma, embora muitos tipos de objetos possam ser decodificados a partir de respostas de fMRI, as categorias gerais parecem ser mais difíceis. A decodificação do cérebro não se limita aos humanos, fornecendo uma ferramenta poderosa para entender como as informações são organizadas nos cérebros de outras espécies. Experimentos análogos de fMRI com primatas não humanos encontraram representações distintas no lobo temporal para dimensões de animacidade e faciness / corporalidade, que são paralelas às dos humanos23.

Como um primeiro passo para entender as representações dos cães de estímulos visuais naturalistas, a fMRI acordada foi usada em dois cães domésticos altamente adeptos à ressonância magnética para medir as respostas corticais a vídeos apropriados para cães. Neste estudo, vídeos naturalistas foram usados por causa de sua validade ecológica potencialmente maior para um cão e por causa de seu sucesso demonstrado com redes neurais que mapeiam o conteúdo de vídeo para o movimento do cão24. Em três sessões separadas, 90 minutos de dados de fMRI foram obtidos das respostas de cada cão a 256 videoclipes exclusivos. Para comparação, o mesmo procedimento foi realizado em dois voluntários humanos. Em seguida, usando uma rede neural, treinamos e testamos classificadores para discriminar "objetos" (por exemplo, humano, cachorro, carro) ou "ações" (por exemplo, falar, comer, cheirar) usando números variados de classes. Os objetivos deste estudo foram duplos: 1) determinar se os estímulos de vídeo naturalistas poderiam ser decodificados do córtex canino; e 2) em caso afirmativo, forneça uma primeira olhada se a organização era semelhante à dos humanos.

Protocolo

O estudo com cães foi aprovado pela Emory University IACUC (PROTO201700572), e todos os proprietários deram consentimento por escrito para a participação de seus cães no estudo. Os procedimentos do estudo em humanos foram aprovados pelo IRB da Emory University e todos os participantes forneceram consentimento por escrito antes da digitalização (IRB00069592).

1. Participantes

- Selecione os participantes (cães e humanos) sem exposição prévia aos estímulos apresentados no estudo.

NOTA: Os cães participantes eram dois cães de estimação locais voluntários por seus donos para participação em treinamento e varredura de fMRI consistente com o descrito anteriormente7. Bhubo era um macho de 4 anos de idade, e Daisy era uma fêmea de 11 anos de Boston terrier. Ambos os cães já haviam participado de vários estudos de fMRI (Bhubo: 8 estudos, Daisy: 11 estudos), alguns dos quais envolviam assistir a estímulos visuais projetados em uma tela enquanto estavam no scanner. Eles foram selecionados por causa de sua capacidade demonstrada de permanecer no scanner sem se mover por longos períodos de tempo com seu dono fora de vista. Dois humanos (um macho, 34 anos, e uma fêmea, 25 anos) também participaram do estudo. Nem cães nem humanos tiveram exposição prévia aos estímulos mostrados neste estudo.

2. Estímulos

- Filme os vídeos (1920 pixels x 1440 pixels, 60 quadros por segundo [fps]) montados em um gimbal estabilizador portátil.

NOTA: Neste estudo, os vídeos foram filmados em Atlanta, Geórgia, em 2019.- Filme vídeos naturalistas de uma "visão de cachorro", segurando o gimbal aproximadamente na altura do joelho. Projete os vídeos para capturar cenários cotidianos na vida de um cachorro.

NOTA: Isso incluiu cenas de caminhada, alimentação, brincadeiras, humanos interagindo (entre si e com cães), cães interagindo uns com os outros, veículos em movimento e animais não caninos (Figura 1A; Filme Suplementar 1). Em alguns clipes, os sujeitos do vídeo interagiram diretamente com a câmera, por exemplo, acariciando, cheirando ou brincando com ela, enquanto em outros, a câmera foi ignorada. Imagens adicionais de veados foram obtidas de uma armadilha fotográfica colocada localmente (1920 pixels x 1080 pixels, 30 fps). - Edite os vídeos em 256 "cenas" exclusivas de 7 s. Cada cena retratava um único evento, como humanos se abraçando, um cachorro correndo ou um cervo passeando. Atribua a cada cena um número e rótulo exclusivos de acordo com seu conteúdo (veja abaixo).

- Filme vídeos naturalistas de uma "visão de cachorro", segurando o gimbal aproximadamente na altura do joelho. Projete os vídeos para capturar cenários cotidianos na vida de um cachorro.

- Edite as cenas em cinco vídeos de compilação maiores de aproximadamente 6 minutos cada. Use vídeos de compilação em vez de um filme longo para apresentar uma ampla variedade de estímulos em sequência.

NOTA: Apresentar uma grande variedade de estímulos seria difícil de alcançar se os vídeos fossem capturados em uma longa "tomada". Isso é consistente com os estudos de decodificação de fMRI em humanos20,22. Além disso, a apresentação de compilações de clipes curtos permitiu a criação mais fácil de um conjunto de retenção no qual o algoritmo treinado poderia ser testado (consulte a seção 7, análises, abaixo), pois foi possível manter os clipes individuais em vez de um filme longo. Quatro vídeos de compilação tinham 51 cenas únicas e um tinha 52. Não houve pausas ou telas em branco entre as cenas. - Selecione as cenas semi-aleatoriamente para garantir que cada vídeo contenha exemplos de todas as principais categorias de gravadoras - cães, humanos, veículos, animais não humanos e interações.

NOTA: Durante o processo de compilação, todas as cenas foram reduzidas para 1920 pixels x 1080 pixels a 30 fps para corresponder à resolução do projetor de ressonância magnética.

3. Desenho experimental

- Escaneie os participantes em um scanner de ressonância magnética 3T enquanto assiste aos vídeos de compilação projetados em uma tela montada na parte traseira do orifício de ressonância magnética.

- Reproduza os vídeos sem som.

- Para cães, obtenha um posicionamento estável da cabeça por meio de treinamento prévio para colocar a cabeça em um apoio de queixo feito sob medida, moldado na mandíbula inferior do meio do focinho até atrás da mandíbula.

- Fixe o apoio de queixo em uma prateleira de madeira que abranja a bobina, mas permita espaço suficiente para as patas embaixo, resultando em cada cão assumindo uma posição de "esfinge" (Figura 1B). Nenhuma restrição foi usada. Para mais informações sobre o protocolo de treinamento, consulte estudos anteriores com fMRI acordadoem cães 7.

- Deixe os sujeitos participarem de cinco execuções por sessão, cada execução consistindo em um vídeo de compilação assistido do início ao fim, apresentado em ordem aleatória. Para cães, faça pequenas pausas entre cada corrida. Entregue recompensas de comida durante esses intervalos para o cão.

- Deixe cada sujeito participar de três sessões ao longo de 2 semanas. Isso permite que o sujeito assista a cada um dos cinco vídeos de compilação exclusivos três vezes, produzindo um tempo agregado de fMRI de 90 minutos por indivíduo.

4. Exames por imagem

- Escaneie os participantes do cão seguindo um protocolo consistente com o empregado em estudos anteriores de fMRI acordados 7,25.

- Obtenha as varreduras funcionais usando uma sequência de imagem ecoplanar de disparo único para adquirir volumes de 22 cortes sequenciais de 2,5 mm com um intervalo de 20% (TE = 28 ms, TR = 1.430 ms, ângulo de inversão = 70 °, matriz 64 x 64, tamanho de voxel no plano de 2,5 mm, FOV = 160 mm).

- Para cães, oriente as fatias dorsalmente para o cérebro com a direção de codificação de fase da direita para a esquerda, enquanto os cães se sentam na ressonância magnética em uma posição de "esfinge", com o pescoço alinhado com o cérebro. A codificação de fase da direita para a esquerda evita artefatos envolventes do pescoço para a frente da cabeça. Além disso, o principal artefato de suscetibilidade em cães de varredura vem do seio frontal, resultando em distorção do lobo frontal.

- Para humanos, obtenha cortes axiais com codificação de fase na direção ântero-posterior.

- Para permitir a comparação com as varreduras de cães (mesmo TR / TE), use a aquisição de fatia multibanda (CMRR, Universidade de Minnesota) para os humanos com um fator de aceleração multibanda de 2 (GRAPPA = 2, TE = 28 ms, TR = 1.430 ms, ângulo de inversão = 55 °, matriz 88 x 88, voxels no plano de 2,5 mm, quarenta e quatro fatias de 2,5 mm com uma lacuna de 20%).

- Para os cães, adquira também uma imagem estrutural ponderada em T2 de todo o cérebro para cada participante usando uma sequência turbo spin-eco com voxels isotrópicos de 1,5 mm. Para os participantes humanos, use uma sequência MPRAGE ponderada em T1 com voxels isotrópicos de 1 mm.

NOTA: Ao longo de três sessões, aproximadamente 4.000 volumes funcionais foram obtidos para cada participante.

5. Rótulos de estímulo

- Para treinar um modelo para classificar o conteúdo apresentado nos vídeos, rotule as cenas primeiro. Para fazer isso, divida as cenas de 7 s que compõem cada vídeo de compilação em clipes de 1,4 s. Rotule clipes curtos em vez de quadros individuais, pois há elementos de vídeo que não podem ser capturados por quadros estáticos, alguns dos quais podem ser particularmente salientes para cães e, portanto, úteis na decodificação, como movimento.

NOTA: Um comprimento de clipe de 1,4 s foi escolhido porque era longo o suficiente para capturar esses elementos dinâmicos e correspondia ao TR de 1,43 s, o que permite realizar a classificação volume por volume. - Distribua aleatoriamente esses clipes de 1,4 s (n = 1.280) aos membros do laboratório para rotular manualmente cada clipe usando um formulário de envio pré-programado no estilo caixa de seleção.

NOTA: Foram escolhidos 94 rótulos para abranger o maior número possível de recursos-chave dos vídeos, incluindo assuntos (por exemplo, cachorro, humano, gato), número de assuntos (1, 2, 3+), objetos (por exemplo, carro, bicicleta, brinquedo), ações (por exemplo, comer, cheirar, falar), interações (por exemplo, humano-humano, humano-cachorro) e cenário (dentro de casa, ao ar livre), entre outros. Isso produziu um vetor de rótulo de 94 dimensões para cada clipe (Tabela Suplementar 1). - Como uma verificação de consistência, selecione um subconjunto aleatório para nova rotulagem por um segundo membro do laboratório. Aqui, os rótulos foram considerados altamente consistentes entre os indivíduos (>95%). Para os rótulos que não eram consistentes, permita que os dois membros do laboratório assistam novamente ao clipe em questão e cheguem a um consenso sobre o rótulo.

- Para cada execução, use arquivos de log com carimbo de data/hora para determinar o início do estímulo de vídeo em relação ao primeiro volume de varredura.

- Para explicar o atraso entre a apresentação do estímulo e a resposta BOLD, convolvo os rótulos com uma função de resposta hemodinâmica gama dupla (HRF) e interpole para o TR das imagens funcionais (1.430 ms) usando as funções Python numpy.convolve() e interp().

NOTA: O resultado final foi uma matriz de rótulos convolutivos pelo número total de volumes de digitalização para cada participante (94 rótulos x 3.932, 3.920, 3.939 e 3.925 volumes para Daisy, Bhubo, Humano 1 e Humano 2, respectivamente). - Agrupe esses rótulos sempre que necessário para criar macrorótulos para análise posterior. Por exemplo, combine todas as instâncias de caminhada (passear com cachorro, passear com humanos, andar com burros) para criar um rótulo "caminhar".

- Para remover ainda mais a redundância no conjunto de rótulos, calcule o fator de inflação de variância (VIF) para cada rótulo, excluindo os macrorótulos, que são obviamente altamente correlacionados.

NOTA: O VIF é uma medida de multicolinearidade em variáveis preditoras, calculada pela regressão de cada preditor em relação a todas as outras. VIFs mais altos indicam preditores mais altamente correlacionados. Este estudo empregou um limite VIF de 2, reduzindo os 94 rótulos para 52 rótulos únicos e amplamente não correlacionados (Tabela Suplementar 1).

6. Pré-processamento de fMRI

- O pré-processamento envolve correção de movimento, censura e normalização usando a suíte AFNI (NIH) e suas funções associadas26,27. Use uma correção de movimento de corpo rígido de duas passagens e seis parâmetros para alinhar os volumes a um volume alvo que seja representativo da posição média da cabeça do participante nas corridas.

- Execute a censura para remover volumes com deslocamento superior a 1 mm entre as varreduras, bem como aqueles com intensidades de sinal de voxel discrepantes superiores a 0,1%. Para ambos os cães, mais de 80% dos volumes foram retidos após a censura e, para humanos, mais de 90% foram retidos.

- Para melhorar a relação sinal-ruído de voxels individuais, execute uma suavização espacial leve usando 3dmerge e um kernel gaussiano de 4 mm na metade máxima da largura total.

- Para controlar o efeito de características visuais de baixo nível, como movimento ou velocidade, que podem diferir de acordo com o estímulo, calcule o fluxo óptico entre quadros consecutivos de videoclipes22,28. Calcule o fluxo óptico usando o algoritmo Farneback no OpenCV após reduzir a resolução para 10 quadros por segundo29.

- Para estimar a energia de movimento em cada quadro, calcule a soma dos quadrados do fluxo óptico de cada pixel e pegue a raiz quadrada do resultado, calculando efetivamente o fluxo óptico médio euclidiano de um quadro para o próximo28,30. Isso gera cursos de tempo de energia de movimento para cada vídeo de compilação.

- Reamostra-os para corresponder à resolução temporal dos dados de fMRI, convolucionados com uma função de resposta hemodinâmica gama dupla (HRF) como acima e concatenados para alinhar com a apresentação do estímulo para cada sujeito.

- Use esse curso de tempo, juntamente com os parâmetros de movimento gerados a partir da correção de movimento descrita acima, como os únicos regressores para um modelo linear geral (GLM) estimado para cada voxel com o 3dDeconvolve do AFNI. Use os resíduos desse modelo como entradas para o algoritmo de aprendizado de máquina descrito abaixo.

7. Análises

- Decodifique as regiões do cérebro que contribuem significativamente para a classificação de estímulos visuais, treinando um modelo para cada participante individual que pode ser usado para classificar o conteúdo de vídeo com base nos dados cerebrais dos participantes. Use o algoritmo de aprendizado de máquina Ivis, um método não linear baseado em redes neurais siamesas (SNNs) que mostrou sucesso em dados biológicos de alta dimensão31.

NOTA: As SNNs contêm duas sub-redes idênticas que são usadas para aprender a semelhança de entradas nos modos supervisionado ou não supervisionado. Embora as redes neurais tenham crescido em popularidade para a decodificação cerebral por causa de seu poder geralmente maior sobre métodos lineares, como máquinas de vetores de suporte (SVMs), usamos um SNN aqui por causa de sua robustez para desequilíbrio de classe e a necessidade de menos exemplares. Em comparação com máquinas de vetores de suporte (SVM) e classificadores de floresta aleatória (RF) treinados nos mesmos dados, descobrimos que o Ivis é mais bem-sucedido na classificação de dados cerebrais em várias combinações de rótulos, conforme determinado por várias métricas, incluindo pontuação média F1, precisão, recall e exatidão do teste (veja abaixo). - Para cada participante, converta os resíduos de todo o cérebro em um formato apropriado para entrada na rede neural Ivis. Concatene e mascare as cinco corridas em cada uma de suas três sessões, retendo apenas os voxels cerebrais.

- Nivele a dimensão espacial, resultando em uma matriz bidimensional de voxels por tempo.

- Concatene os rótulos convolutivos dos vídeos mostrados em cada execução, correspondendo assim às execuções de fMRI.

- Censure os dados de fMRI e os rótulos correspondentes de acordo com os volumes sinalizados no pré-processamento.

- Selecione os rótulos de destino a serem decodificados - doravante chamados de "classes" - e retenha apenas os volumes que contêm essas classes. Para simplificar, trate as classes como mutuamente exclusivas e não inclua volumes pertencentes a várias classes para decodificação, deixando apenas exemplos puros.

- Divida os dados em conjuntos de treinamento e teste. Use uma divisão quíntupla, selecionando aleatoriamente 20% das cenas para atuar como o conjunto de teste.

NOTA: Isso significava que, se uma determinada cena fosse selecionada para o conjunto de teste, todos os clipes e volumes funcionais obtidos durante essa cena seriam mantidos fora do conjunto de treinamento. Se a divisão tivesse sido executada independentemente da cena, os volumes da mesma cena teriam aparecido tanto no conjunto de treinamento quanto no conjunto de teste, e o classificador só teria que combiná-los com essa cena específica para ter sucesso em classificá-los. No entanto, para classificar corretamente os volumes retidos de novas cenas, o classificador teve que combiná-los com uma classe mais geral e independente da cena. Este foi um teste mais robusto da generalização do sucesso do classificador em comparação com a realização de clipes individuais. - Equilibre o conjunto de treinamento subamostrando o número de volumes em cada classe para corresponder ao da menor classe usando o pacote scikit-learn imbalanced-learn.

- Para cada participante, treine e teste o algoritmo Ivis em 100 iterações, cada vez usando uma divisão única de teste-trem (parâmetros Ivis: k = 5, modelo = "maaten", n_epochs_without_progress = 30, supervision_weight = 1). Esses valores de parâmetros foram amplamente selecionados com base no tamanho e na complexidade do conjunto de dados, conforme recomendado pelos autores do algoritmo em sua documentação32. "Número de épocas sem progresso" e "peso de supervisão" (0 para não supervisionado, 1 para supervisionado) foram submetidos a ajuste de parâmetro adicional para otimizar o modelo.

- Para reduzir o número de recursos usados para treinar o classificador de todo o cérebro para apenas os voxels mais informativos, use um classificador de floresta aleatória (RFC) usando scikit-learn para classificar cada voxel de acordo com a importância de seu recurso.

NOTA: Embora o RFC não tenha funcionado acima do acaso por si só, ele serviu ao propósito útil de filtrar voxels não informativos, o que teria contribuído apenas com ruído para o algoritmo Ivis. Isso é semelhante ao uso de testes F para seleção de recursos antes de passar para o classificador33. Apenas os 5% principais voxels do conjunto de treinamento foram usados em treinamento e teste. O número preferido de voxels foi selecionado como 5% como um limite conservador em um esforço para reduzir o número de voxels não informativos antes de treinar a rede neural. Resultados qualitativamente semelhantes também foram obtidos para humanos e cães ao usar uma proporção maior de voxels. Embora os cérebros humanos sejam maiores do que os cérebros de cães, os modelos humanos também foram bem-sucedidos quando treinados em um número absoluto de voxels igual aos incluídos em modelos de cães, muito menor que 5% dos voxels (~ 250 voxels; todas as pontuações médias de LRAP >99º percentil). Por consistência, apresentamos, portanto, os resultados usando os 5% superiores de voxels para ambas as espécies. - Normalize a média de 5% dos voxels mais informativos em todas as 100 execuções, transforme no espaço estrutural de cada participante e, em seguida, no espaço do atlas de grupo (atlas: humanos34 e cães35) e some entre os participantes de cada espécie. Sobreponha a importância do recurso nos atlas e pinte-os de acordo com a pontuação de importância usando o ITK-SNAP36.

Resultados

As métricas mais comuns para avaliar o desempenho do modelo em análises de aprendizado de máquina incluem precisão, exatidão, recall e pontuação F1. A precisão é a porcentagem geral de previsões do modelo que estão corretas, considerando os dados verdadeiros. A precisão é a porcentagem de previsões positivas do modelo que são realmente positivas (ou seja, a taxa de verdadeiros positivos), enquanto a lembrança é a porcentagem de verdadeiros positivos nos dados originais que o modelo é capaz de prever com sucesso. A pontuação F1 é a média ponderada de precisão e recordação e atua como uma medida alternativa de precisão que é mais robusta para o desequilíbrio de classe. No entanto, o Ivis difere de outros algoritmos de aprendizado de máquina comumente usados, pois sua saída não é binária. Dada uma entrada particular de voxels cerebrais, cada elemento de saída representa as probabilidades correspondentes a cada uma das classes. Calcular exatidão, precisão, recall e F1 para essas saídas exigia binarizá-los de uma forma "o vencedor leva tudo", onde a classe com a maior probabilidade era considerada a prevista para aquele volume. Essa abordagem eliminou informações importantes sobre a classificação dessas probabilidades que eram relevantes para avaliar a qualidade do modelo. Assim, embora ainda calculássemos essas métricas tradicionais, usamos a pontuação Label Ranking Average Precision (LRAP) como a métrica principal para calcular a precisão do modelo no conjunto de teste. Essa métrica mede essencialmente até que ponto o classificador atribuiu probabilidades mais altas a rótulos verdadeiros37.

Em diferentes graus, o classificador de rede neural foi bem-sucedido para humanos e cães. Para humanos, o algoritmo foi capaz de classificar objetos e ações, com modelos de três classes para ambos, alcançando uma precisão média de 70%. A pontuação LRAP foi usada como métrica primária para calcular a precisão do modelo no conjunto de teste; Essa métrica mede até que ponto o classificador atribuiu probabilidades mais altas a rótulos verdadeiros37. Para ambos os humanos, os escores LRAP medianos foram maiores que o percentil 99 de um conjunto de rótulos permutados aleatoriamente para todos os modelos testados (Tabela 1; Figura 2). Para os cães, apenas o modelo de ação teve uma classificação mediana do percentil LRAP significativamente maior do que o acaso em ambos os participantes (Tabela 1; p = 0,13 para objetos e p < 0,001 para ações; pontuação média do modelo de ação de três classes LRAP para cães = 78º percentil). Esses resultados foram verdadeiros para todos os indivíduos individualmente, bem como quando agrupados por espécies.

Dado o sucesso do classificador, treinamos e testamos com classes adicionais para determinar os limites do modelo. Isso incluiu o cálculo de matrizes de dissimilaridade para todas as 52 classes potenciais de interesse usando o algoritmo de agrupamento hierárquico do pacote Python scipy, que agrupou classes com base na semelhança da resposta cerebral de um indivíduo a cada uma, conforme definido pela correlação em pares. Dos modelos adicionais testados, o modelo com a maior classificação do percentil LRAP mediano em ambos os cães tinha cinco classes: o original "falar", "comer" e "cheirar", além de duas novas classes, "acariciar" e "brincar" (Figura 2). Esse modelo teve uma classificação mediana do percentil LRAP significativamente maior do que a prevista pelo acaso para todos os participantes (Tabela 1; p < 0,001 para cães e humanos; pontuação média do modelo de ação de cinco classes LRAP para cães = 81º percentil).

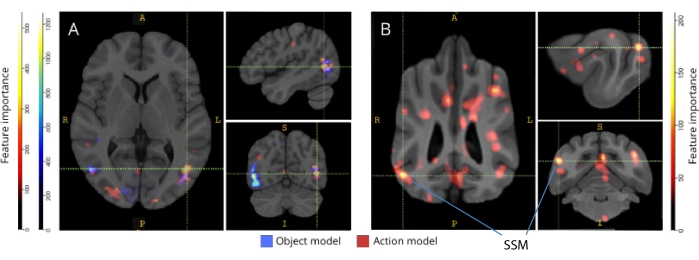

Quando mapeados de volta para seus respectivos atlas cerebrais, os escores de importância de característica dos voxels revelaram vários grupos de voxels informativos nos córtices occipital, parietal e temporal de cães e humanos (Figura 3). Em humanos, os modelos baseados em objetos e baseados em ação revelaram um padrão mais focal do que nos cães e em regiões tipicamente associadas ao reconhecimento de objetos, embora com pequenas diferenças na localização espacial de voxels baseados em objetos e voxels baseados em ação.

Verificamos que essas diferenças de espécies não eram resultado do movimento correlacionado à tarefa dos cães se movendo mais para alguns tipos de vídeos do que outros (por exemplo, vídeos que não sejam cães, digamos, carros). Calculamos a norma euclidiana dos seis parâmetros de movimento e ajustamos um modelo linear de efeitos mistos usando o pacote R lme4, com classe como efeito fixo e número de corrida como efeito aleatório para cada cão. Para cada um dos modelos finais, não encontramos efeito significativo do tipo de classe no movimento para Daisy (F (2, 2252) = 0,83, p = 0,44 para baseado em objeto e F (4, 1235) = 1,87, p = 0,11 para baseado em ação) ou Bhubo (F (2, 2231) = 1,71, p = 0,18 para baseado em objeto e F (4, 1221) = 0,94, p = 0,45 para baseado em ação).

Figura 1: Vídeos naturalistas e apresentação em ressonância magnética. (A) Exemplos de quadros de videoclipes mostrados aos participantes. (B) Bhubo, um Boxer-mix de 4 anos, assistindo a vídeos enquanto passava por fMRI acordado. Clique aqui para ver uma versão maior desta figura.

Figura 2: Desempenho do modelo em cães e humanos. A distribuição das pontuações LRAP, apresentadas como classificações percentuais de suas distribuições nulas, mais de 100 iterações de treinamento e teste do algoritmo de aprendizado de máquina Ivis para um modelo baseado em objeto de três classes, um modelo baseado em ação de três classes e um modelo baseado em ação de cinco classes, onde os modelos tentaram classificar as respostas BOLD a estímulos de vídeo naturalistas obtidos por meio de fMRI acordado em cães e humanos. As pontuações são agregadas por espécie. Uma pontuação LRAP com uma classificação de percentil muito alta indica que é muito improvável que o modelo atinja essa pontuação LRAP por acaso. Um modelo com desempenho não melhor do que o acaso teria uma classificação média do percentil de pontuação LRAP de ~ 50. As linhas tracejadas representam a classificação média do percentil de pontuação LRAP para cada espécie em todas as 100 execuções. Clique aqui para ver uma versão maior desta figura.

Figura 3: Regiões importantes para a discriminação de modelos de ação de objeto de três classes e ação de cinco classes. (A) Participantes humanos e (B) cães. Os voxels foram classificados de acordo com a importância de sua característica usando um classificador de floresta aleatório, calculado em média em todas as iterações dos modelos. Os 5% principais dos voxels (ou seja, aqueles usados para treinar modelos) são apresentados aqui, agregados por espécie e transformados em espaço de grupo para fins de visualização (atlas: humanos34 e cães35). Os rótulos mostram regiões cerebrais de cães com altos escores de importância de características, com base naqueles identificados por Johnson et al.35. Abreviatura: SSM = giro suprasylviano. Clique aqui para ver uma versão maior desta figura.

| Tipo de modelo | Precisão do treinamento | Precisão do teste | Pontuação F1 | Precisão | Lembrar | Percentil mediano da pontuação LRAP | |

| Humano 1 | Objeto (3 classes) | 0.98 | 0.69 | 0.48 | 0.52 | 0.49 | >99 |

| Ação (3 aulas) | 0.98 | 0.72 | 0.51 | 0.54 | 0.54 | >99 | |

| Ação (5 aulas) | 0.97 | 0.51 | 0.28 | 0.37 | 0.27 | >99 | |

| Humano 2 | Objeto (3 classes) | 0.98 | 0.68 | 0.45 | 0.5 | 0.47 | >99 |

| Ação (3 aulas) | 0.98 | 0.69 | 0.46 | 0.5 | 0.48 | >99 | |

| Ação (5 aulas) | 0.97 | 0.53 | 0.3 | 0.4 | 0.27 | >99 | |

| Bhubo | Objeto (3 classes) | 0.99 | 0.61 | 0.38 | 0.41 | 0.39 | 57 |

| Ação (3 aulas) | 0.98 | 0.63 | 0.38 | 0.4 | 0.4 | 87 | |

| Ação (5 aulas) | 0.99 | 0.45 | 0.16 | 0.29 | 0.13 | 88 | |

| Margarida | Objeto (3 classes) | 1 | 0.61 | 0.38 | 0.43 | 0.39 | 43 |

| Ação (3 aulas) | 0.97 | 0.62 | 0.35 | 0.38 | 0.35 | 60 | |

| Ação (5 aulas) | 0.99 | 0.44 | 0.16 | 0.27 | 0.13 | 76 |

Tabela 1: Métricas agregadas do algoritmo de aprendizado de máquina Ivis em mais de 100 iterações de treinamento e teste em respostas BOLD a estímulos de vídeo naturalísticos obtidos por meio de fMRI acordado em cães e humanos. Os modelos de objetos tinham três classes-alvo ("cachorro", "humano", "carro"), e os modelos de ação tinham três ou cinco classes (três classes: "falar", "comer", "cheirar"; cinco classes: "falar", "comer", "cheirar", "acariciar", "brincar"). Valores significativamente maiores que o acaso são mostrados em negrito.

Tabela suplementar 1: Rótulos de classe. Clique aqui para baixar este arquivo.

Filme Suplementar 1: Exemplo de videoclipe. Clique aqui para baixar este arquivo.

Discussão

Os resultados deste estudo demonstram que os vídeos naturalistas induzem representações no cérebro dos cães que são estáveis o suficiente em várias sessões de imagem para que possam ser decodificadas com fMRI - semelhantes aos resultados obtidos em humanos e macacos20,23. Embora estudos anteriores de fMRI do sistema visual canino tenham apresentado estímulos despojados, como um rosto ou objeto contra um fundo neutro, os resultados aqui demonstram que vídeos naturalistas, com várias pessoas e objetos interagindo uns com os outros, induzem padrões de ativação no córtex canino que podem ser decodificados com uma confiabilidade próxima à observada no córtex humano. Essa abordagem abre novos caminhos de investigação sobre como o sistema visual do cão é organizado.

Embora o campo da fMRI canina tenha crescido rapidamente, até o momento, esses experimentos se basearam em estímulos relativamente empobrecidos, como fotos de pessoas ou objetos contra fundos neutros 10,12,13. Além disso, embora esses experimentos tenham começado a identificar regiões cerebrais análogas à área facial fusiforme de primatas (FFA), envolvidas no processamento facial, e o córtex occipital lateral (LOC), para processamento de objetos, permanece discordância sobre a natureza dessas representações, como se os cães têm áreas faciais per se respondendo a características salientes semelhantes às dos primatas ou se eles têm representações separadas para cães e humanos ou rostos e cabeças, por exemplo, 9,13. Os cães, é claro, não são primatas, e não sabemos como eles interpretam esses estímulos artificiais divorciados de seus contextos multissensoriais usuais com sons e cheiros. Algumas evidências sugerem que os cães não tratam imagens de objetos como representações de coisas reais12. Embora não seja possível criar uma verdadeira experiência multissensorial no scanner, o uso de vídeos naturalistas pode mitigar parte da artificialidade, fornecendo estímulos dinâmicos que correspondem mais ao mundo real, pelo menos para um cão. Pelas mesmas razões, o uso de estímulos naturalistas na pesquisa de fMRI humana ganhou popularidade, demonstrando, por exemplo, que sequências de eventos em um filme são representadas no córtex em várias escalas de tempo e que os filmes são eficazes em induzir a ativação confiável de emoções38. Como tal, embora os vídeos naturalistas continuem sendo estímulos relativamente empobrecidos, seu sucesso na neurociência humana levanta a questão de saber se resultados semelhantes podem ser obtidos em cães.

Nossos resultados mostram que um classificador de rede neural foi bem-sucedido em decodificar alguns tipos de conteúdo naturalista de cérebros de cães. Esse sucesso é um feito impressionante, dada a complexidade dos estímulos. É importante ressaltar que, como o classificador foi testado em videoclipes não vistos, o modelo de decodificação captou categorias amplas que eram identificáveis em clipes, em vez de propriedades específicas de cenas individuais. Devemos observar que existem várias métricas para quantificar o desempenho de um classificador de aprendizado de máquina (Tabela 1). Como os vídeos naturalistas, por sua natureza, não terão ocorrências iguais de todas as classes, adotamos uma abordagem prudente ao construir uma distribuição nula a partir da permutação aleatória de rótulos e avaliar a significância referenciada a isso. Em seguida, descobrimos que o sucesso dos modelos de cães foi estatisticamente significativo, alcançando pontuações de 75º a 90º percentil, mas apenas quando os vídeos foram codificados com base nas ações presentes, como brincar ou falar.

Os conjuntos de teste, ao contrário dos conjuntos de treinamento, não foram equilibrados entre as classes. Compreendendo apenas 20% dos dados, a subamostragem para o menor tamanho de classe teria resultado em tamanhos de amostra muito pequenos para cada classe, de modo que quaisquer estatísticas calculadas não seriam confiáveis. Para evitar a possibilidade de precisão inflada desse desequilíbrio, a distribuição nula do LRAP foi calculada permutando aleatoriamente a ordem das classes 1.000 vezes para cada iteração do modelo. Essa distribuição nula atuou como uma referência para o desempenho do modelo por acaso. Em seguida, o LRAP verdadeiro foi convertido em uma classificação de percentil nessa distribuição nula. Uma classificação percentual muito alta, por exemplo, 95%, indicaria que uma pontuação tão alta surgiu apenas 5% das vezes em 1.000 permutações aleatórias. Tal modelo poderia, portanto, ser considerado como tendo um desempenho bem acima do acaso. Para determinar se essas classificações percentuais são significativamente maiores do que o esperado pelo acaso - ou seja, o 50º percentil - estatisticamente, a classificação média do percentil LRAP em todas as 100 iterações para cada modelo foi calculada e um teste de classificação assinada de Wilcoxon de uma amostra foi realizado.

Embora o objetivo principal fosse desenvolver um decodificador de estímulos visuais naturalistas para cães, as comparações com humanos são inevitáveis. Aqui, notamos duas grandes diferenças: para cada tipo de classificador, os modelos humanos tiveram melhor desempenho do que os modelos de cães; e os modelos humanos tiveram um bom desempenho para modelos baseados em objetos e ações, enquanto os modelos de cães tiveram um desempenho apenas para modelos baseados em ação. O desempenho superior dos modelos humanos pode ser devido a vários fatores. Os cérebros humanos são cerca de 10 vezes maiores do que os cérebros dos cães, então há mais voxels para escolher construir um classificador. Para colocar os modelos em pé de igualdade, deve-se usar o mesmo número de voxels, mas isso pode ser em um sentido absoluto ou relativo. Embora o modelo final tenha sido baseado nos 5% principais de voxels informativos em cada cérebro (uma medida relativa), resultados semelhantes foram obtidos usando um número fixo de voxels. Assim, parece mais provável que as diferenças de desempenho estejam relacionadas à forma como humanos e cães percebem os estímulos de vídeo. Como observado acima, embora cães e humanos sejam multissensoriais em sua percepção, os estímulos podem ser mais empobrecidos para um cão do que para um humano. As dicas de tamanho, por exemplo, podem ser perdidas, com tudo parecendo ser uma versão de brinquedo do mundo real. Há algumas evidências de que os cães categorizam objetos com base no tamanho e textura antes da forma, o que é quase oposto aos humanos39. Além disso, o cheiro, não considerado aqui, é provavelmente uma importante fonte de informação para a discriminação de objetos em cães, particularmente na identificação de coespecíficos ou humanos 40,41,42. No entanto, mesmo na ausência de pistas de tamanho ou cheiro, no ambiente incomum do scanner de ressonância magnética, o fato de o classificador ter funcionado diz que ainda havia informações relevantes para os cães que poderiam ser recuperadas de seus cérebros. Com apenas dois cães e dois humanos, as diferenças entre as espécies também podem ser devidas a diferenças individuais. Os dois cães, no entanto, representaram o melhor dos cães treinados em ressonância magnética e se destacaram em ficar parados enquanto assistiam a vídeos. Embora um tamanho de amostra maior certamente permita que distinções mais confiáveis sejam feitas entre as espécies, o pequeno número de cães que são capazes de fazer fMRI acordados e que assistirão a vídeos por períodos longos o suficiente sempre limitará a generalização para todos os cães. Embora seja possível que raças especializadas, como galgos, possam ter respostas cerebrais visuais mais ajustadas, acreditamos que o temperamento individual e o treinamento são mais prováveis de serem os principais determinantes do que é recuperável do cérebro de um cão.

Essas diferenças de espécies levantam a questão de qual aspecto dos vídeos os cães estavam prestando atenção. Uma abordagem para responder a essa pergunta depende de estímulos de vídeo mais simples. Então, usando imagens isoladas de, digamos, humanos, cães e carros, tanto individualmente quanto juntos contra fundos neutros, podemos ser capazes de fazer engenharia reversa das dimensões salientes de um cão. No entanto, isso é metodologicamente ineficiente e empobrece ainda mais os estímulos do mundo real. A questão da atenção pode ser resolvida apenas pela abordagem de decodificação, com efeito, usando o desempenho do modelo para determinar o que está sendo atendido43. Nesse sentido, os resultados aqui sugerem que, enquanto os humanos atendiam tanto aos atores quanto às ações, os cães estavam mais focados nas ações em si. Isso pode ser devido a diferenças nas características de movimento de baixo nível, como a frequência de movimento quando os indivíduos estão brincando versus comendo, ou pode ser devido a uma representação categórica dessas atividades em um nível superior. A distribuição de voxels informativos em todo o córtex do cão sugere que essas representações não são apenas características de baixo nível que, de outra forma, estariam confinadas a regiões visuais. Um estudo mais aprofundado usando uma variedade maior de estímulos de vídeo pode iluminar o papel do movimento na discriminação de categorias por cães.

Em resumo, este estudo demonstrou a viabilidade de recuperar informações visuais naturalistas do córtex canino usando fMRI da mesma forma que é feito para o córtex humano. Esta demonstração mostra que, mesmo sem som ou cheiros, dimensões salientes de cenas complexas são codificadas por cães assistindo a vídeos e que essas dimensões podem ser recuperadas de seus cérebros. Em segundo lugar, com base no pequeno número de cães que podem realizar esse tipo de tarefa, a informação pode ser mais amplamente distribuída no córtex do que normalmente visto em humanos, e os tipos de ações parecem ser mais facilmente recuperados do que a identidade dos atores ou objetos. Esses resultados abrem uma nova maneira de examinar como os cães percebem os ambientes que compartilham com os humanos, incluindo telas de vídeo, e sugerem caminhos ricos para a exploração futura de como eles e outros animais não primatas "veem" o mundo.

Divulgações

Nenhum.

Agradecimentos

Agradecemos a Kate Revill, Raveena Chhibber e Jon King por seus insights úteis no desenvolvimento desta análise, Mark Spivak por sua assistência no recrutamento e treinamento de cães para ressonância magnética e Phyllis Guo por sua ajuda na criação e rotulagem de vídeos. Também agradecemos aos nossos dedicados donos de cães, Rebecca Beasley (Daisy) e Ashwin Sakhardande (Bhubo). Os estudos em humanos foram apoiados por uma bolsa do National Eye Institute (Grant R01 EY029724 para DDD).

Materiais

| Name | Company | Catalog Number | Comments |

| 3 T MRI Scanner | Siemens | Trio | |

| Audio recordings of scanner noise | homemade | none | |

| Camera gimbal | Hohem | iSteady PRO 3 | |

| Dog-appropriate videos | homemade | none | |

| fMRI processing software | AFNI | 20.3.01 | |

| Mock scanner components | homemade | none | Mock head coil and scanner tube |

| Neural net software | Ivis | 1.7.1 | |

| Optical flow software | OpenCV | 4.2.0.34 | |

| Projection system for scanner | homemade | none | |

| Trophy Cam HD | Bushnell | 119874 | |

| Video camera | GoPro | HERO7 | |

| Visualization software | ITK-SNAP | 3.6.0 | |

| Windows Video Editor | Microsoft | Windows 11 version |

Referências

- Mishkin, M., Ungerleider, L. G., Macko, K. A. Object vision and spatial vision: Two cortical pathways. Trends in Neurosciences. 6, 414-417 (1983).

- de Haan, E. H. F., Cowey, A. On the usefulness of 'what' and 'where' pathways in vision. Trends in Cognitive Sciences. 15 (10), 460-466 (2011).

- Freud, E., Plaut, D. C., Behrmann, M. What' is happening in the dorsal visual pathway. Trends in Cognitive Sciences. 20 (10), 773-784 (2016).

- Goodale, M. A., Milner, A. D. Separate visual pathways for perception and action. Trends in Neurosciences. 15 (1), 20-25 (1992).

- Schenk, T., McIntosh, R. D. Do we have independent visual streams for perception and action? Do we have independent visual streams for perception and action. Cognitive Neuroscience. 1 (1), 52-78 (2010).

- Andics, A., Gácsi, M., Faragó, T., Kis, A., Miklós, &. #. 1. 9. 3. ;. Report voice-sensitive regions in the dog and human brain are revealed by comparative fMRI. Current Biology. 24 (5), 574-578 (2014).

- Berns, G. S., Brooks, A. M., Spivak, M. Functional MRI in awake unrestrained dogs. PLoS One. 7 (5), 38027 (2012).

- Karl, S., et al. Training pet dogs for eye-tracking and awake fMRI. Behaviour Research Methods. 52, 838-856 (2019).

- Bunford, N., et al. Comparative brain imaging reveals analogous and divergent patterns of species and face sensitivity in humans and dogs. Journal of Neuroscience. 40 (43), 8396-8408 (2020).

- Cuaya, L. V., Hernández-Pérez, R., Concha, L. Our faces in the dog's brain: Functional imaging reveals temporal cortex activation during perception of human faces. PLoS One. 11 (3), 0149431 (2016).

- Dilks, D. D., et al. Awake fMRI reveals a specialized region in dog temporal cortex for face processing. PeerJ. 2015 (8), 1115 (2015).

- Prichard, A., et al. 2D or not 2D? An fMRI study of how dogs visually process objects. Animal Cognition. 24 (5), 1143-1151 (2021).

- Thompkins, A. M., et al. Separate brain areas for processing human and dog faces as revealed by awake fMRI in dogs (Canis familiaris). Learning & Behavior. 46 (4), 561-573 (2018).

- Zhang, K., Sejnowski, T. J. A universal scaling law between gray matter and white matter of cerebral cortex. Proceedings of the National Academy of Sciences of the United States of America. 97 (10), 5621-5626 (2000).

- Bradshaw, J., Rooney, N., Serpell, J. Dog Social Behavior and Communication. The Domestic Dog: Its Evolution, Behavior and Interactions with People. , 133-160 (2017).

- Prichard, A., et al. The mouth matters most: A functional magnetic resonance imaging study of how dogs perceive inanimate objects. The Journal of Comparative Neurology. 529 (11), 2987-2994 (2021).

- Haxby, J. V., Connolly, A. C., Guntupalli, J. S. Decoding neural representational spaces using multivariate pattern analysis. Annual Review of Neuroscience. 37, 435-456 (2014).

- Kamitani, Y., Tong, F. Decoding the visual and subjective contents of the human brain. Nature Neuroscience. 8 (5), 679-685 (2005).

- Kay, K. N., Naselaris, T., Prenger, R. J., Gallant, J. L. Identifying natural images from human brain activity. Nature. 452 (7185), 352-355 (2008).

- Nishimoto, S., et al. Reconstructing visual experiences from brain activity evoked by natural movies. Current Biology. 21 (19), 1641-1646 (2011).

- vander Meer, J. N., Breakspear, M., Chang, L. J., Sonkusare, S., Cocchi, L. Movie viewing elicits rich and reliable brain state dynamics. Nature Communications. 11 (1), 5004 (2020).

- Huth, A. G., De Heer, W. A., Griffiths, T. L., Theunissen, F. E., Gallant, J. L. Natural speech reveals the semantic maps that tile human cerebral cortex. Nature. 532 (7600), 453-458 (2016).

- Kriegeskorte, N., et al. Matching categorical object representations in inferior temporal cortex of man and monkey. Neuron. 60 (6), 1126-1141 (2008).

- Ehsani, K., Bagherinezhad, H., Redmon, J., Mottaghi, R., Farhadi, A. Who let the dogs out? Modeling dog behavior from visual data. Proceedings of the IEEE Conference on Computer Vision and Pattern. 2018, 4051-4060 (2018).

- Berns, G. S., Brooks, A., Spivak, M. Replicability and heterogeneity of awake unrestrained canine fMRI responses. PLoS One. 9 (5), 98421 (2013).

- Cox, R. W. AFNI: Software for analysis and visualization of functional magnetic resonance neuroimages. Computers and Biomedical Research. 29 (3), 162-173 (1996).

- Prichard, A., Chhibber, R., Athanassiades, K., Spivak, M., Berns, G. S. Fast neural learning in dogs: A multimodal sensory fMRI study. Scientific Reports. 8, 14614 (2018).

- Russ, B. E., Kaneko, T., Saleem, K. S., Berman, R. A., Leopold, D. A. Distinct fMRI responses to self-induced versus stimulus motion during free viewing in the macaque. The Journal of Neuroscience. 36 (37), 9580-9589 (2016).

- Farnebäck, G., Bigun, J., Gustavsson, T. Two-Frame Motion Estimation Based on Polynomial Expansion. In Image Analysis. Scandinavian Conference on Image Analysis. Lecture Notes in Computer Science. 2749, 363-370 (2003).

- Elias, D. O., Land, B. R., Mason, A. C., Hoy, R. R. Measuring and quantifying dynamic visual signals in jumping spiders). Journal of Comparative Physiology A. 192, 799-800 (2006).

- Szubert, B., Cole, J. E., Monaco, C., Drozdov, I. Structure-preserving visualisation of high dimensional single-cell datasets. Scientific Reports. 9, 8914 (2019).

- Tian, H., Tao, P. IVIS dimensionality reduction framework for biomacromolecular simulations. Journal of Chemical Information and Modeling. 60 (10), 4569-4581 (2020).

- Hebart, M. N., Gorgen, K., Haynes, J. The decoding toolbox (TDT): A versatile software package for multivariate analyses of functional imaging data. Frontiers in Neuroinformatics. 8, 88 (2015).

- Mazziotta, J., et al. A probabilistic atlas and reference system for the human brain: International Consortium for Brain Mapping (ICBM). Philosophical Transactions of the Royal Society B: Biological Sciences. 356 (1412), 1293-1322 (2001).

- Johnson, P. J., et al. Stereotactic cortical atlas of the domestic canine brain. Scientific Reports. 10, 4781 (2020).

- Yushkevich, P. A., et al. User-guided 3D active contour segmentation of anatomical structures: Significantly improved efficiency and reliability. NeuroImage. 31 (3), 1116-1128 (2006).

- Fürnkranz, J., Hüllermeier, E., Loza Mencía, E., Brinker, K. Multilabel classification via calibrated label ranking. Machine Learning. 73 (2), 133-153 (2008).

- Sonkusare, S., Breakspear, M., Guo, C. Naturalistic stimuli in neuroscience: Critically acclaimed. Trends in Cognitive Sciences. 23 (8), 699-714 (2019).

- vander Zee, E., Zulch, H., Mills, D. Word generalization by a dog (Canis familiaris): Is shape important. PLoS One. 7 (11), 49382 (2012).

- Bekoff, M. Observations of scent-marking and discriminating self from others by a domestic dog (Canis familiaris): Tales of displaced yellow snow. Behavioural Processes. 55 (2), 75-79 (2001).

- Berns, G. S., Brooks, A. M., Spivak, M. Scent of the familiar: An fMRI study of canine brain responses to familiar and unfamiliar human and dog odors. Behavioural Processes. 110, 37-46 (2015).

- Schoon, G. A. A., de Bruin, J. C. The ability of dogs to recognize and cross-match human odours. Forensic Science International. 69 (2), 111-118 (1994).

- Kamitani, Y., Tong, F. Decoding seen and attended motion directions from activity in the human visual cortex. Current Biology. 16 (11), 1096-1102 (2006).

Reimpressões e Permissões

Solicitar permissão para reutilizar o texto ou figuras deste artigo JoVE

Solicitar PermissãoThis article has been published

Video Coming Soon

Copyright © 2025 MyJoVE Corporation. Todos os direitos reservados