Method Article

犬の目を通して:犬の皮質からの自然主義的なビデオのfMRI解読

要約

機械学習アルゴリズムは、脳活動のパターンを使用して、人間に提示される刺激を「解読」するように訓練されています。ここでは、同じ手法で2匹の飼い犬の脳から自然主義的なビデオコンテンツを解読できることを示しています。ビデオのアクションに基づくデコーダーは、犬で成功したことがわかりました。

要約

近年、機械学習と機能的磁気共鳴画像法(fMRI)を用いて、ヒトおよびヒト以外の皮質からの視覚刺激を解読する進歩により、知覚の性質に関する新たな知見が得られた。しかし、このアプローチは霊長類以外の動物にはまだ実質的に適用されておらず、動物界全体でのそのような表現の性質について疑問が提起されています。ここでは、2匹の飼い犬と2匹の人間で覚醒fMRIを使用し、それぞれが特別に作成された犬に適した自然主義的なビデオを見ながら取得しました。次に、ニューラルネット(Ivis)を訓練して、それぞれから合計90分間の記録された脳活動からビデオコンテンツを分類しました。犬、人間、車などのカテゴリを区別しようとするオブジェクトベースの分類子と、食べる、匂いを嗅ぐ、話すなどのカテゴリを区別しようとするアクションベースの分類子の両方をテストしました。2人の人間の被験者と比較して、両方のタイプの分類器が偶然をはるかに上回るパフォーマンスを発揮したのに対し、アクションベースの分類器のみが犬のビデオコンテンツの解読に成功しました。これらの結果は、肉食動物の脳から自然主義的なビデオを解読するための機械学習の初めての既知の応用を示しており、犬の視点の世界観が私たちのものとはかなり異なる可能性があることを示唆しています。

概要

人間の脳は、他の霊長類と同様に、視覚流が背側と腹側の経路に細分化されており、物体の「何を」と「どこで」という明確でよく知られた機能を持つことを示しています1。この「何を/どこで」の二分法は何十年にもわたって有用なヒューリスティックであったが、その解剖学的基礎は現在でははるかに複雑であることが知られており、多くの研究者が認識対行動(「何を」対「どのように」)に基づく分割を支持している2,3,4,5。さらに、霊長類の視覚系の組織化に関する私たちの理解は洗練され、議論され続けていますが、他の哺乳類種の脳が視覚情報をどのように表現しているかについては、多くのことがわかっていません。部分的には、この欠落は、視覚神経科学における一握りの種に歴史的に焦点を当ててきた結果です。しかし、脳イメージングへの新しいアプローチは、より広範な動物の視覚系を非侵襲的に研究する可能性を開きつつあり、哺乳類の神経系の組織化に関する新たな知見をもたらす可能性があります。

イヌ(Canis lupus familiaris)は、霊長類から進化的に遠い種における視覚刺激の表現を研究する豊富な機会を提供し、鎮静剤や拘束を必要とせずにMRIスキャンに協力して参加するように訓練できる唯一の動物である可能性がある6,7,8.過去15,000年にわたる人間との共進化により、犬も私たちの環境に生息し、MRIスキャナーで刺激を提示するのに適した方法であるビデオ画面など、人間が日常的に遭遇する多くの刺激にさらされています。それでも、犬はこれらの一般的な環境刺激を人間とはまったく異なる方法で処理する可能性があり、視覚野がどのように組織化されているかという疑問を投げかけます。中心窩の欠如や二色性であることなどの基本的な違いは、低レベルの視覚だけでなく、高レベルの視覚表現にも重大な下流の結果をもたらす可能性があります。イヌを用いたいくつかのfMRI研究は、霊長類に見られる一般的な背側/腹側の流れの構造に従って見える顔と物体の両方の処理領域の存在を実証しているが、イヌがそれ自体に顔処理領域を持っているのか、それともこれらの領域が頭の形態に対して選択的であるかどうか(例えば、イヌ対ヒト)なのかは不明である。10、11、12、13。いずれにせよ、犬の脳は、ほとんどの霊長類よりも小さいため、モジュール化されていないと予測される14ため、ストリーム内の情報の種類がより混ざり合ったり、行動などの特定の種類の情報に特権が与えられたりする可能性があります。例えば、犬の視覚では、質感や色よりも動きがより顕著な特徴である可能性があることが示唆されている15。さらに、犬には手がないため、私たちが世界と交流する主要な手段の1つであり、特に物体の視覚処理は霊長類のそれとはかなり異なる可能性があります。これに沿って、我々は最近、口と足による物体との相互作用が、犬の脳の物体選択領域におけるより大きな活性化をもたらしたという証拠を発見した16。

犬は自宅の環境でビデオスクリーンを見ることに慣れているかもしれませんが、だからといって、人間と同じように実験的な環境で画像を見ることに慣れているわけではありません。より自然な刺激を用いることで、これらの疑問のいくつかを解決することができるかもしれません。過去10年間で、機械学習アルゴリズムは、人間の脳活動から自然主義的な視覚刺激を解読することにかなりの成功を収めました。初期の成功は、個人が見ていた刺激の種類と、これらの表現をコード化する脳ネットワークの両方を分類するために脳活動を使用するために、古典的なブロック化されたデザインを適応させることに焦点を当てていました17,18,19。より強力なアルゴリズム、特にニューラルネットワークが開発されるにつれて、より複雑な刺激を解読することができ、これには自然主義的なビデオ20,21が含まれる。これらの分類器は、通常、これらのビデオに対する神経応答で訓練され、新規刺激に一般化され、fMRI応答の時点で特定の被験者が何を観察していたかを特定できます。例えば、映画の中の特定の種類の動作、例えばジャンプや回転などは人間の脳から正確に解読できるが、他のもの(例えば、ドラッグ)は解読できない22。同様に、fMRIの応答から多くの種類の物体を解読することができますが、一般的なカテゴリーはより困難であるように思われます。脳の解読は人間に限らず、他の種の脳内で情報がどのように組織化されているかを理解するための強力なツールを提供します。ヒト以外の霊長類を用いた類似のfMRI実験では、側頭葉におけるアニマシーとファシネス/身体性の次元について、ヒトのそれと平行する明確な表現が発見された23。

犬による自然視刺激の表現を理解するための第一歩として、覚醒fMRIを、MRIに長けた2匹の飼い犬に使用して、犬に適したビデオに対する皮質反応を測定しました。この研究では、犬にとっての生態学的妥当性が潜在的であるため、また、ビデオコンテンツを犬の動きにマッピングするニューラルネットでの成功が実証されたため、自然主義的なビデオが使用された24。3回のセッションで、256のユニークなビデオクリップに対する各犬の反応から90分間のfMRIデータを取得しました。比較のために、同じ手順を2人の人間のボランティアに対して実行しました。次に、ニューラルネットワークを使用して、さまざまな数のクラスを使用して「オブジェクト」(人間、犬、車など)または「アクション」(話す、食べる、匂いを嗅ぐなど)のいずれかを識別するように分類器を訓練およびテストしました。この研究の目標は2つありました:1)自然なビデオ刺激が犬の皮質から解読できるかどうかを決定します。2)もしそうなら、その組織が人間の組織と類似していたかどうかを最初に調べてください。

プロトコル

この犬の研究は、エモリー大学のIACUC(PROTO201700572)によって承認され、すべての飼い主が犬の研究への参加に書面で同意しました。ヒトでの研究手順はエモリー大学IRBによって承認され、すべての参加者はスキャン前に書面による同意を提供しました(IRB00069592)。

1. 参加者

- 研究で提示された刺激に以前にさらされていない参加者 (犬と人間) を選択します。

注:犬の参加者は、飼い主がfMRIトレーニングとスキャンへの参加を志願した2匹の地元のペット犬であり、前述の7と一致しました。ブボは4歳のオスのボクサーミックスで、デイジーは11歳のメスのボストンテリアミックスでした。両犬とも以前にいくつかのfMRI研究(Bhubo:8件、Daisy:11件)に参加しており、その中にはスキャナー内で画面に投影された視覚刺激を見るものもありました。彼らは、所有者が視界に入らない状態で長時間動かずにスキャナーに留まる能力が実証されているために選ばれました。また、2人の人間(34歳の男性1人、25歳の女性1人)も研究に参加しました。犬も人間も、この研究で示された刺激に以前に曝露したことがありませんでした。

2.刺激

- ハンドヘルド安定化ジンバルに取り付けられたビデオ(1920ピクセル×1440ピクセル、60フレーム/秒[fps])を撮影します。

注:この調査では、ビデオは2019年にジョージア州アトランタで撮影されました。- 「犬の目線」から自然主義的なビデオを撮影し、ジンバルを膝くらいの高さに保ちます。犬の生活における日常的なシナリオを捉えたビデオをデザインします。

注:これらには、散歩、餌やり、遊び、人間との交流(お互いおよび犬との)、犬同士の交流、移動中の車両、および犬以外の動物のシーンが含まれていました(図1A; 補足ムービー1)。一部のクリップでは、ビデオの被写体がカメラと直接対話し、たとえば、カメラを撫でたり、匂いを嗅いだり、カメラで遊んだりしましたが、他のクリップでは、カメラが無視されました。シカの追加映像は、現地に設置されたカメラトラップ(1920ピクセル×1080ピクセル、30fps)から取得されました。 - ビデオを256のユニークな7秒の「シーン」に編集します。各シーンは、人間が抱き合う、犬が走る、鹿が歩くなど、1つのイベントを描いていました。各シーンには、その内容に応じて一意の番号とラベルを割り当てます(以下を参照)。

- 「犬の目線」から自然主義的なビデオを撮影し、ジンバルを膝くらいの高さに保ちます。犬の生活における日常的なシナリオを捉えたビデオをデザインします。

- シーンを編集して、それぞれ約6分の5つの大きなコンピレーションビデオにします。1本の長編映画ではなく、コンピレーションビデオを使用して、さまざまな刺激を順番に提示します。

注:ビデオが1回の長い「テイク」でキャプチャされた場合、さまざまな刺激を提示することは困難です。これは、ヒトでのfMRI解読研究と一致しています20,22。さらに、短いクリップのコンピレーションを表示することで、1つの長いムービーの代わりに個々のクリップをホールドアウトすることが可能になったため、トレーニングされたアルゴリズムをテストできるホールドアウトセットを簡単に作成できました(以下のセクション7、分析を参照)。4つのコンピレーションビデオには51のユニークなシーンがあり、1つは52のシーンがありました。シーン間に休憩や空白の画面はありませんでした。 - シーンを半ランダムに選択して、各ビデオにすべての主要なレーベルカテゴリ(犬、人間、乗り物、人間以外の動物、インタラクション)の模範が含まれるようにします。

注: コンパイル プロセス中に、すべてのシーンが MRI プロジェクターの解像度と一致するように、30 fps で 1920 ピクセル x 1080 ピクセルにダウンサンプリングされました。

3. 実験計画

- MRIボアの後部に取り付けられたスクリーンに投影された編集ビデオを見ながら、3T MRIスキャナーで参加者をスキャンします。

- 音声なしでビデオを再生します。

- 犬の場合は、鼻の中央から下顎の後ろまで下顎に成形されたカスタムメイドのあご当てに頭を置く事前のトレーニングにより、頭の安定した位置を確保します。

- あご当てをコイルにまたがる木製の棚に取り付けますが、その下の足に十分なスペースを確保し、各犬が「スフィンクス」の位置をとるようにします(図1B)。拘束具は使用されていません。トレーニングプロトコルの詳細については、以前のawake fMRI dog studies7を参照してください。

- 被験者にセッションごとに5つのランに参加してもらい、各ランは最初から最後まで視聴された1つのコンピレーションビデオで構成され、ランダムな順序で提示されます。犬の場合は、各ランの間に短い休憩を取ります。これらの休憩中に犬に食べ物の報酬を届けます。

- 各被験者に2週間にわたって3つのセッションに参加させます。これにより、被験者は5つのユニークなコンピレーションビデオをそれぞれ3回視聴でき、1人あたり合計90分のfMRI時間が得られます。

4. イメージング

- 以前の覚醒fMRI犬の研究7,25で採用されたプロトコルと一致するプロトコルに従って、犬の参加者をスキャンします。

- シングルショットエコー平面イメージングシーケンスを使用して機能スキャンを取得し、20%のギャップ(TE = 28 ms、TR = 1,430 ms、フリップ角度 = 70°、64 x 64マトリックス、2.5 mm面内ボクセルサイズ、FOV = 160 mm)のボリュームを取得します。

- 犬の場合は、首が脳と一直線になるように、犬が「スフィンクス」の位置でMRIに座っているため、スライスを脳に対して背側に向け、位相エンコード方向を右から左に向けます。右から左へのフェーズ エンコードでは、首から頭の前へのラップアラウンド アーティファクトが回避されます。さらに、犬のスキャンにおける主な感受性アーチファクトは前頭洞から来ており、前頭葉の歪みを引き起こします。

- ヒトの場合、前後方向に位相符号化した軸スライスを得る。

- 犬のスキャン (同じ TR/TE) との比較を可能にするには、マルチバンド加速係数 2 の人間に対してマルチバンド スライス取得 (CMRR、ミネソタ大学) を使用します (GRAPPA = 2、TE = 28 ms、TR = 1,430 ms、フリップ角度 = 55°、88 x 88 マトリックス、2.5 mm 面内ボクセル、20% のギャップを持つ 44 の 2.5 mm スライス)。

- 犬の場合、1.5 mm の等方性ボクセルを使用したターボ スピンエコー シーケンスを使用して、各参加者の脳全体の T2 強調構造画像も取得します。ヒトの参加者には、1 mm の等方性ボクセルを持つ T1 強調 MPRAGE シーケンスを使用します。

注:3つのセッションの過程で、各参加者について約4,000の機能量が得られました。

5.刺激ラベル

- ビデオに表示されるコンテンツを分類するようにモデルをトレーニングするには、最初にシーンにラベルを付けます。これを行うには、各コンピレーションビデオを構成する7秒のシーンを1.4秒のクリップに分割します。静止画ではキャプチャできないビデオの要素があり、その中には特に犬にとって目立ち、動きなどのデコードに役立つものもあるため、個々のフレームではなく短いクリップにラベルを付けます。

注:クリップの長さ1.4秒が選択されたのは、これらの動的要素をキャプチャするのに十分な長さであり、TRの1.43秒と密接に一致しているため、ボリュームごとに分類を実行できます。 - これらの 1.4 秒のクリップ (n = 1,280) をラボのメンバーにランダムに配布し、事前にプログラムされたチェックボックススタイルの提出フォームを使用して各クリップに手動でラベルを付けます。

注:被写体(犬、人間、猫など)、被写体の数(1、2、3+)、オブジェクト(車、自転車、おもちゃなど)、アクション(食事、匂いを嗅ぐ、話すなど)、インタラクション(人間と人間、人間と犬など)、設定(屋内、屋外)など、動画の主要な特徴をできるだけ多く含むために94のラベルが選ばれました。これにより、各クリップの94次元ラベルベクトルが生成されました(補足表1)。 - 整合性チェックとして、2 番目のラボ メンバーによるラベル変更のためにランダムなサブセットを選択します。ここでは、ラベルは個人間で非常に一貫していることがわかりました(>95%)。一貫性のないラベルについては、2 人のラボ メンバーが問題のクリップを再視聴し、ラベルについて合意に達するのを許可します。

- 実行ごとに、タイムスタンプ付きのログファイルを使用して、最初のスキャンボリュームに対するビデオ刺激の開始を判断します。

- 刺激の提示とBOLD応答の間の遅延を考慮するために、ダブルガンマ血行動態応答関数(HRF)でラベルを畳み込み、Python関数numpy.convolve()とinterp()を使用して機能画像のTR(1,430ミリ秒)に補間します。

注:最終結果は、各参加者のスキャン量の合計による畳み込みラベルのマトリックスでした(94ラベル×3,932、3,920、3,939、および3,925容量、Daisy、Bhubo、Human 1、およびHuman 2で3,925)。 - これらのラベルを必要に応じてグループ化して、さらに分析するためのマクロラベルを作成します。たとえば、歩行のすべてのインスタンス(犬の歩行、人間の歩行、ロバの歩行)を組み合わせて、「歩行」ラベルを作成します。

- ラベル セットの冗長性をさらに削除するには、明らかに相関が高いマクロラベルを除外して、各ラベルの分散インフレーション係数 (VIF) を計算します。

注: VIF は、予測変数の多重共線性の尺度であり、各予測子を互いに回帰することによって計算されます。VIFが高いほど、予測変数の相関性が高いことを示します。この研究では、VIF閾値2を採用し、94のラベルを52のユニークな、ほとんど相関のないラベルに減らしました(補足表1)。

6. fMRIの前処理

- 前処理は、AFNIスイート(NIH)およびそれに関連する機能26,27を使用したモーション補正、打ち切り、および正規化を含む。2パス、6パラメーターの剛体運動補正を使用して、ラン全体の参加者の平均頭位置を表す目標ボリュームにボリュームを合わせます。

- 打ち切りを実行して、スキャン間の変位が1mmを超えるボリューム、および外れ値のボクセル信号強度が0.1%を超えるボリュームを削除します。どちらの犬でも、検閲後も80%以上、ヒトでは90%以上が保持されました。

- 個々のボクセルの S/N 比を改善するには、3dmerge と 4 mm ガウス カーネルを全幅半値で使用して、マイルドな空間平滑化を実行します。

- 刺激に応じて異なる可能性のある、動きや速度などの低レベルの視覚特徴の影響を制御するために、ビデオクリップ22、28の連続フレーム間のオプティカルフローを計算する。OpenCVのFarnebackアルゴリズムを使用して、毎秒10フレームにダウンサンプリングした後のオプティカルフローを計算します29。

- 各フレームの運動エネルギーを推定するには、各ピクセルの光の流れの二乗和を計算し、結果の平方根を取り、1つのフレームから次の28,30までのユークリッド平均光の流れを効果的に計算します。これにより、各コンピレーションビデオのモーションエネルギーの時間経過が生成されます。

- これらを fMRI データの時間分解能に一致するようにリサンプリングし、上記のようにダブル ガンマ血行動態応答関数 (HRF) で畳み込み、各被験者の刺激提示に合わせて連結します。

- このタイム コースを、上記のモーション補正から生成されたモーション パラメーターと共に、AFNI の 3dDeconvolve を使用して各ボクセルに対して推定された一般線形モデル (GLM) への唯一の回帰器として使用します。このモデルの残差を、以下で説明する機械学習アルゴリズムへの入力として使用します。

7. 分析

- 視覚刺激の分類に大きく寄与する脳の領域を解読し、個々の参加者のモデルをトレーニングして、参加者の脳データに基づいてビデオコンテンツを分類するために使用できます。高次元の生物学的データ31で成功を示しているシャムニューラルネットワーク(SNN)に基づく非線形手法であるIvis機械学習アルゴリズムを使用する。

注: SNN には、教師ありモードまたは教師なしモードでの入力の類似性を学習するために使用される 2 つの同一のサブネットワークが含まれています。ニューラルネットワークは、サポートベクターマシン(SVM)のような線形法よりも一般的に大きな力を持つため、脳のデコードに人気が高まっていますが、ここでは、クラスの不均衡に対する堅牢性と、より少ない模範子の必要性から、SNNを使用しました。同じデータでトレーニングされたサポートベクターマシン(SVM)とランダムフォレスト(RF)分類器と比較して、Ivisは、平均F1スコア、精度、再現率、テスト精度などのさまざまな指標によって決定される複数のラベルの組み合わせで脳データを分類することに成功していることがわかりました(以下を参照)。 - 各参加者について、全脳の残差を Ivis ニューラル ネットワークへの入力に適した形式に変換します。3 つのセッションのそれぞれで 5 つのランを連結してマスクし、脳のボクセルのみを保持します。

- 空間次元を平坦化し、時間によるボクセルの 2 次元マトリックスを作成します。

- 各実行で示されたビデオの畳み込みラベルを連結し、fMRI実行に対応します。

- fMRIデータと対応するラベルの両方を、前処理でフラグが立てられた量に従って打ち切ります。

- デコードするターゲットラベル(以下「クラス」と呼びます)を選択し、これらのクラスを含むボリュームのみを保持します。簡単にするために、クラスを相互に排他的なものとして扱い、デコードのために複数のクラスに属するボリュームを含めず、純粋な模範のみを残します。

- データをトレーニング セットとテスト セットに分割します。5分割を使用して、シーンの20%をランダムに選択してテストセットとして機能します。

注:これは、特定のシーンがテストセットに選択された場合、このシーン中に取得されたすべてのクリップと機能ボリュームがトレーニングセットから保持されたことを意味します。分割がシーンとは無関係に実行されていた場合、同じシーンのボリュームがトレーニング セットとテスト セットの両方に表示され、分類器はそれらをその特定のシーンに一致させるだけで、分類が成功しました。ただし、新しいシーンからホールドアウトされたボリュームを正しく分類するには、分類子はそれらをより一般的なシーンに依存しないクラスに一致させる必要がありました。これは、個々のクリップを差し出す場合と比較して、分類器の成功の一般化可能性のより堅牢なテストでした。 - scikit-learn パッケージ imbalanced-learn を使用して、各クラスのボリューム数を最小クラスのボリューム数と一致するようにアンダーサンプリングすることで、トレーニング セットのバランスを取ります。

- 各参加者について、一意のテスト列車分割 (Ivis パラメーター: k = 5、model = "maaten", n_epochs_without_progress = 30, supervision_weight = 1) を使用して、Ivis アルゴリズムを 100 回の反復で学習およびテストします。これらのパラメータ値は、アルゴリズムの著者がそのドキュメンテーション32で推奨しているように、データセットのサイズと複雑さに基づいて主に選択されました。「進行しないエポック数」と「監督重み」(教師なしの場合は0、教師ありの場合は1)は、モデルを最適化するために追加のパラメーター調整を受けました。

- 分類器のトレーニングに使用される特徴の数を全脳から最も有益なボクセルのみに減らすには、scikit-learn を使用してランダムフォレスト分類器(RFC)を使用し、各ボクセルをその特徴の重要度に応じてランク付けします。

注:RFCはそれ自体では偶然以上の性能を発揮しませんでしたが、Ivisアルゴリズムにノイズをもたらすだけの情報量でないボクセルをスクリーニングするという有用な目的を果たしました。これは、分類器33に渡す前に特徴選択のためにF検定を使用することと似ている。トレーニング セットのボクセルの上位 5% のみがトレーニングとテストで使用されました。推奨されるボクセルの数は、ニューラル ネットをトレーニングする前に情報のないボクセルの数を減らすために、保守的なしきい値として 5% として選択されました。質的には、ボクセルの割合を多く使用した場合、人間と犬の両方で同様の結果が得られました。人間の脳は犬の脳よりも大きいですが、犬のモデルに含まれるボクセルの絶対数と同じ数のボクセルで訓練した場合も、ボクセルの5%(~250ボクセル、すべて平均LRAPスコア>99パーセンタイル)よりもはるかに小さいボクセルで訓練した場合にも成功しました。したがって、一貫性を保つために、両方の種の上位5%のボクセルを使用して結果を示します。 - 100回の実行すべてで平均5%の最も有益なボクセルを正規化し、各参加者の構造空間に変換してからグループアトラス空間(アトラス:人間34 、イヌ35)に変換し、各種の参加者間で合計します。アトラスに特徴の重要度を重ね合わせ、ITK-SNAP36を使用して重要度スコアに従って色付けします。

結果

機械学習分析でモデルのパフォーマンスを評価するための最も一般的なメトリックには、精度、精度、再現率、F1 スコアなどがあります。精度は、実際のデータに基づいて、モデル予測の全体的な精度を示します。精度は、モデルの肯定的な予測のうち、実際に正であるものの割合(つまり、真陽性率)であり、再現率は、モデルが正常に予測できる元のデータ内の真陽性の割合です。F1 スコアは、精度と再現率の加重平均であり、クラスの不均衡に対してより堅牢な精度の代替尺度として機能します。ただし、Ivis は、出力がバイナリではないという点で、他の一般的に使用される機械学習アルゴリズムとは異なります。脳ボクセルの特定の入力を指定すると、各出力要素は各クラスに対応する確率を表します。これらの出力の精度、精度、再現率、および F1 を計算するには、それらを "勝者総取り" 方式で二値化する必要があり、確率が最も高いクラスがそのボリュームで予測されたクラスと見なされました。このアプローチでは、モデルの品質評価に関連するこれらの確率のランク付けに関する重要な情報が排除されました。したがって、これらの従来のメトリックを引き続き計算しましたが、ラベル ランキング平均精度 (LRAP) スコアを主要なメトリックとして使用して、テスト セットのモデルの精度を計算しました。このメトリックは、基本的に、分類器が真のラベル37に高い確率をどの程度割り当てたかを測定する。

程度の差こそあれ、ニューラルネット分類器は人間と犬の両方に成功しました。人間の場合、アルゴリズムはオブジェクトとアクションの両方を分類することができ、両方に3つのクラスモデルを使用して平均70%の精度を達成しました。LRAP スコアは、テスト セットのモデルの精度を計算するための主要なメトリックとして使用されました。このメトリックは、分類器が真のラベル37に高い確率を割り当てた程度を測定する。両者とも、LRAPスコアの中央値は、テストしたすべてのモデルについてランダムに並べ替えられたラベルセットの99パーセンタイルよりも大きかった(表1; 図 2)。犬の場合、アクションモデルのみが、両方の参加者でLRAPパーセンタイルランクの中央値が偶然よりも有意に高かった(表1; オブジェクトの場合はp = 0.13、 アクションの場合はp < 0.001です。犬の平均3クラスアクションモデルLRAPスコア= 78パーセンタイル)。これらの結果は、すべての被験者に個別に当てはまるだけでなく、種ごとにグループ化した場合にも当てはまりました。

分類器の成功を受けて、モデルの限界を決定するために、追加のクラスでトレーニングとテストを行いました。これには、Pythonパッケージscipyの階層クラスタリングアルゴリズムを使用して、関心のある52の潜在的なクラス全体の非類似度行列を計算することが含まれていました。このアルゴリズムは、ペアワイズ相関によって定義されるように、各々に対する個人の脳の反応の類似性に基づいてクラスをクラスタリングしました。テストした追加のモデルのうち、両方の犬でLRAPパーセンタイルランキングの中央値が最も高いモデルには、元の「話す」、「食べる」、「匂いを嗅ぐ」の5つのクラスに加えて、「撫でる」と「遊ぶ」の2つの新しいクラスがありました(図2)。このモデルのLRAPパーセンタイルランクの中央値は、すべての参加者の偶然によって予測されたものよりも有意に高かった(表1; p < 0.001 (犬と人間の両方)。犬の平均5クラスアクションモデルLRAPスコア= 81パーセンタイル)。

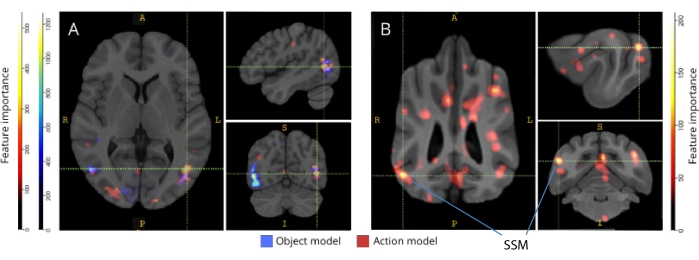

それぞれの脳アトラスにバックマッピングすると、ボクセルの特徴重要度スコアにより、イヌとヒトの両方の後頭皮質、頭頂葉皮質、および側頭皮質に情報量の多いボクセルのクラスターが多数あることが明らかになりました(図3)。人間では、オブジェクトベースのモデルとアクションベースのモデルは、イヌや、オブジェクト認識に通常関連する領域よりも焦点の定型パターンを示しましたが、オブジェクトベースのボクセルとアクションベースのボクセルの空間位置にわずかな違いがありました。

これらの種の違いは、犬が他の種類のビデオ(例えば、犬以外のビデオ、例えば車)よりも多く動くという課題相関運動の結果ではないことを確認しました。6つのモーションパラメータのユークリッドノルムを計算し、Rパッケージlme4を使用して線形混合効果モデルを適合させ、クラスを固定効果として、実行回数を各犬のランダム効果として使用します。最終モデルのそれぞれについて、デイジー(オブジェクトベースはF(2, 2252) = 0.83、 p = 0.44、アクションベースはF(4, 1235) = 1.87、アクションベースは p = 0.11)またはブボ(F(2, 2231) = 1.71、オブジェクトベースは p = 0.18、アクションベースはF(4, 1221) = 0.94、 p = 0.45)のいずれについても、クラスタイプが運動に有意な影響を与えることはなかった。

図1:MRIボアでの自然なビデオとプレゼンテーション (A)参加者に見せられたビデオクリップのフレーム例。(B) 4歳のボクサーミックスのブボが、覚醒状態でfMRIを受けながらビデオを見ている。 この図の拡大版を表示するには、ここをクリックしてください。

図2:犬と人間のモデルパフォーマンス。LRAPスコアの分布は、帰無分布のパーセンタイルランキングとして提示され、3クラスオブジェクトベースモデル、3クラスアクションベースモデル、および5クラスアクションベースモデルのIvis機械学習アルゴリズムのトレーニングとテストを100回以上繰り返しました。犬と人間の覚醒fMRI。スコアは種ごとに集計されます。パーセンタイル ランキングが非常に高い LRAP スコアは、モデルが偶然にその LRAP スコアを達成する可能性が非常に低いことを示します。偶然以上のパフォーマンスを発揮するモデルの場合、LRAP スコアのパーセンタイル ランキングの中央値は ~50 になります。破線は、100回の実行すべてにおける各種のLRAPスコアパーセンタイルランキングの中央値を表しています。この図の拡大版を表示するには、ここをクリックしてください。

図3:3クラスオブジェクトと5クラスアクションモデルの識別に重要な領域(A)人間と(B)犬の参加者。ボクセルは、ランダムフォレスト分類器を使用して、モデルのすべての反復で平均化された特徴の重要度に従ってランク付けされました。ボクセル(つまり、モデルのトレーニングに使用されるボクセル)の上位5%がここに提示され、種ごとに集約され、視覚化の目的でグループ空間に変換されます(アトラス:人間34と犬35)。ラベルは、Johnson et al.35によって特定されたものに基づいて、特徴重要度スコアが高い犬の脳領域を示しています。略語:SSM =上シルビア回。この図の拡大版を表示するには、ここをクリックしてください。

| モデルタイプ | トレーニングの精度 | テスト精度 | F1スコア | 精度 | 思い出す | LRAPスコアの中央パーセンタイル | |

| 人間 1 | オブジェクト(3クラス) | 0.98 | 0.69 | 0.48 | 0.52 | 0.49 | 99> |

| アクション(3クラス) | 0.98 | 0.72 | 0.51 | 0.54 | 0.54 | 99> | |

| アクション(5クラス) | 0.97 | 0.51 | 0.28 | 0.37 | 0.27 | 99> | |

| 人間2 | オブジェクト(3クラス) | 0.98 | 0.68 | 0.45 | 0.5 | 0.47 | 99> |

| アクション(3クラス) | 0.98 | 0.69 | 0.46 | 0.5 | 0.48 | 99> | |

| アクション(5クラス) | 0.97 | 0.53 | 0.3 | 0.4 | 0.27 | 99> | |

| ブボ | オブジェクト(3クラス) | 0.99 | 0.61 | 0.38 | 0.41 | 0.39 | 57 |

| アクション(3クラス) | 0.98 | 0.63 | 0.38 | 0.4 | 0.4 | 87 | |

| アクション(5クラス) | 0.99 | 0.45 | 0.16 | 0.29 | 0.13 | 88 | |

| 雛菊 | オブジェクト(3クラス) | 1 | 0.61 | 0.38 | 0.43 | 0.39 | 43 |

| アクション(3クラス) | 0.97 | 0.62 | 0.35 | 0.38 | 0.35 | 60 | |

| アクション(5クラス) | 0.99 | 0.44 | 0.16 | 0.27 | 0.13 | 76 |

表1:犬と人間の覚醒fMRI を介して 得られた自然主義的なビデオ刺激に対するBOLD応答に関する100回以上のトレーニングとテストのIvis機械学習アルゴリズムの集計メトリック 。オブジェクトモデルには3つのターゲットクラス(「犬」、「人間」、「車」)があり、アクションモデルには3つまたは5つのクラス(「話す」、「食べる」、「匂いを嗅ぐ」の3つのクラス、「話す」、「食べる」、「匂いを嗅ぐ」、「撫でる」、「遊ぶ」の5つのクラス)がありました。chance よりも大幅に大きい値は太字で示されています。

補足表1:クラスラベル。このファイルをダウンロードするには、ここをクリックしてください。

補足ムービー1:サンプルビデオクリップ。このファイルをダウンロードするには、ここをクリックしてください。

ディスカッション

この研究の結果は、自然主義的なビデオが、複数のイメージングセッションにわたって十分に安定しているイヌの脳内の表現を誘導し、fMRIで解読できることを実証している-ヒトとサルの両方で得られた結果と類似している20,23。イヌの視覚系に関するこれまでのfMRI研究では、中立的な背景を背景にした顔や物体など、質の削ぎ落とされた刺激が示されていましたが、今回の結果は、複数の人や物が相互作用する自然主義的なビデオが、イヌの皮質に活性化パターンを誘導し、人間の皮質に見られる信頼性に近い信頼性で解読できることを示しています。このアプローチは、犬の視覚系がどのように組織化されているかについて、新たな研究の道を切り開きます。

イヌのfMRIの分野は急速に成長しているが、今日まで、これらの実験は、中立的な背景を背景とした人や物体の写真など、比較的貧弱な刺激に依存してきた10,12,13。また、これらの実験により、顔の処理に関与する霊長類の紡錘状顔面領域(FFA)や、物体処理のための外側後頭皮質(LOC)に類似した脳領域が同定され始めている一方で、イヌが霊長類と同様の顕著な特徴に対応する顔領域自体を持っているのか、イヌと人間や顔と頭に対して別々の表象を持っているのかなど、これらの表象の性質については意見の相違が残っています。 たとえば、9,13 です。もちろん、犬は霊長類ではなく、音や匂いという通常の多感覚的な文脈から切り離されたこれらの人工的な刺激をどのように解釈するかはわかりません。いくつかの証拠は、犬が物体のイメージを現実のものの表現として扱わないことを示唆しています12。スキャナーで真の多感覚体験を作り出すことはできませんが、自然主義的なビデオを使用すると、少なくとも犬にとっては、現実世界により近いダイナミックな刺激を提供することで、人工性の一部を軽減できる可能性があります。同じ理由で、ヒトのfMRI研究における自然刺激の使用が人気を博しており、例えば、映画の中の一連の出来事が複数の時間スケールにわたって皮質で表現されていること、そして映画が信頼性の高い感情活性化を誘発するのに効果的であることが実証されている38。このように、自然主義的なビデオは比較的貧弱な刺激のままですが、人間の神経科学での成功は、犬でも同様の結果が得られるかどうかという疑問を投げかけています。

私たちの結果は、ニューラルネット分類器が犬の脳からある種の自然主義的な内容を解読することに成功したことを示しています。この成功は、刺激の複雑さを考えると、印象的な偉業です。重要なのは、分類子が未公開のビデオ クリップでテストされたため、デコード モデルでは、個々のシーンに固有のプロパティではなく、クリップ間で識別可能な広範なカテゴリが選択されたことです。機械学習分類器のパフォーマンスを定量化するための複数の指標があることに注意する必要があります(表1)。自然主義的なビデオは、その性質上、すべてのクラスが等しく出現するわけではないため、ラベルのランダムな順列からヌル分布を構築し、それに関連する重要性を評価するという慎重なアプローチを取りました。次に、犬モデルの成功は統計的に有意であり、75〜90パーセンタイルスコアを達成しましたが、それはビデオがプレイや会話などの存在するアクションに基づいてコード化された場合に限られることがわかりました。

テストセットは、トレーニングセットとは異なり、クラス間でバランスが取れていませんでした。データの 20% しか含んでいないため、最小のクラス サイズにアンダーサンプリングすると、各クラスのサンプル サイズが非常に小さくなり、計算された統計量の信頼性が低下します。この不均衡によって精度が高まる可能性を回避するために、LRAP の零分布は、モデルの反復ごとにクラスの順序を 1,000 回ランダムに並べ替えることによって計算されました。この帰無分布は、モデルが偶然にどの程度うまく機能する可能性が高いかの参照として機能しました。次に、真の LRAP をこの null 分布のパーセンタイル ランキングに変換しました。非常に高いパーセンタイルランキング(たとえば、95%)は、1,000のランダムな順列でこれほど高いスコアが5%の確率でしか発生しなかったことを示します。したがって、このようなモデルは、偶然をはるかに超えて機能していると見なすことができます。これらのパーセンタイルランキングが偶然に予想されたもの、つまり50パーセンタイルよりも大幅に大きいかどうかを判断するために、各モデルの100回の反復すべてにわたるLRAPパーセンタイルランキングの中央値が計算され、1サンプルのWilcoxon符号付きランク検定が実行されました。

主な目標は、犬の自然主義的な視覚刺激のデコーダーを開発することでしたが、人間との比較は避けられません。ここでは、2つの大きな違いに注目します:分類器の種類ごとに、人間のモデルは犬のモデルよりも優れたパフォーマンスを発揮しました。また、人間モデルはオブジェクトベースモデルとアクションベースモデルの両方で優れたパフォーマンスを発揮しましたが、犬のモデルはアクションベースでのみパフォーマンスを発揮しました。人間モデルの優れたパフォーマンスは、いくつかの要因によるものである可能性があります。人間の脳は犬の脳の約 10 倍大きいため、分類器を構築するために選択できるボクセルはもっとあります。モデルを対等な立場に置くには、同じ数のボクセルを使用する必要がありますが、これは絶対的な意味でも相対的な意味でもかまいません。最終的なモデルは、各脳の情報ボクセルの上位5%(相対的な尺度)に基づいていましたが、固定数のボクセルを使用して同様の結果が得られました。したがって、パフォーマンスの違いは、人間と犬がビデオ刺激をどのように知覚するかに関連している可能性が高いようです。上記のように、犬と人間はどちらも知覚において多感覚的ですが、刺激は人間よりも犬にとってより貧弱である可能性があります。たとえば、サイズの手がかりが失われ、すべてが現実世界のおもちゃバージョンのように見える場合があります。犬が形状よりもサイズと質感に基づいて物体を分類するという証拠がいくつかあり、これは人間とほぼ逆です39。さらに、ここでは考慮されていない匂いは、犬の物体識別、特に同種またはヒトの識別のための重要な情報源である可能性が高い40,41,42。しかし、サイズや匂いの手がかりがなくても、MRIスキャナーの異常な環境で、分類器がまったく機能しなかったという事実は、犬の脳から回復できる情報がまだあったことを示しています。犬が2匹と人間が2匹しかいない場合、種の違いは個体差によるものかもしれません。しかし、この2匹の犬は、MRIで訓練された犬の中で最も優れており、ビデオを見ながらじっとしているのが得意でした。サンプルサイズが大きければ、種間でより信頼性の高い区別ができるようになるのは確かですが、覚醒状態でのfMRIを行う能力があり、長時間ビデオを見る犬の数が少ないため、一般化可能性は常にすべての犬に限定されます。サイトハウンドのような特殊な犬種は、視覚の脳の反応がより細かく調整されている可能性がありますが、私たちは、個々の気質と訓練が犬の脳から回復可能なものの主要な決定要因である可能性が高いと考えています。

これらの種の違いは、犬がビデオのどの側面に注意を払っていたのかという疑問を提起します。この質問に答える1つのアプローチは、より単純なビデオ刺激に依存しています。次に、たとえば、人間、犬、車の孤立した画像を、中立的な背景に対して個別に、または一緒に使用することで、犬の顕著な次元をリバースエンジニアリングできる可能性があります。しかし、これは方法論的に非効率的であり、現実世界からの刺激をさらに弱めます。注意の問題は、デコードアプローチのみによって、事実上、モデルのパフォーマンスを使用して、何に注意が向けられているかを決定することによって解決できる43。これらの線に沿って、ここでの結果は、人間が俳優と行動の両方に注意を払った一方で、犬は行動自体にもっと集中していたことを示唆しています。これは、個人が遊んでいるときと食事をしているときの動きの頻度など、低レベルの運動機能の違いによるものかもしれませんし、より高いレベルでのこれらの活動のカテゴリー表現によるものかもしれません。犬の皮質全体に情報量の多いボクセルが分布していることは、これらの表現が視覚領域に限定される低レベルの特徴だけではないことを示唆しています。より多様なビデオ刺激を用いたさらなる研究により、イヌによるカテゴリー識別における運動の役割が明らかになるかもしれない。

要約すると、この研究は、人間の皮質に対して行われるのと同じ方法でfMRIを使用して犬の皮質から自然な視覚情報を回復することの実現可能性を実証しました。このデモンストレーションは、音や匂いがなくても、複雑なシーンの顕著な次元がビデオを見ている犬によってエンコードされ、これらの次元が犬の脳から回復できることを示しています。第二に、この種のタスクを実行できる犬の数が少ないことに基づいて、情報は人間で通常見られるよりも皮質に広く分布している可能性があり、行動の種類は、アクターやオブジェクトのアイデンティティよりも簡単に回復できるようです。これらの結果は、イヌがビデオ画面など、人間と共有する環境をどのように認識しているかを調べる新たな方法を開くものであり、イヌや他の霊長類以外の動物がどのように世界を「見る」かについての将来の探求のための豊富な道筋を示唆している。

開示事項

何一つ。

謝辞

この分析の開発に有益な洞察を提供してくださったKate Revill氏、Raveena Chhibber氏、Jon King氏、MRI用の犬の募集と訓練を支援してくださったMark Spivak氏、ビデオ制作とラベリングに協力してくださったPhyllis Guo氏に感謝します。また、献身的な犬の飼い主であるレベッカ・ビーズリー(デイジー)とアシュウィン・サハルダンデ(ブボ)にも感謝します。ヒト研究は、国立眼科研究所からの助成金(Grant R01 EY029724 to D.D.D.)によって支援されました。

資料

| Name | Company | Catalog Number | Comments |

| 3 T MRI Scanner | Siemens | Trio | |

| Audio recordings of scanner noise | homemade | none | |

| Camera gimbal | Hohem | iSteady PRO 3 | |

| Dog-appropriate videos | homemade | none | |

| fMRI processing software | AFNI | 20.3.01 | |

| Mock scanner components | homemade | none | Mock head coil and scanner tube |

| Neural net software | Ivis | 1.7.1 | |

| Optical flow software | OpenCV | 4.2.0.34 | |

| Projection system for scanner | homemade | none | |

| Trophy Cam HD | Bushnell | 119874 | |

| Video camera | GoPro | HERO7 | |

| Visualization software | ITK-SNAP | 3.6.0 | |

| Windows Video Editor | Microsoft | Windows 11 version |

参考文献

- Mishkin, M., Ungerleider, L. G., Macko, K. A. Object vision and spatial vision: Two cortical pathways. Trends in Neurosciences. 6, 414-417 (1983).

- de Haan, E. H. F., Cowey, A. On the usefulness of 'what' and 'where' pathways in vision. Trends in Cognitive Sciences. 15 (10), 460-466 (2011).

- Freud, E., Plaut, D. C., Behrmann, M. What' is happening in the dorsal visual pathway. Trends in Cognitive Sciences. 20 (10), 773-784 (2016).

- Goodale, M. A., Milner, A. D. Separate visual pathways for perception and action. Trends in Neurosciences. 15 (1), 20-25 (1992).

- Schenk, T., McIntosh, R. D. Do we have independent visual streams for perception and action? Do we have independent visual streams for perception and action. Cognitive Neuroscience. 1 (1), 52-78 (2010).

- Andics, A., Gácsi, M., Faragó, T., Kis, A., Miklós, &. #. 1. 9. 3. ;. Report voice-sensitive regions in the dog and human brain are revealed by comparative fMRI. Current Biology. 24 (5), 574-578 (2014).

- Berns, G. S., Brooks, A. M., Spivak, M. Functional MRI in awake unrestrained dogs. PLoS One. 7 (5), 38027 (2012).

- Karl, S., et al. Training pet dogs for eye-tracking and awake fMRI. Behaviour Research Methods. 52, 838-856 (2019).

- Bunford, N., et al. Comparative brain imaging reveals analogous and divergent patterns of species and face sensitivity in humans and dogs. Journal of Neuroscience. 40 (43), 8396-8408 (2020).

- Cuaya, L. V., Hernández-Pérez, R., Concha, L. Our faces in the dog's brain: Functional imaging reveals temporal cortex activation during perception of human faces. PLoS One. 11 (3), 0149431 (2016).

- Dilks, D. D., et al. Awake fMRI reveals a specialized region in dog temporal cortex for face processing. PeerJ. 2015 (8), 1115 (2015).

- Prichard, A., et al. 2D or not 2D? An fMRI study of how dogs visually process objects. Animal Cognition. 24 (5), 1143-1151 (2021).

- Thompkins, A. M., et al. Separate brain areas for processing human and dog faces as revealed by awake fMRI in dogs (Canis familiaris). Learning & Behavior. 46 (4), 561-573 (2018).

- Zhang, K., Sejnowski, T. J. A universal scaling law between gray matter and white matter of cerebral cortex. Proceedings of the National Academy of Sciences of the United States of America. 97 (10), 5621-5626 (2000).

- Bradshaw, J., Rooney, N., Serpell, J. Dog Social Behavior and Communication. The Domestic Dog: Its Evolution, Behavior and Interactions with People. , 133-160 (2017).

- Prichard, A., et al. The mouth matters most: A functional magnetic resonance imaging study of how dogs perceive inanimate objects. The Journal of Comparative Neurology. 529 (11), 2987-2994 (2021).

- Haxby, J. V., Connolly, A. C., Guntupalli, J. S. Decoding neural representational spaces using multivariate pattern analysis. Annual Review of Neuroscience. 37, 435-456 (2014).

- Kamitani, Y., Tong, F. Decoding the visual and subjective contents of the human brain. Nature Neuroscience. 8 (5), 679-685 (2005).

- Kay, K. N., Naselaris, T., Prenger, R. J., Gallant, J. L. Identifying natural images from human brain activity. Nature. 452 (7185), 352-355 (2008).

- Nishimoto, S., et al. Reconstructing visual experiences from brain activity evoked by natural movies. Current Biology. 21 (19), 1641-1646 (2011).

- vander Meer, J. N., Breakspear, M., Chang, L. J., Sonkusare, S., Cocchi, L. Movie viewing elicits rich and reliable brain state dynamics. Nature Communications. 11 (1), 5004 (2020).

- Huth, A. G., De Heer, W. A., Griffiths, T. L., Theunissen, F. E., Gallant, J. L. Natural speech reveals the semantic maps that tile human cerebral cortex. Nature. 532 (7600), 453-458 (2016).

- Kriegeskorte, N., et al. Matching categorical object representations in inferior temporal cortex of man and monkey. Neuron. 60 (6), 1126-1141 (2008).

- Ehsani, K., Bagherinezhad, H., Redmon, J., Mottaghi, R., Farhadi, A. Who let the dogs out? Modeling dog behavior from visual data. Proceedings of the IEEE Conference on Computer Vision and Pattern. 2018, 4051-4060 (2018).

- Berns, G. S., Brooks, A., Spivak, M. Replicability and heterogeneity of awake unrestrained canine fMRI responses. PLoS One. 9 (5), 98421 (2013).

- Cox, R. W. AFNI: Software for analysis and visualization of functional magnetic resonance neuroimages. Computers and Biomedical Research. 29 (3), 162-173 (1996).

- Prichard, A., Chhibber, R., Athanassiades, K., Spivak, M., Berns, G. S. Fast neural learning in dogs: A multimodal sensory fMRI study. Scientific Reports. 8, 14614 (2018).

- Russ, B. E., Kaneko, T., Saleem, K. S., Berman, R. A., Leopold, D. A. Distinct fMRI responses to self-induced versus stimulus motion during free viewing in the macaque. The Journal of Neuroscience. 36 (37), 9580-9589 (2016).

- Farnebäck, G., Bigun, J., Gustavsson, T. Two-Frame Motion Estimation Based on Polynomial Expansion. In Image Analysis. Scandinavian Conference on Image Analysis. Lecture Notes in Computer Science. 2749, 363-370 (2003).

- Elias, D. O., Land, B. R., Mason, A. C., Hoy, R. R. Measuring and quantifying dynamic visual signals in jumping spiders). Journal of Comparative Physiology A. 192, 799-800 (2006).

- Szubert, B., Cole, J. E., Monaco, C., Drozdov, I. Structure-preserving visualisation of high dimensional single-cell datasets. Scientific Reports. 9, 8914 (2019).

- Tian, H., Tao, P. IVIS dimensionality reduction framework for biomacromolecular simulations. Journal of Chemical Information and Modeling. 60 (10), 4569-4581 (2020).

- Hebart, M. N., Gorgen, K., Haynes, J. The decoding toolbox (TDT): A versatile software package for multivariate analyses of functional imaging data. Frontiers in Neuroinformatics. 8, 88 (2015).

- Mazziotta, J., et al. A probabilistic atlas and reference system for the human brain: International Consortium for Brain Mapping (ICBM). Philosophical Transactions of the Royal Society B: Biological Sciences. 356 (1412), 1293-1322 (2001).

- Johnson, P. J., et al. Stereotactic cortical atlas of the domestic canine brain. Scientific Reports. 10, 4781 (2020).

- Yushkevich, P. A., et al. User-guided 3D active contour segmentation of anatomical structures: Significantly improved efficiency and reliability. NeuroImage. 31 (3), 1116-1128 (2006).

- Fürnkranz, J., Hüllermeier, E., Loza Mencía, E., Brinker, K. Multilabel classification via calibrated label ranking. Machine Learning. 73 (2), 133-153 (2008).

- Sonkusare, S., Breakspear, M., Guo, C. Naturalistic stimuli in neuroscience: Critically acclaimed. Trends in Cognitive Sciences. 23 (8), 699-714 (2019).

- vander Zee, E., Zulch, H., Mills, D. Word generalization by a dog (Canis familiaris): Is shape important. PLoS One. 7 (11), 49382 (2012).

- Bekoff, M. Observations of scent-marking and discriminating self from others by a domestic dog (Canis familiaris): Tales of displaced yellow snow. Behavioural Processes. 55 (2), 75-79 (2001).

- Berns, G. S., Brooks, A. M., Spivak, M. Scent of the familiar: An fMRI study of canine brain responses to familiar and unfamiliar human and dog odors. Behavioural Processes. 110, 37-46 (2015).

- Schoon, G. A. A., de Bruin, J. C. The ability of dogs to recognize and cross-match human odours. Forensic Science International. 69 (2), 111-118 (1994).

- Kamitani, Y., Tong, F. Decoding seen and attended motion directions from activity in the human visual cortex. Current Biology. 16 (11), 1096-1102 (2006).

転載および許可

このJoVE論文のテキスト又は図を再利用するための許可を申請します

許可を申請さらに記事を探す

This article has been published

Video Coming Soon

Copyright © 2023 MyJoVE Corporation. All rights reserved