このコンテンツを視聴するには、JoVE 購読が必要です。 サインイン又は無料トライアルを申し込む。

Method Article

複雑な航空タスク中のアイトラッキングによる情報処理への洞察

要約

アイトラッキングは、情報処理をプローブするための非侵襲的な方法です。この記事では、アイトラッキングを使用して、短時間パイロットのフライトシミュレーション緊急タスク中の視線行動を研究する方法について説明します(つまり、<350飛行時間)。

要約

アイトラッキングは、スキルパフォーマンスの根底にある認知、知覚、感覚運動のプロセスについての洞察を得るためのプロキシとして広く使用されてきました。これまでの研究で、従来の視線測定と高度な視線測定では、パイロットの専門知識、認知負荷、疲労、さらには状況認識 (SA) にしっかりとした違いがあることがわかっています。

この研究では、ウェアラブル アイ トラッカーと、忠実度の高い飛行モーションレス シミュレーターで自然な頭と目の動き (つまり、視線) をキャプチャする視線マッピング アルゴリズムを使用する方法について説明します。この論文で概説した方法では、参加者が見ている場所に関連するより多くのコンテキストを提供する関心領域(AOI)ベースの視線分析と、参加者が固定情報をどれだけ効率的に処理しているかを示す滞在時間について説明します。このプロトコルは、予期せぬ飛行中の緊急事態に応じた視線行動の変化を評価するためのウェアラブルアイトラッカーとコンピュータービジョンアルゴリズムの有用性を示しています。

代表的な結果から、緊急事態が発生した際に視線に大きな影響が及んだことが示された。具体的には、注意配分、視線拡散、視線シーケンスの複雑さが大幅に減少し、緊急時のフロントウィンドウ外視と対気速度計に大きく集中するようになりました( すべてのp 値は0.05<)。視線行動の時空間特性と航空領域における情報処理との関係を理解するために、高忠実度の静止飛行シミュレーション環境でウェアラブルアイトラッカーを使用することの有用性と限界について説明します。

概要

人間は主に、まず目と頭を動かして視線 (つまり、視線) を特定のオブジェクトまたは関心のある場所に向けることによって、周囲の世界と対話します。これは、パイロットが複数の競合する刺激に直面する航空機のコックピットなどの複雑な環境に特に当てはまります。視線の動きは、人間が安全かつ柔軟に環境と対話できるようにする高解像度の視覚情報の収集を可能にします1、これは航空において最も重要なことです。研究によると、眼球運動と視線行動は、さまざまなタスク1,2,3にわたる根底にある知覚、認知、および運動プロセスへの洞察を提供することが示されています。さらに、どこを見るかは、上肢の動きの計画と実行に直接影響します3。したがって、航空タスク中の視線行動分析は、客観的で非侵襲的な方法を提供し、眼球運動パターンが情報処理とパフォーマンスのさまざまな側面にどのように関連しているかを明らかにする可能性があります。

いくつかの研究では、さまざまな実験室のパラダイム、および複雑な現実世界のタスク(航空機の操作など)にわたる視線とタスクのパフォーマンスとの関連が実証されています。例えば、タスクに関連する領域は、より頻繁に、より長い合計時間で固定される傾向があり、固定位置、頻度、および滞留時間が、神経認知および航空タスクにおける注意の割り当ての代理であることが示唆されている4,5,6。非常に成功したパフォーマーと専門家は、あまり成功していないパフォーマーや初心者と比較して、タスククリティカルな領域に対して有意な固定バイアスを示しています4,7,8。視線の時空間的側面は、さまざまな関心領域(AOI)にわたる滞在時間パターンの変化や、固定分布の尺度(つまり、定常視エントロピー:SGE)を通じて捉えられます。実験室ベースのパラダイムの文脈では、平均凝視時間、スキャンパス長、および視線シーケンスの複雑さ(すなわち、視線遷移エントロピー:GTE)は、問題解決とより困難なタスクの目標/解決策を詳述するために必要なスキャンと処理の増加により増加する傾向があります4,7。

逆に、航空研究では、スキャンパスの長さと視線シーケンスの複雑さは、タスクの複雑さと認知負荷とともに減少することが示されています。この不一致は、タスクのコンポーネントと採用されているパラダイムの要求を理解することが、視線メトリックの正確な解釈にとって重要であるという事実を浮き彫りにしています。全体として、これまでの研究は、視線測定が、タスクの難易度、認知負荷、およびタスクのパフォーマンスの違いの根底にあるタスク固有の情報処理について有意義で客観的な洞察を提供することを裏付けています。アイトラッキング技術(携帯性、キャリブレーション、コスト)の進歩に伴い、「野生」での視線行動の調査は、医学9,10,11および航空12,13,14の分野における職業訓練の進歩に向けて具体的な応用が可能な新たな研究分野です。

現在の研究は、視線ベースのメトリックを使用して情報処理に関する洞察を得ることの有用性をさらに調査することを目的としています。具体的には、短時間パイロットの緊急飛行シミュレーションタスク中にウェアラブルアイトラッカーを使用します。この研究は、頭部安定化アイトラッカー(EyeLink II)を使用して、飛行困難(気象条件の変化)の関数としての視線行動指標の違いを調べた以前の研究を拡張したものです5。この原稿で提示された研究は、バーチャルリアリティシステム15でアイトラッキングを使用するための方法論的および分析的アプローチを記述した他の研究にも拡張されています。私たちの研究では、より忠実度の高いモーションレスシミュレーターを使用し、眼球運動データ(つまり、エントロピー)の追加分析を報告しています。このタイプの分析は、以前の論文で報告されています。ただし、現在の文献の限界は、分析ステップの報告における標準化の欠如です。例えば、関心領域がどのように定義されているかを報告することは、結果として得られるエントロピー値16に直接影響を与えるため、非常に重要です。

要約すると、現在の研究では、従来の動的な視線行動の指標を調査し、タスクの難易度は飛行中の緊急シナリオ(つまり、予期しない完全なエンジン故障)の導入によって操作されました。飛行中の緊急シナリオの導入により、より困難なタスク条件下での情報処理の根底にある視線行動の変化についての洞察が得られると期待されていました。ここで報告した研究は、コンピテンシーベースのパイロットトレーニングに情報を提供するためのフライトシミュレータでのアイトラッキングの有用性を調査した大規模な研究の一部です。ここで紹介した結果は、まだ公開されていません。

プロトコル

以下のプロトコルは、ウェアラブルアイトラッカーとフライトシミュレータを含む研究に適用することができます。現在の研究では、フライトシミュレータで複雑な航空関連のタスクとともに記録された視線追跡データが含まれています( 資料の表を参照)。このシミュレータは、セスナ 172 を代表するように構成され、必要な計器パネル (蒸気計構成)、アビオニクス/GPS システム、オーディオ/ライト パネル、ブレーカー パネル、および飛行制御ユニット (FCU) と共に使用されました ( 図 1 を参照)。この研究で使用されたフライトシミュレータデバイスは、トレーニング目的で認定可能であり、低リスク環境でエンジン故障などのさまざまな緊急シナリオに対応するために必要なスキルセットを訓練するために地元のフライトスクールによって使用されています。この研究の参加者は全員ライセンスを持っていました。そのため、彼らは以前にトレーニングの過程でエンジン故障シミュレーターのシナリオを経験しました。この研究は、ウォータールー大学の研究倫理局(43564;日付:2021年11月17日)。すべての参加者(N = 24、男性14人、女性10人、平均年齢= 22歳、飛行時間範囲:51-280時間)は、書面によるインフォームドコンセントを提供しました。

図1:フライトシミュレータの環境。 フライト シミュレータの環境の図。コックピットに対する参加者の視点は、カリフォルニア州オンタリオ州ブレスラウのウォータールー国際空港への風下から基地、最終アプローチに事前設定されたセスナ 172 を操縦するパイロットの視点を再現しました。オレンジ色のボックスは、視線分析で使用される 10 の主要な関心領域を表しています。これには、(1) 対気速度、(2) 姿勢、(3) 高度計、(4) 方向計、(5) 方位、(6) 垂直速度、(7) パワー インジケーター、(8) フロント ウィンドウ、(9) 左ウィンドウ、(10) ライト ウィンドウが含まれます。この図は、Ayala et al.5から修正されました。 この図の拡大版を表示するには、ここをクリックしてください。

1. 参加者のスクリーニングとインフォームドコンセント

- 包含/除外基準 2,5 に基づく自己申告アンケートで参加者をスクリーニングします: 少なくとも Private Pilot License (PPL) の所持、正常または正常な視力、および神経精神/神経障害または学習障害による以前の診断がない。

- 実験者と監督飛行教官/シミュレーター技術者が担当する詳細なブリーフィングを通じて、研究の目的と手順について参加者に伝えます。教育機関の倫理審査委員会が承認した同意文書に記載されているリスクを確認します。潜在的なリスクに関する質問に答えてください。研究手順を開始する前に、書面によるインフォームドコンセントを取得します。

2. ハードウェア/ソフトウェアの要件とスタートアップ

- フライト シミュレータ (通常はシミュレータ技術者が完成させます)

- シミュレーターとプロジェクターの画面をオンにします。プロジェクターの1つが他のプロジェクターと同時に電源が入らない場合は、シミュレーターを再起動してください。

- 指示画面で、[プリセット]タブを押し、必要な位置および/または天気のプリセットが利用可能であることを確認します。必要に応じて、新しいタイプのプリセットを作成します。技術者に相談してください。

- コレクションラップトップ

- ラップトップの電源を入れ、資格情報でログインします。

- プロンプトが表示されたら、既存のプロファイルを選択するか、新しい参加者をテストする場合はプロファイルを作成します。または、[ ゲスト ] オプションを選択して、最後のキャリブレーションを上書きします。

- 新しいプロファイルを作成するには、プロファイル リストの最後までスクロールして [追加] をクリックします。

- プロファイル ID を参加者 ID に設定します。このプロファイル ID は、記録が完了した後に視線追跡データを保持するフォルダーにタグを付けるために使用されます。

- メガネのキャリブレーション

注意: 録音するには、メガネをラップトップに接続したままにしておく必要があります。ボックスによるキャリブレーションは、データ収集の開始時に一度だけ完了する必要があります。- アイトラッカーケースを開けて、メガネを取り出します。

- ラップトップからメガネにUSBからマイクロUSBケーブルを接続します。ラップトップでプロンプトが表示されたら、ファームウェアを更新します。

- アイトラッカーケース内の黒いキャリブレーションボックスを見つけます。

- コレクション ラップトップの 視線追跡ハブで、[ ツール] |デバイスのキャリブレーション。

- メガネをボックスの中に入れ、ポップアップウィンドウで [開始 ]を押してキャリブレーションを開始します。

- キャリブレーションが完了したら、メガネを箱から取り出します。

- ノーズピースフィット

- ノーズピースを選択します。

- 参加者にコックピットに座って眼鏡をかけるように指示します。

- アイトラッキングハブで、[ファイル] |設定 |鼻の魔法使い。

- 画面の左側にある メガネボックスのフィット感を調整します 。フィット感が エクセレントの場合は、次のステップに進みます。それ以外の場合は、ボックスをクリックします。

- 画面に表示される推奨フィットの指示に従うように参加者に伝えます:ノーズピースをセットし、メガネを快適に座るように調整し、ラップトップをまっすぐ前を見ます。

- 必要に応じて、ノーズピースを交換します。ノーズピースを真ん中でつまんでグラスから引き出し、次に別のノーズピースをスライドさせて入れます。参加者に最も適したノーズピースが特定されるまで、さまざまなノーズピースのテストを続けます。

- 航空交通管制(ATC)コール

注:研究でATC通話が必要な場合は、参加者に自分のヘッドセットを持参させるか、ラボヘッドセットを使用してください。ヘッドセットは頭の上の眼鏡を動かすことができるため、参加者がヘッドセットを装着した後にのみ眼球のキャリブレーションを完了し、キャリブレーションの精度に影響します。- ヘッドセットがインストルメントパネルの左下にあるジャックに接続されていることを確認します。

- 参加者にヘッドセットを装着するように指示します。録音が終了するまで、触れたり外したりしないように頼んでください。

注意: ヘッドセット(したがって、メガネ)を移動するたびに再キャリブレーションが必要です。 - ラジオチェックをしてください。

- 眼球キャリブレーション

注:参加者が頭の上の眼鏡をずらすたびに、眼球のキャリブレーションを繰り返す必要があります。試用が終わるまで、参加者にメガネに触れないように頼んでください。- アイトラッキングハブで、画面の左側にあるパラメータボックスに移動します。

- キャリブレーションモードを確認し、それに応じて固定視線または固定ヘッドを選択します。

- キャリブレーションポイントが5 x 5グリッドで、合計25ポイントであることを確認します。

- 検証モードを確認し、キャリブレーションモードと一致していることを確認します。

- アイトラッキングの出力を調べ、調査のために記録する必要があるすべてのものがチェックボックスを使用してチェックされていることを確認します。

- [File |設定 |Advanced を選択し、 サンプリングレート が 250 Hzであることを確認します。

- マウスを使用して、画面上の [視線追跡を調整する] チェックボックスをオンにします。キャリブレーションの手順は、モードによって異なります。現在の研究を追うには、 固定視線 キャリブレーションモードを使用します:ボックスに頭が黒い四角と重なり、それらが整列するように参加者に頭を動かすように指示します。次に、参加者に黒い四角の十字線に視線を合わせてもらい、スペースバーを押します。

- [Validate your setup] ボックスを押します。手順は、手順 2.6.3 と同じです。検証数値MAE(Mean Absolute Error)が<1°であることを確認します。そうでない場合は、手順 2.6.3 と 2.6.4 を繰り返します。

- [Save Calibration]を押して、キャリブレーションと検証が完了するたびにキャリブレーションをプロファイルに保存します。

- アイトラッキングハブで、画面の左側にあるパラメータボックスに移動します。

- iPadの使い方

メモ: iPadはインストゥルメントパネルの左側にあります( 図1参照)。これは通常、フライト後のアンケートに使用されます。- iPadの電源を入れ、インターネットに接続されていることを確認します。

- Safariでウィンドウを開き、調査票のリンクを入力します。

3. データ収集

注: 試行ごとにこれらの手順を繰り返します。ラップトップはコックピットの外側のベンチに置くことをお勧めします。

- フライト シミュレータ コンピュータの 指示 画面で [プリセット] を押し、シミュレートする 位置 プリセットを選択します。 [適用 ] ボタンを押し、シミュレーターを囲む画面を監視して、変更が行われることを確認します。

- 手順3.1を繰り返して、 天気 プリセットを適用します。

- 参加者に、試験または飛行経路について具体的な指示を与えます。これには、インストルメントパネルの設定を変更する前に変更するように指示することも含まれます。

- 指示画面で、オレンジ色のSTOPPEDボタンを押してデータ収集を開始します。色が緑色に変わり、テキストに「FLYING」と表示されます。参加者に口頭での合図を与えて、航空機の飛行を開始できることを参加者に知らせてください。オレンジ色のストップボタンを押すと「3、2、1、コントロールがあります」という合図がおすすめです。

- コレクションラップトップで、[ 録音の開始] を押して、アイトラッカーデータがフライトシミュレーターのデータと同期されるようにします。

- 参加者が周回を完了して着陸したら、航空機の動きが止まるのを待ちます。

注:後処理中は待つことが重要です。対地速度が 0 に落ち着くと、データは切り捨てられます。これにより、すべての試験のエンドポイントに一貫性が保たれます。 - 指示画面で、緑色の フライング ボタンを押します。色がオレンジ色に戻り、テキストに STOPPED と表示されます。データ収集が終了する間、このステップで口頭で合図を出します。おすすめの合図は「3、2、1、止まる」です。

- 参加者に iPad で公判後の質問票に回答するように指示します。次の試用版のためにページを更新します。

注:現在の研究では、唯一の試験後アンケート17として、状況認識評価手法(SART)自己評価アンケートを使用しました。

4. データ処理と分析

- フライトシミュレータのデータ

注 : フライト シミュレータからコピーされた .csv ファイルには、シミュレータで制御できる 1,000 を超えるパラメータが含まれています。関心のある主なパフォーマンス指標を 表 1 にリストし、説明します。- 各参加者について、タスク条件全体のパーセンテージを取ることにより、式 (1) を使用して成功率を計算します。失敗した試行は、シミュレータ内でプログラムされた所定の基準によって識別され、平面の向きと垂直速度により、タッチダウン時に試行が自動的に終了します。この基準が実際の航空機の制限と一致していることを確認するために、試験後の検証を実施します (つまり、セスナ 172 の着陸装置の損傷/衝突は、着陸時に垂直速度 > 700 フィート/分 [fpm] で明らかです)。

成功率 = (1)

(1)

注:成功率の値が低いほど、着陸成功の試みが減少するため、結果が悪いことを示します。 - 試行ごとに、飛行機が滑走路で停止したことを示すタイムスタンプ (つまり、GroundSpeed = 0 knots) に基づいて 完了時間 を計算します。

注: 完了時間が短いほど、必ずしもパフォーマンスが向上するとは限りません。タスクの条件(つまり、追加の風、緊急シナリオなど)が完了時間にどのように影響するかを理解するには、注意を払う必要があります。 - 各試行で、航空機が最初に滑走路に着陸したときの航空機の垂直速度 (fpm) に基づいて 着陸硬度 を決定します。この値は、 AircraftOnGround ステータスが 0 (空中) から 1 (地上) に最初に変更されたときと同じタイムスタンプで取得されることを確認します。

注: -700 fpm から 0 fpm の範囲内の値は安全であると見なされ、0 に近い値はソフト ランディング (つまり、より良い) を表します。負の値は下向きの垂直速度を表します。正の値は、上向きの垂直速度を表します。 - 各試行で、着陸座標と滑走路上の基準点 (500 フィート マーカーの中心) との差に基づいて 着陸誤差 (°) を計算します。基準点を使用して、式(2)を使用して着陸誤差を計算します。

差 = √(((Δ 緯度)2 + (Δ 経度)2) (2)

注意: 1°未満の値は通常の5,15であることを示しています。値が大きいほど、着陸ゾーンから遠く離れた航空機の着陸ポイントに関連付けられた着陸エラーが大きいことを示します。 - 各タスク条件の各パフォーマンス結果変数について、すべての参加者の平均を計算します。これらの値を報告します。

- 各参加者について、タスク条件全体のパーセンテージを取ることにより、式 (1) を使用して成功率を計算します。失敗した試行は、シミュレータ内でプログラムされた所定の基準によって識別され、平面の向きと垂直速度により、タッチダウン時に試行が自動的に終了します。この基準が実際の航空機の制限と一致していることを確認するために、試験後の検証を実施します (つまり、セスナ 172 の着陸装置の損傷/衝突は、着陸時に垂直速度 > 700 フィート/分 [fpm] で明らかです)。

- 状況認識データ

- 各試行で、SA17 の 10 次元にわたる自己報告の SART スコアに基づいて SA スコアを計算します。

- SART質問票17 を使用して、全体的なタスクの難易度に関する参加者の主観的な回答、およびタスクの実行中にどれだけの注意リソースが利用可能で費やしたかについての印象を決定します。

- 7 段階のリッカート スケールを使用して、参加者に、状況の複雑さ、注意の分割、予備の精神的能力、情報の量と質など、調査の質問で自分の知覚した経験を評価するように依頼します。

- これらのスケールを、注意要求 (Demand)、注意供給 (Supply)、状況理解 (Understanding) のより大きな次元に組み合わせます。

- これらの評価を使用して、式 (3) に基づいて SA の測定値を計算します。

SA = 理解 - (需要供給) (3)

注:理解の尺度を提供するために組み合わされたスケールのスコアが高いことは、参加者が目の前のタスクをよく理解していることを示唆しています。同様に、供給領域のスコアが高いことは、参加者が特定のタスクに専念する注意力がかなりあることを示唆しています。対照的に、需要スコアが高い場合は、タスクを完了するために大量の注意力のあるリソースが必要であることを示しています。これらのスコアは、独立した尺度として使用されるのではなく、条件 (つまり、簡単な条件と難しい条件) 間で比較された場合に最もよく解釈されることを明確にすることが重要です。

- データ収集が完了したら、各タスク条件(基本、緊急)について、すべての参加者の平均を計算します。これらの値を報告します。

- 各試行で、SA17 の 10 次元にわたる自己報告の SART スコアに基づいて SA スコアを計算します。

- アイトラッキングデータ

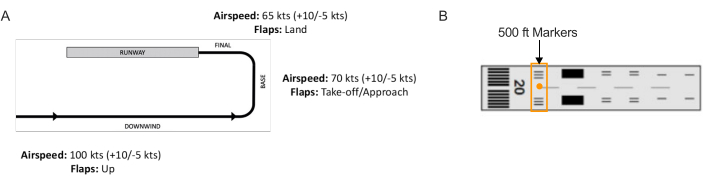

- 視線マッピングで使用する AOI を手動で定義するには、視線追跡バッチ スクリプトを使用します。このスクリプトは、キー フレーム選択用の新しいウィンドウを開き、分析されるすべてのキー AOI を明確に表示します。ビデオをスクロールして、すべてのAOIがはっきりと見えるフレームを選択します。

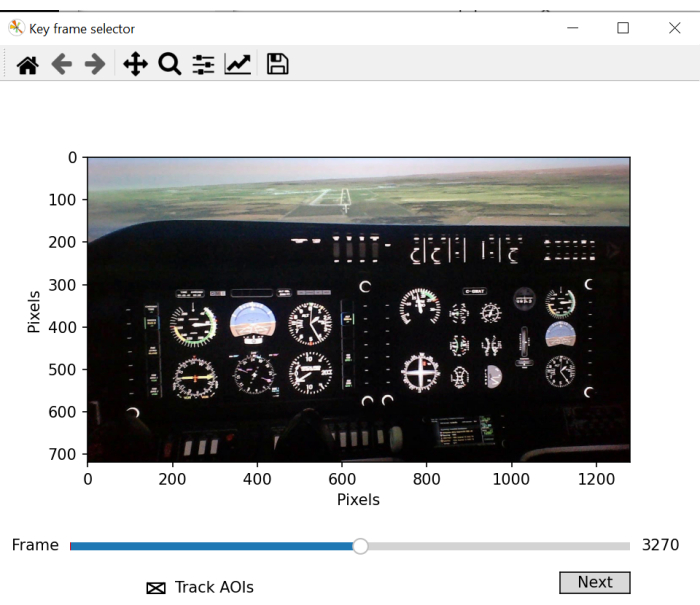

- 画面の指示に従って、フレームの領域に長方形を描き、ビデオ全体を通して一意に表示され、安定した状態を保ちます。

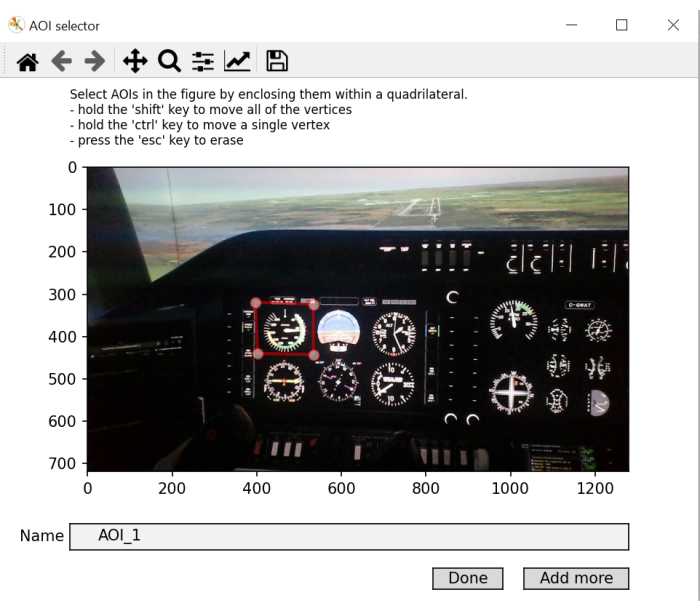

注:この手順の目的は、頭の動きがビデオ録画の過程で環境内のオブジェクトの位置を変更するため、ビデオ録画全体で使用できる「画面内」座標フレームを生成することです。 - 画像内の各 AOI に対して、一度に 1 つずつ四角形を描きます。それに応じて名前を付けます。[ さらに追加 ] をクリックして新しい AOI を追加し、最後の AOI で [完了] を押します。特定の固定中に視線座標が "画面内" 座標フレームで定義されているオブジェクト空間内に配置される場合は、その固定にそれぞれの AOI ラベルを付けます。

注: この手順の目的は、視線入力座標と画面内座標を比較するときに参照として使用されるオブジェクト座標のライブラリを生成することです。

通常、AOI は 10 個ありますが、これはフライト シミュレータの設定方法によって異なります。インストルメントパネルは異なる場合があります。以前の研究 5,18 に沿って、現在の研究では、対気速度、姿勢、高度計、ターン コーディネーター、方位、垂直速度、電力、フロント ウィンドウ、左ウィンドウ、 および右ウィンドウ (図 1 を参照) の AOI を使用しています。 - スクリプトで AOI の処理を開始し、固定データを生成します。ビデオ上のサッカードと固定を示すプロットが生成されます。

- fixations.csv と aoi_parameters.yaml の 2 つの新しいファイルが作成されます。バッチ プロセッサは、各試行および各参加者の視線データの後処理を完了します。

注:関心のある主なアイトラッキング測定値を 表2 にリストアップし、各試行のAOIごとに計算します。 - 試行ごとに、fixation.csv ファイルで生成されたデータに基づいて、各 AOI の従来の視線メトリック 4,5 を計算します。

注:ここでは、特定のAOIの固定の合計をすべての固定の合計で除算し、商に100を掛けて特定のAOIに費やされた時間の割合を取得することによって計算される 滞在時間(%)に焦点を当てています。計算された滞留時間から得られるネガティブ/ポジティブな解釈は、本来はありません。それらは、主に注意が向けられている場所を示します。平均固定時間が長いほど、処理要求が増加することを示しています。 - 試行ごとに、式 (4) を使用して点滅速度を計算します。

点滅回数=合計点滅/完了時間(4)

注:以前の研究では、まばたき速度は認知負荷2,6,13,19,20に反比例することが示されています。 - 各試行について、式 (5)21 を使用して SGE を計算します。

(5)

(5)

ここで、 v は i番目の AOI を表示する確率、 V は AOI の数です。

注:SGE値が高いほど固定分散が大きくなり、値が低いほど固定分散がより集中的に割り当てられていることを示しています22。 - 各試行について、式 (6)23 を使用して GTE を計算します。

(6)

(6)

ここで、V は i番目の AOI を表示する確率、M は i番目の AOI を以前に表示した場合に j番目の AOI を表示する確率です。

注:GTE値が高いほど、予測不可能で複雑なビジュアルスキャンパスに関連付けられ、GTE値が低いほど、予測可能で日常的なビジュアルスキャンパスを示します。 - 各アイトラッキング出力変数(および指示されている場合はAOI)と各タスク条件について、すべての参加者 の平均 を計算します。これらの値を報告します。

| 用語 | 定義 |

| 成功率 (%) | 上陸試験の成功率 |

| 完了時間 (秒) | 着陸シナリオの開始から飛行機が滑走路上で完全に停止するまでの時間 |

| 着陸硬度(fpm) | タッチダウンポイントでのまともな率 |

| 着陸誤差 (°) | 着陸地点における飛行機の中心と 500 フィートの滑走路マーカーの中心との差 |

表 1: シミュレーターのパフォーマンス結果変数。 航空機の性能依存変数とその定義。

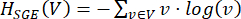

図2:着陸シナリオの飛行経路。 (A) すべての試験で完了した着陸回路、および (B) 着陸ゾーンの基準点として使用された 500 フィートのマーカー (つまり、中央のオレンジ色の円) を備えた滑走路の概略図。 この図の拡大版を表示するには、ここをクリックしてください。

図 3: 対象地域のマッピング。 フレーム選択のウィンドウを示すバッチ スクリプトの図。最適なフレームを選択するには、マッピングする対象領域のほとんどまたはすべてを含むビデオ フレームを選択する必要があります。 この図の拡大版を表示するには、ここをクリックしてください。

図4:「画面内」座標をマッピングする関心領域の生成。 「画面内」座標選択のウィンドウを示すバッチスクリプトの図。この手順では、記録全体を通して表示され、画像に固有で、静的なままの正方形/長方形の領域を選択します。 この図の拡大版を表示するには、ここをクリックしてください。

図 5: マッピングする対象領域の特定。 対象エリアの選択とラベリングを可能にするバッチ スクリプト ウィンドウの図。略語: AOIs = 関心領域。 この図の拡大版を表示するには、ここをクリックしてください。

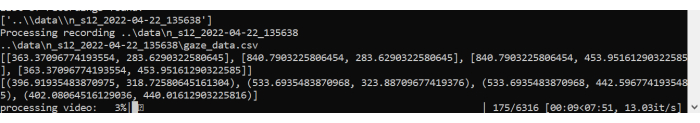

図 6: バッチ スクリプト処理。ビデオを処理するバッチ スクリプトと、試行中に行われた凝視の視線マッピングの図。 この図の拡大版を表示するには、ここをクリックしてください。

| 用語 | 定義 |

| 滞在時間 (%) | すべての AOI に累積されたすべての固定時間の合計に対する、1 つの AOI に累積されたすべての固定時間の合計の割合 |

| 平均固定時間(ms) | 入口から出口までの1つのAOIに対する固定の平均期間 |

| 点滅速度(点滅/秒) | 1秒あたりの点滅回数 |

| SGE(ビット) | 固定分散液 |

| GTE (ビット) | スキャンシーケンスの複雑さ |

| 試合数 | 認知トンネリングイベントの数 (>10 秒) |

| 合計試合時間(秒) | 認知トンネリングイベントの合計時間 |

表2:アイトラッキングの結果変数。 視線行動依存変数とその定義。

結果

タスク要求が飛行性能に与える影響

データは、基本条件と緊急条件の両方で成功した着陸試験に基づいて分析されました。すべての測定値は、対応のあるサンプルの t検定(被験者内因子:課題条件(基本、緊急))に供されました。すべての t検定は、アルファ水準を0.05に設定して実行しました。緊急シナリオの試験中に4人の参加者が墜落し?...

ディスカッション

ここで説明するアイトラッキング法は、ウェアラブルアイトラッカーを介して、フライトシミュレータ環境での情報処理の評価を可能にします。視線行動の空間的および時間的特性を評価することは、高度に制御された実験室パラダイム4,7,28を使用して広く研究されてきた人間の情報処理への洞?...

開示事項

競合する金銭的利益は存在しません。

謝辞

この研究は、カナダの自然科学工学研究評議会(NSERC)のカナダ大学院奨学金(CGS)と、New Frontiers in Research Fundの探査助成金(00753)によって部分的にサポートされています。本資料に記載されている意見、調査結果、結論、または推奨は著者のものであり、必ずしもスポンサーの意見を反映するものではありません。

資料

| Name | Company | Catalog Number | Comments |

| flight simulator | ALSIM | AL-250 | fixed fully immersive flight simulation training device |

| laptop | Hp | Lenovo | eye tracking data collection laptop; requirements: Windows 10 and python 3.0 |

| portable eye-tracker | AdHawk | MindLink eye tracking glasses (250 Hz, <2° gaze error, front-facing camera); eye tracking batch script is made available with AdHawk device purchase |

参考文献

- de Brouwer, A. J., Flanagan, J. R., Spering, M. Functional use of eye movements for an acting system. Trends Cogn Sci. 25 (3), 252-263 (2021).

- Ayala, N., Kearns, S., Cao, S., Irving, E., Niechwiej-Szwedo, E. Investigating the role of flight phase and task difficulty on low-time pilot performance, gaze dynamics and subjective situation awareness during simulated flight. J Eye Mov Res. 17 (1), (2024).

- Land, M. F., Hayhoe, M. In what ways do eye movements contribute to everyday activities. Vision Res. 41 (25-26), 3559-3565 (2001).

- Ayala, N., Zafar, A., Niechwiej-Szwedo, E. Gaze behavior: a window into distinct cognitive processes revealed by the Tower of London test. Vision Res. 199, 108072 (2022).

- Ayala, N. The effects of task difficulty on gaze behavior during landing with visual flight rules in low-time pilots. J Eye Mov Res. 16, 10 (2023).

- Glaholt, M. G. . Eye tracking in the cockpit: a review of the relationships between eye movements and the aviators cognitive state. , (2014).

- Hodgson, T. L., Bajwa, A., Owen, A. M., Kennard, C. The strategic control of gaze direction in the Tower-of-London task. J Cognitive Neurosci. 12 (5), 894-907 (2000).

- van De Merwe, K., Van Dijk, H., Zon, R. Eye movements as an indicator of situation awareness in a flight simulator experiment. Int J Aviat Psychol. 22 (1), 78-95 (2012).

- Kok, E. M., Jarodzka, H. Before your very eyes: The value and limitations of eye tracking in medical education. Med Educ. 51 (1), 114-122 (2017).

- Di Stasi, L. L., et al. Gaze entropy reflects surgical task load. Surg Endosc. 30, 5034-5043 (2016).

- Laubrock, J., Krutz, A., Nübel, J., Spethmann, S. Gaze patterns reflect and predict expertise in dynamic echocardiographic imaging. J Med Imag. 10 (S1), S11906-S11906 (2023).

- Brams, S., et al. Does effective gaze behavior lead to enhanced performance in a complex error-detection cockpit task. PloS One. 13 (11), e0207439 (2018).

- Peißl, S., Wickens, C. D., Baruah, R. Eye-tracking measures in aviation: A selective literature review. Int J Aero Psych. 28 (3-4), 98-112 (2018).

- Ziv, G. Gaze behavior and visual attention: A review of eye tracking studies in aviation. Int J Aviat Psychol. 26 (3-4), 75-104 (2016).

- Ke, L., et al. Evaluating flight performance and eye movement patterns using virtual reality flight simulator. J. Vis. Exp. (195), e65170 (2023).

- Krejtz, K., et al. Gaze transition entropy. ACM Transactions on Applied Perception. 13 (1), 1-20 (2015).

- Taylor, R. M., Selcon, S. J. Cognitive quality and situational awareness with advanced aircraft attitude displays. Proceedings of the Human Factors Society Annual Meeting. 34 (1), 26-30 (1990).

- Ayala, N., et al. Does fiducial marker visibility impact task performance and information processing in novice and low-time pilots. Computers & Graphics. 199, 103889 (2024).

- Recarte, M. &. #. 1. 9. 3. ;., Pérez, E., Conchillo, &. #. 1. 9. 3. ;., Nunes, L. M. Mental workload and visual impairment: Differences between pupil, blink, and subjective rating. Spanish J Psych. 11 (2), 374-385 (2008).

- Zheng, B., et al. Workload assessment of surgeons: correlation between NASA TLX and blinks. Surg Endosc. 26, 2746-2750 (2012).

- Shannon, C. E. A mathematical theory of communication. The Bell System Technical Journal. 27 (3), 379-423 (1948).

- Shiferaw, B., Downey, L., Crewther, D. A review of gaze entropy as a measure of visual scanning efficiency. Neurosci Biobehav R. 96, 353-366 (2019).

- Ciuperca, G., Girardin, V. Estimation of the entropy rate of a countable Markov chain. Commun Stat-Theory and Methods. 36 (14), 2543-2557 (2007).

- Federal aviation administration. . Airplane flying handbook. , (2021).

- Brown, D. L., Vitense, H. S., Wetzel, P. A., Anderson, G. M. Instrument scan strategies of F-117A Pilots. Aviat, Space, Envir Med. 73 (10), 1007-1013 (2002).

- Lu, T., Lou, Z., Shao, F., Li, Y., You, X. Attention and entropy in simulated flight with varying cognitive loads. Aerosp Medicine Hum Perf. 91 (6), 489-495 (2020).

- Dehais, F., Peysakhovich, V., Scannella, S., Fongue, J., Gateau, T. "Automation surprise" in aviation: Real-time solutions. , 2525-2534 (2015).

- Kowler, E. Eye movements: The past 25 years. J Vis Res. 51 (13), 1457-1483 (2011).

- Zafar, A., et al. Investigation of camera-free eye-tracking glasses compared to a video-based system. Sensors. 23 (18), 7753 (2023).

- Leube, A., Rifai, K. Sampling rate influences saccade detection in mobile eye tracking of a reading task. J Eye Mov Res. 10 (3), (2017).

- Diaz-Piedra, C., et al. The effects of flight complexity on gaze entropy: An experimental study with fighter pilots. Appl Ergon. 77, 92-99 (2019).

- Shiferaw, B. A., et al. Stationary gaze entropy predicts lane departure events in sleep-deprived drivers. Sci Rep. 8 (1), 1-10 (2018).

- Parker, A. J., Kirkby, J. A., Slattery, T. J. Undersweep fixations during reading in adults and children. J Exp Child Psychol. 192, 104788 (2020).

- Ayala, N., Kearns, S., Irving, E., Cao, S., Niechwiej-Szwedo, E. The effects of a dual task on gaze behavior examined during a simulated flight in low-time pilots. Front Psychol. 15, 1439401 (2024).

- Ayala, N., Heath, M. Executive dysfunction after a sport-related concussion is independent of task-based symptom burden. J Neurotraum. 37 (23), 2558-2568 (2020).

- Huddy, V. C., et al. Gaze strategies during planning in first-episode psychosis. J Abnorm Psychol. 116 (3), 589 (2007).

- Irving, E. L., Steinbach, M. J., Lillakas, L., Babu, R. J., Hutchings, N. Horizontal saccade dynamics across the human life span. Invest Opth Vis Sci. 47 (6), 2478-2484 (2006).

- Yep, R., et al. Interleaved pro/anti-saccade behavior across the lifespan. Front Aging Neurosci. 14, 842549 (2022).

- Manoel, E. D. J., Connolly, K. J. Variability and the development of skilled actions. Int J Psychophys. 19 (2), 129-147 (1995).

転載および許可

このJoVE論文のテキスト又は図を再利用するための許可を申請します

許可を申請さらに記事を探す

This article has been published

Video Coming Soon

Copyright © 2023 MyJoVE Corporation. All rights reserved