È necessario avere un abbonamento a JoVE per visualizzare questo. Accedi o inizia la tua prova gratuita.

Method Article

Tracciamento oculare durante un'attività aeronautica complessa per approfondimenti sull'elaborazione delle informazioni

In questo articolo

Riepilogo

L'eye tracking è un metodo non invasivo per sondare l'elaborazione delle informazioni. Questo articolo descrive come l'eye tracking può essere utilizzato per studiare il comportamento dello sguardo durante un'attività di emergenza di simulazione di volo nei piloti a basso tempo (ad esempio, <350 ore di volo).

Abstract

L'eye tracking è stato ampiamente utilizzato come proxy per ottenere informazioni sui processi cognitivi, percettivi e sensomotori che sono alla base delle prestazioni delle abilità. Lavori precedenti hanno dimostrato che le metriche dello sguardo tradizionali e avanzate dimostrano in modo affidabile solide differenze nell'esperienza del pilota, nel carico cognitivo, nell'affaticamento e persino nella consapevolezza della situazione (SA).

Questo studio descrive la metodologia per l'utilizzo di un eye tracker indossabile e di un algoritmo di mappatura dello sguardo che cattura i movimenti naturali della testa e degli occhi (cioè lo sguardo) in un simulatore di volo immobile ad alta fedeltà. Il metodo descritto in questo articolo descrive l'analisi dello sguardo basata sull'area di interesse (AOI), che fornisce un contesto più ampio in relazione a dove i partecipanti stanno guardando, e la durata del tempo di permanenza, che indica l'efficienza con cui elaborano le informazioni fissate. Il protocollo illustra l'utilità di un eye tracker indossabile e di un algoritmo di visione artificiale per valutare i cambiamenti nel comportamento dello sguardo in risposta a un'emergenza imprevista in volo.

Risultati rappresentativi hanno dimostrato che lo sguardo è stato influenzato in modo significativo quando è stato introdotto l'evento di emergenza. In particolare, l'allocazione dell'attenzione, la dispersione dello sguardo e la complessità della sequenza degli sguardi sono diminuiti significativamente e si sono concentrati molto sul guardare fuori dal finestrino anteriore e sull'indicatore di velocità durante lo scenario di emergenza (tutti i valori p < 0,05). Vengono discussi l'utilità e i limiti dell'impiego di un eye tracker indossabile in un ambiente di simulazione di volo immobile ad alta fedeltà per comprendere le caratteristiche spazio-temporali del comportamento dello sguardo e la sua relazione con l'elaborazione delle informazioni nel dominio dell'aviazione.

Introduzione

Gli esseri umani interagiscono prevalentemente con il mondo che li circonda muovendo prima gli occhi e la testa per focalizzare la loro linea di vista (cioè lo sguardo) verso un oggetto specifico o un luogo di interesse. Ciò è particolarmente vero in ambienti complessi come le cabine di pilotaggio degli aerei, dove i piloti si trovano di fronte a molteplici stimoli concorrenti. I movimenti dello sguardo consentono la raccolta di informazioni visive ad alta risoluzione che consentono agli esseri umani di interagire con il loro ambiente in modo sicuro e flessibile1, il che è di fondamentale importanza nell'aviazione. Gli studi hanno dimostrato che i movimenti oculari e il comportamento dello sguardo forniscono informazioni sui processi percettivi, cognitivi e motori sottostanti in vari compiti 1,2,3. Inoltre, dove guardiamo ha un'influenza diretta sulla pianificazione e l'esecuzione dei movimenti degli arti superiori3. Pertanto, l'analisi del comportamento dello sguardo durante le attività di aviazione fornisce un metodo oggettivo e non invasivo, che potrebbe rivelare come i modelli di movimento degli occhi si riferiscono a vari aspetti dell'elaborazione delle informazioni e delle prestazioni.

Diversi studi hanno dimostrato un'associazione tra lo sguardo e le prestazioni del compito in vari paradigmi di laboratorio, nonché in compiti complessi del mondo reale (ad esempio, la gestione di un aereo). Ad esempio, le aree rilevanti per il compito tendono ad essere fissate più frequentemente e per durate totali più lunghe, suggerendo che la posizione di fissazione, la frequenza e il tempo di permanenza sono proxy per l'allocazione dell'attenzione nei compiti neurocognitivi e aeronautici 4,5,6. I performer e gli esperti di grande successo mostrano significativi pregiudizi di fissazione verso le aree critiche per i compiti rispetto ai performer o ai principianti di minor successo 4,7,8. Gli aspetti spazio-temporali dello sguardo sono catturati attraverso cambiamenti nei modelli di tempo di permanenza in varie aree di interesse (AOI) o misure di distribuzione della fissazione (ad esempio, Entropia dello sguardo stazionario: SGE). Nel contesto dei paradigmi di laboratorio, la durata media della fissazione, la lunghezza del percorso di scansione e la complessità della sequenza dello sguardo (ad esempio, Gaze Transition Entropy: GTE) tendono ad aumentare a causa dell'aumento della scansione e dell'elaborazione necessarie per risolvere i problemi ed elaborare obiettivi/soluzioni di compiti più impegnativi 4,7.

Al contrario, gli studi sull'aviazione hanno dimostrato che la lunghezza del percorso di scansione e la complessità della sequenza di sguardi diminuiscono con la complessità del compito e il carico cognitivo. Questa discrepanza evidenzia il fatto che la comprensione delle componenti del compito e delle esigenze del paradigma impiegato è fondamentale per l'interpretazione accurata delle metriche dello sguardo. Nel complesso, la ricerca fino ad oggi supporta che le misure dello sguardo forniscono una visione significativa e obiettiva dell'elaborazione delle informazioni specifiche del compito che sono alla base delle differenze nella difficoltà del compito, nel carico cognitivo e nelle prestazioni del compito. Con i progressi nella tecnologia di tracciamento oculare (ad esempio, portabilità, calibrazione e costi), l'esame del comportamento dello sguardo in "natura" è un'area di ricerca emergente con applicazioni tangibili per far progredire la formazione professionale nei campi della medicina 9,10,11 e dell'aviazione 12,13,14.

Il lavoro attuale mira a esaminare ulteriormente l'utilità dell'utilizzo di metriche basate sullo sguardo per ottenere informazioni sull'elaborazione delle informazioni, impiegando in modo specifico un eye tracker indossabile durante un'attività di simulazione di volo di emergenza nei piloti a basso tempo. Questo studio amplia il lavoro precedente che ha utilizzato un eye tracker stabilizzato della testa (ad esempio, EyeLink II) per esaminare le differenze nelle metriche di comportamento dello sguardo in funzione della difficoltà di volo (ad esempio, i cambiamenti nelle condizioni meteorologiche)5. Il lavoro presentato in questo manoscritto si estende anche ad altri lavori che descrivono gli approcci metodologici e analitici per l'utilizzo dell'eye tracking in un sistema di realtà virtuale15. Il nostro studio ha utilizzato un simulatore immobile ad alta fedeltà e riporta un'analisi aggiuntiva dei dati sui movimenti oculari (cioè l'entropia). Questo tipo di analisi è stato riportato in articoli precedenti; Tuttavia, un limite nella letteratura attuale è la mancanza di standardizzazione nella segnalazione delle fasi analitiche. Ad esempio, la segnalazione della definizione delle aree di interesse è di fondamentale importanza perché influenza direttamente i valori di entropia risultanti16.

Per riassumere, il lavoro attuale ha esaminato le metriche di comportamento dello sguardo tradizionali e dinamiche, mentre la difficoltà del compito è stata manipolata attraverso l'introduzione di uno scenario di emergenza in volo (ad esempio, guasto totale imprevisto del motore). Ci si aspettava che l'introduzione di uno scenario di emergenza in volo avrebbe fornito informazioni sui cambiamenti del comportamento dello sguardo alla base dell'elaborazione delle informazioni durante le condizioni di compito più difficili. Lo studio qui riportato fa parte di uno studio più ampio che esamina l'utilità dell'eye tracking in un simulatore di volo per informare l'addestramento dei piloti basato sulle competenze. I risultati qui presentati non sono stati pubblicati in precedenza.

Protocollo

Il seguente protocollo può essere applicato a studi che coinvolgono un eye tracker indossabile e un simulatore di volo. Il presente studio coinvolge dati di tracciamento oculare registrati insieme a complesse attività relative all'aviazione in un simulatore di volo (vedi Tabella dei materiali). Il simulatore è stato configurato per essere rappresentativo di un Cessna 172 ed è stato utilizzato con il necessario pannello strumenti (configurazione dell'indicatore di vapore), un sistema avionico/GPS, un pannello audio/luci, un pannello interruttori e un'unità di controllo di volo (FCU) (vedi Figura 1). Il dispositivo del simulatore di volo utilizzato in questo studio è certificabile per scopi di addestramento e utilizzato dalla scuola di volo locale per addestrare le competenze necessarie per rispondere a vari scenari di emergenza, come un guasto al motore, in un ambiente a basso rischio. I partecipanti a questo studio erano tutti autorizzati; Pertanto, hanno sperimentato lo scenario del simulatore di guasto al motore in precedenza nel corso della loro formazione. Questo studio è stato approvato dall'Ufficio di etica della ricerca dell'Università di Waterloo (43564; Data: 17 novembre 2021). Tutti i partecipanti (N = 24; 14 maschi, 10 femmine; età media = 22 anni; ore di volo: 51-280 ore) hanno fornito il consenso informato scritto.

Figura 1: Ambiente del simulatore di volo. Un'illustrazione dell'ambiente del simulatore di volo. Il punto di vista del partecipante sulla cabina di pilotaggio ha replicato quello di un pilota che vola su un Cessna 172, preimpostato per un avvicinamento sottovento alla base fino alla fine all'aeroporto internazionale di Waterloo, Breslau, Ontario, CA. I riquadri arancioni rappresentano le dieci principali aree di interesse utilizzate nelle analisi dello sguardo. Questi includono (1) la velocità, (2) l'assetto, (3) l'altimetro, (4) il coordinatore di virata, (5) la direzione, (6) la velocità verticale e (7) gli indicatori di potenza, nonché i (8) finestrini anteriori, (9) sinistro e (10) destro. Questa cifra è stata modificata da Ayala et al.5. Clicca qui per visualizzare una versione più grande di questa figura.

1. Screening dei partecipanti e consenso informato

- Screening del partecipante tramite un questionario self-report basato sui criteri di inclusione/esclusione 2,5: possesso di almeno una licenza di pilota privato (PPL), visione normale o corretta e nessuna precedente diagnosi di disturbo neuropsichiatrico/neurologico o disabilità dell'apprendimento.

- Informare il partecipante sugli obiettivi e le procedure di studio attraverso un briefing dettagliato gestito dallo sperimentatore e dall'istruttore di volo/tecnico supervisore del simulatore. Esamina i rischi delineati nel documento di consenso approvato dal comitato di revisione etica dell'istituto. Rispondi a qualsiasi domanda sui potenziali rischi. Ottenere il consenso informato scritto prima di iniziare qualsiasi procedura di studio.

2. Requisiti hardware/software e avviamento

- Simulatore di volo (tipicamente completato dal tecnico del simulatore)

- Accendi gli schermi del simulatore e del proiettore. Se uno dei proiettori non si accende contemporaneamente agli altri, riavviare il simulatore.

- Nella schermata delle istruzioni, premere la scheda Preimpostazioni e verificare che siano disponibili le preimpostazioni di posizione e/o meteo richieste. Se necessario, creare un nuovo tipo di preimpostazione; Consultare il tecnico per assistenza.

- Collezione di computer portatili

- Gira il laptop e accedi con le credenziali.

- Quando richiesto, selezionare un profilo preesistente o crearne uno se si esegue il test di un nuovo partecipante. In alternativa, selezionare l'opzione Guest per sovrascrivere l'ultima calibrazione.

- Per creare un nuovo profilo, scorrere fino alla fine dell'elenco dei profili e fare clic su Aggiungi.

- Imposta l'ID del profilo sull'ID partecipante. Questo ID profilo verrà utilizzato per contrassegnare la cartella, che contiene i dati di tracciamento oculare al termine di una registrazione.

- Calibrazione degli occhiali

NOTA: Gli occhiali devono rimanere collegati al laptop per registrare. La calibrazione con la scatola deve essere completata una sola volta all'inizio della raccolta dei dati.- Apri la custodia dell'eye tracker ed estrai gli occhiali.

- Collega il cavo da USB a micro-USB dal laptop agli occhiali. Se richiesto sul laptop, aggiornare il firmware.

- Individua la scatola di calibrazione nera all'interno della custodia dell'eye tracker.

- Sul portatile della raccolta, nell'hub di tracciamento oculare, scegli Strumenti | Calibrazione del dispositivo.

- Posiziona gli occhiali all'interno della scatola e premi Start nella finestra popup per iniziare la calibrazione.

- Rimuovere gli occhiali dalla scatola una volta completata la calibrazione.

- Vestibilità del nasello

- Selezionare il portaobiettivi.

- Chiedi al partecipante di sedersi nella cabina di pilotaggio e di indossare gli occhiali.

- In Eye Tracking Hub, vai a File | Impostazioni | Mago del naso.

- Controlla la regolazione della vestibilità della scatola degli occhiali sul lato sinistro dello schermo. Se la vestibilità è eccellente, procedi al passaggio successivo. In caso contrario, fare clic sulla casella.

- Chiedi al partecipante di seguire le istruzioni per le raccomandazioni di vestibilità mostrate sullo schermo: imposta il nasello, regola gli occhiali per sederti comodamente e guarda dritto davanti a te il laptop.

- Se necessario, sostituire il nasello. Pizzica il nasello al centro, sfilalo fuori dagli occhiali e poi infilane un altro dentro. Continuare a testare i diversi portaobiettivi fino a identificare quello che si adatta meglio al partecipante.

- Chiamate al controllo del traffico aereo (ATC)

NOTA: Se lo studio richiede chiamate ATC, chiedere al partecipante di portare il proprio auricolare o di utilizzare l'auricolare da laboratorio. Completare la calibrazione del bulbo oculare solo dopo che il partecipante ha indossato l'auricolare, poiché l'auricolare può spostare gli occhiali sulla testa, il che influisce sulla precisione della calibrazione.- Verificare che la serie sterzo sia agganciata alla presa sul lato inferiore sinistro del quadro strumenti.

- Chiedi al partecipante di indossare l'auricolare. Chiedi loro di non toccarlo o di toglierlo fino al termine della registrazione.

NOTA: La ricalibrazione è necessaria ogni volta che si sposta l'auricolare (e, quindi, gli occhiali). - Fai un controllo radio.

- Calibrazione del bulbo oculare

NOTA: Ogni volta che il partecipante sposta gli occhiali sulla testa, deve ripetere la calibrazione del bulbo oculare. Chiedi al partecipante di non toccare gli occhiali fino al termine delle prove.- In Eye Tracking Hub, vai alla casella dei parametri a sinistra dello schermo.

- Controllare la modalità di calibrazione e scegliere lo sguardo fisso o la testa fissa di conseguenza.

- Verificare che i punti di calibrazione siano una griglia 5 x 5, per un totale di 25 punti.

- Controllare la modalità di convalida e assicurarsi che corrisponda alla modalità di calibrazione.

- Esamina i risultati dell'eye tracking e verifica che tutto ciò che deve essere registrato per lo studio sia selezionato utilizzando le caselle di spunta.

- Fare clic su File | Impostazioni | Avanzate e verificare che la frequenza di campionamento sia di 250 Hz.

- Seleziona la casella Calibra il tuo tracciamento oculare sullo schermo usando il mouse. Le istruzioni di calibrazione variano in base alla modalità. Per seguire lo studio in corso, utilizzare la modalità di calibrazione dello sguardo fisso : istruire i partecipanti a muovere la testa in modo che la casella si sovrapponga al quadrato nero e si allineino. Quindi, chiedi al partecipante di concentrare lo sguardo sul mirino nel quadrato nero e premi la barra spaziatrice.

- Premi la casella Convalida la configurazione . Le istruzioni saranno le stesse del passaggio 2.6.3. Verificare che il valore di validazione MAE (Mean Absolute Error) sia <1°. In caso contrario, ripetere i passaggi 2.6.3 e 2.6.4.

- Premere Salva calibrazione per salvare la calibrazione nel profilo ogni volta che la calibrazione e la convalida sono completate.

- In Eye Tracking Hub, vai alla casella dei parametri a sinistra dello schermo.

- Utilizzo dell'iPad

NOTA: L'iPad si trova a sinistra del quadro strumenti (vedere la Figura 1). Viene utilizzato per i questionari, in genere dopo il volo.- Accendi l'iPad e assicurati che sia connesso a Internet.

- Apri una finestra in Safari e inserisci il link per il questionario dello studio.

3. Raccolta dei dati

NOTA: Ripetere questi passaggi per ogni prova. Si consiglia di posizionare il laptop sulla panca all'esterno della cabina di pilotaggio.

- Sul computer del simulatore di volo, nella schermata delle istruzioni , premere Preset, quindi scegliere il preset di posizione desiderato da simulare. Premi il pulsante Applica e osserva le schermate che circondano il simulatore per verificare che la modifica avvenga.

- Ripetere il passaggio 3.1 per applicare il preset Meteo .

- Fornire al partecipante eventuali istruzioni specifiche sulla prova o sulla sua traiettoria di volo. Ciò include dire loro di modificare le impostazioni sul cruscotto prima di iniziare.

- Nella schermata delle istruzioni, premere il pulsante arancione STOP per avviare la raccolta dei dati. Il colore cambierà in verde e il testo dirà FLYING. Assicurati di dare un segnale verbale al partecipante in modo che sappia che può iniziare a pilotare l'aereo. Il segnale consigliato è "3, 2, 1, hai i controlli" quando viene premuto il pulsante di arresto arancione.

- Nel laptop di raccolta, premere Avvia registrazione in modo che i dati dell'eye tracker vengano sincronizzati con i dati del simulatore di volo.

- Quando il partecipante ha completato il circuito ed è atterrato, attendere che l'aereo smetta di muoversi.

NOTA: È importante attendere perché durante la post-elaborazione; I dati vengono troncati quando la velocità al suolo si stabilizza a 0. Ciò garantisce coerenza per l'endpoint di tutti gli studi. - Nella schermata delle istruzioni, premere il pulsante verde FLYING . Il colore tornerà arancione e il testo dirà STOPPED. Dai un segnale verbale durante questa fase, quando la raccolta dei dati sta per terminare. Il segnale consigliato è "3, 2, 1, stop".

- Chiedi al partecipante di completare il/i questionario/i post-processuale sull'iPad. Aggiorna la pagina per la versione di prova successiva.

NOTA: Il presente studio ha utilizzato il questionario di autovalutazione SART (Situation Awareness Rating Technique) come unico questionario post-processo17.

4. Elaborazione e analisi dei dati

- Dati del simulatore di volo

NOTA: Il file .csv copiato dal simulatore di volo contiene più di 1.000 parametri che possono essere controllati nel simulatore. Le principali misure di performance di interesse sono elencate e descritte nella Tabella 1.- Per ogni partecipante, calcolare la percentuale di successo utilizzando l'Eq (1) prendendo la percentuale tra le condizioni dell'attività. Le prove fallite sono identificate da criteri predeterminati programmati all'interno del simulatore che termina automaticamente la prova all'atterraggio a causa dell'orientamento del piano e della velocità verticale. Effettuare la verifica post-processo per assicurarsi che questo criterio fosse allineato con le limitazioni effettive dell'aeromobile (ad esempio, il danno/incidente al carrello di atterraggio del Cessna 172 è evidente a velocità verticali > 700 piedi/min [fpm] al momento dell'atterraggio).

Percentuale di successo = (1)

(1)

NOTA: valori più bassi della percentuale di successo indicano risultati peggiori in quanto sono associati a una riduzione dei tentativi di atterraggio riusciti. - Per ogni prova, calcolare il tempo di completamento in base al timestamp, che indica che l'aereo si è fermato sulla pista (ad esempio, velocità al suolo = 0 nodi).

NOTA: un tempo di completamento più breve potrebbe non sempre equivalere a prestazioni migliori. È necessario prestare attenzione per capire in che modo si prevede che le condizioni dell'attività (ad esempio, venti aggiuntivi, scenari di emergenza, ecc.) influiscano sul tempo di completamento. - Per ogni prova, determinare la durezza dell'atterraggio in base alla velocità verticale dell'aeromobile (fpm) nel momento in cui l'aeromobile tocca inizialmente la pista. Assicurarsi che questo valore venga preso allo stesso timestamp associato alla prima modifica dello stato di AircraftOnGround da 0 (in aria) a 1 (a terra).

NOTA: I valori compresi tra -700 fpm e 0 fpm sono considerati sicuri, con valori più vicini a 0 che rappresentano atterraggi più morbidi (cioè migliori). I valori negativi rappresentano la velocità verticale verso il basso; I valori positivi rappresentano la velocità verticale verso l'alto. - Per ogni prova, calcolare l'errore di atterraggio (°) in base alla differenza tra le coordinate di atterraggio e il punto di riferimento sulla pista (centro dei marcatori di 500 piedi). Utilizzando il punto di riferimento, calcolare l'errore di atterraggio utilizzando l'Eq (2).

Differenza = √((Δ Latitudine)2 + (Δ Longitudine)2) (2)

NOTA: Valori inferiori a 1° sono indicati come normali 5,15. Valori elevati indicano un errore di atterraggio maggiore associato ai punti di atterraggio dell'aeromobile più lontani dalla zona di atterraggio. - Calcola le medie tra tutti i partecipanti per ogni variabile di risultato della performance per ogni condizione del compito. Riportare questi valori.

- Per ogni partecipante, calcolare la percentuale di successo utilizzando l'Eq (1) prendendo la percentuale tra le condizioni dell'attività. Le prove fallite sono identificate da criteri predeterminati programmati all'interno del simulatore che termina automaticamente la prova all'atterraggio a causa dell'orientamento del piano e della velocità verticale. Effettuare la verifica post-processo per assicurarsi che questo criterio fosse allineato con le limitazioni effettive dell'aeromobile (ad esempio, il danno/incidente al carrello di atterraggio del Cessna 172 è evidente a velocità verticali > 700 piedi/min [fpm] al momento dell'atterraggio).

- Dati sulla consapevolezza della situazione

- Per ogni prova, calcolare il punteggio SA in base ai punteggi SART auto-riportati nelle 10 dimensioni di SA17.

- Utilizzare il questionario SART17 per determinare le risposte soggettive dei partecipanti riguardo alla difficoltà complessiva del compito, nonché la loro impressione di quante risorse attentive avevano a disposizione e speso durante l'esecuzione del compito.

- Utilizzando una scala Likert a 7 punti, chiedi ai partecipanti di valutare la loro esperienza percepita su domande approfondite, tra cui la complessità della situazione, la divisione dell'attenzione, la capacità mentale di riserva e la quantità e la qualità delle informazioni.

- Combina queste scale in dimensioni più ampie di richieste attentive (Domanda), offerta attenzionale (Offerta) e comprensione della situazione (Comprensione).

- Utilizzare queste valutazioni per calcolare una misura di SA in base all'Eq (3):

SA = Comprensione - (Domanda-Offerta) (3)

NOTA: Punteggi più alti sulle scale combinati per fornire una misura di comprensione suggeriscono che il partecipante ha una buona comprensione del compito da svolgere. Allo stesso modo, punteggi elevati nel dominio dell'offerta suggeriscono che il partecipante ha una quantità significativa di risorse attentive da dedicare a un determinato compito. Al contrario, un punteggio di domanda elevato suggerisce che l'attività richiede una quantità significativa di risorse attentive per essere completata. È importante chiarire che questi punteggi vengono interpretati al meglio se confrontati tra condizioni (ad esempio, condizioni facili e difficili) invece di essere utilizzati come misure autonome.

- Una volta completata la raccolta dei dati, calcola le medie tra tutti i partecipanti per ogni condizione di attività (ad esempio, di base, di emergenza). Riportare questi valori.

- Per ogni prova, calcolare il punteggio SA in base ai punteggi SART auto-riportati nelle 10 dimensioni di SA17.

- Dati di tracciamento oculare

- Utilizza uno script batch di tracciamento oculare per definire manualmente le AOI da utilizzare nella mappatura dello sguardo. Lo script aprirà una nuova finestra per la selezione del fotogramma chiave che dovrebbe visualizzare chiaramente tutte le AOI chiave che verranno analizzate. Scorri il video e scegli un fotogramma che mostri chiaramente tutte le AOI.

- Seguendo le istruzioni sullo schermo, disegna un rettangolo su una regione del fotogramma che sarà visibile per tutto il video, unico, e rimarrà stabile.

NOTA: Lo scopo di questo passaggio è generare un fotogramma di coordinate "sullo schermo" che può essere utilizzato in tutta la registrazione video poiché i movimenti della testa comportano la modifica della posizione degli oggetti nell'ambiente nel corso della registrazione video. - Disegna un rettangolo per ogni AOI nell'immagine, uno alla volta. Nominali di conseguenza. Fare clic su Aggiungi altro per aggiungere un nuovo AOI e premere Fine sull'ultimo. Se le coordinate dello sguardo durante una data fissazione atterrano all'interno dello spazio dell'oggetto come definito nel riquadro delle coordinate "sullo schermo", etichettare tale fissazione con la rispettiva etichetta AOI.

NOTA: lo scopo di questo passaggio è generare una libreria di coordinate dell'oggetto che vengono quindi utilizzate come riferimenti quando si confrontano le coordinate dello sguardo con le coordinate sullo schermo.

In genere ci sono 10 AOI, ma questo dipende da come è configurato il simulatore di volo. Il quadro strumenti potrebbe essere diverso. In linea con il lavoro precedente 5,18, il presente studio utilizza le seguenti AOI: Velocità dell'aria, Assetto, Altimetro, Coordinatore di virata, Direzione, Velocità verticale, Potenza, Finestra anteriore, Finestra sinistra e Finestra destra (vedi Figura 1). - Lascia che lo script inizi a elaborare gli AOI e generi i dati di fissazione. Genera un grafico che mostra le saccadi e le fissazioni sul video.

- Verranno creati due nuovi file: fixations.csv e aoi_parameters.yaml. Il processore batch completerà la post-elaborazione dei dati dello sguardo per ogni prova e per ogni partecipante.

NOTA: Le principali misure di eye tracking di interesse sono elencate nella Tabella 2 e sono calcolate per ogni AOI per ogni prova. - Per ogni prova, calcola le metriche tradizionali dello sguardo 4,5 per ogni AOI in base ai dati generati nel file fixation.csv.

NOTA: Qui, ci concentriamo sul tempo di permanenza (%), che viene calcolato dividendo la somma delle fissazioni per una particolare AOI per la somma di tutte le fissazioni e moltiplicando il quoziente per 100 per ottenere la percentuale di tempo trascorso in una specifica AOI. Non esiste un'interpretazione negativa/positiva intrinseca dai tempi di permanenza calcolati. Forniscono un'indicazione di dove viene prevalentemente allocata l'attenzione. Una durata media di fissazione più lunga è indicativa di un aumento delle esigenze di lavorazione. - Per ogni prova, calcolare la frequenza di lampeggio utilizzando l'Eq (4):

Frequenza di lampeggio = Lampeggi totali/tempo di completamento (4)

NOTA: Lavori precedenti hanno dimostrato che la frequenza delle palpebre è inversamente correlata al carico cognitivo 2,6,13,19,20. - Per ogni prova, calcolare l'SGE utilizzando l'eq (5)21:

(5)

(5)

Dove v è la probabilità di visualizzare l'i-esimo AOI e V è il numero di AOI.

NOTA: Valori SGE più elevati sono associati a una maggiore dispersione di fissazione, mentre valori più bassi sono indicativi di un'allocazione più focalizzata delle fissazioni22. - Per ogni prova, calcolare il GTE utilizzando l'eq (6)23:

(6)

(6)

Dove V è la probabilità di visualizzare l'i-esimo AOI e M è la probabilità di visualizzare il j° AOI data la precedente visione dell'i-esimo AOI.

NOTA: valori GTE più elevati sono associati a percorsi di scansione visiva più imprevedibili e complessi, mentre valori GTE più bassi sono indicativi di percorsi di scansione visiva più prevedibili e di routine. - Calcola le medie tra tutti i partecipanti per ogni variabile di output dell'eye tracking (e AOI quando indicata) e ogni condizione del compito. Riportare questi valori.

| Termine | Definizione |

| Successo (%) | Percentuale di prove di atterraggio riuscite |

| Tempo di completamento (s) | Durata del tempo dall'inizio dello scenario di atterraggio all'arresto completo dell'aereo sulla pista |

| Durezza di atterraggio (fpm) | Il tasso di decente al punto di atterraggio |

| Errore di atterraggio (°) | La differenza tra il centro dell'aereo e il centro dell'indicatore della pista di 500 piedi nel punto di atterraggio |

Tabella 1: Variabili di risultato delle prestazioni del simulatore. Variabili dipendenti dalle prestazioni degli aeromobili e loro definizioni.

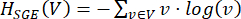

Figura 2: Percorso di volo dello scenario di atterraggio. Schema di (A) il circuito di atterraggio completato in tutte le prove e (B) la pista con i marcatori di 500 piedi che sono stati utilizzati come punto di riferimento per la zona di atterraggio (cioè, cerchio arancione centrale). Clicca qui per visualizzare una versione più grande di questa figura.

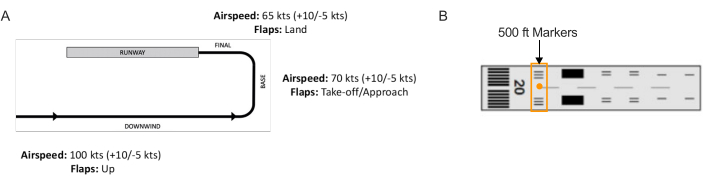

Figura 3: Mappatura dell'area di interesse. Illustrazione dello script batch che illustra una finestra per la selezione dei fotogrammi. La selezione di un fotogramma ottimale comporta la scelta di un fotogramma video che includa la maggior parte o tutte le aree di interesse da mappare. Clicca qui per visualizzare una versione più grande di questa figura.

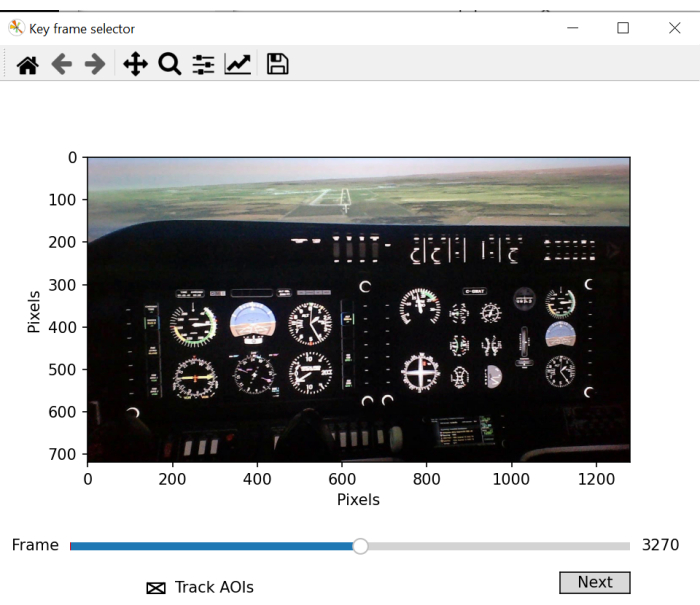

Figura 4: Generazione delle coordinate "sullo schermo" della mappatura dell'area di interesse. Un'illustrazione dello script batch che mostra una finestra per la selezione delle coordinate "sullo schermo". Questa fase prevede la selezione di una regione quadrata/rettangolare che rimane visibile per tutta la durata della registrazione, è unica per l'immagine e rimane statica. Clicca qui per visualizzare una versione più grande di questa figura.

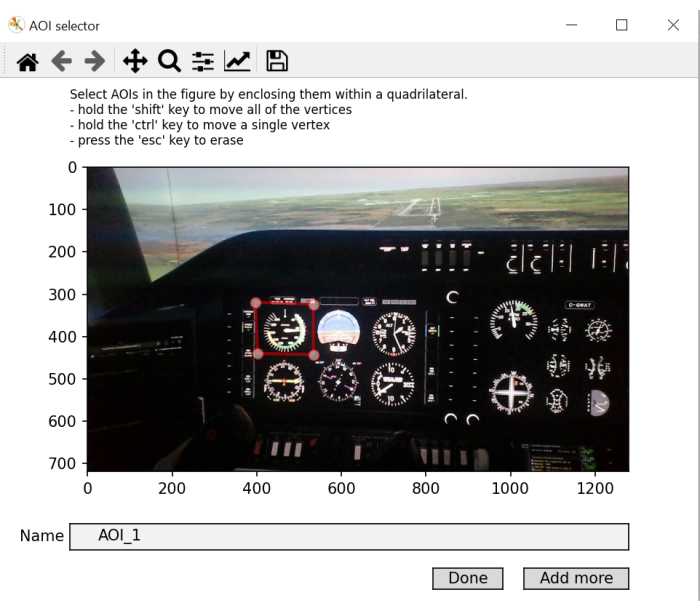

Figura 5: Identificazione dell'area di interesse da mappare. Un'illustrazione della finestra di script batch che consente la selezione e l'etichettatura delle aree di interesse. Abbreviazione: AOI = aree di interesse. Clicca qui per visualizzare una versione più grande di questa figura.

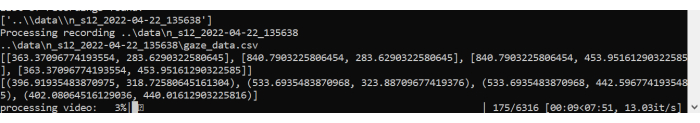

Figura 6: Elaborazione di script batch. Un'illustrazione dello script batch che elabora il video e mappa lo sguardo delle fissazioni effettuate durante il processo. Clicca qui per visualizzare una versione più grande di questa figura.

| Termine | Definizione |

| Tempo di permanenza (%) | Percentuale della somma di tutte le durate di fissazione accumulate su un'AOI rispetto alla somma delle durate di fissazione accumulate su tutte le AOI |

| Durata media della fissazione (ms) | Durata media di una fissazione su un'AOI dall'ingresso all'uscita |

| Frequenza di lampeggio (lampeggiamenti/s) | Numero di lampeggi al secondo |

| SGE (bit) | Dispersione di fissazione |

| GTE (bit) | Complessità della sequenza di scansione |

| Numero di attacchi | Numero di eventi di tunneling cognitivo (>10 s) |

| Tempo totale dell'incontro (s) | Tempo totale degli eventi di tunneling cognitivo |

Tabella 2: Variabili di esito dell'eye tracking. Variabili dipendenti dal comportamento dello sguardo e loro definizioni.

Risultati

L'impatto delle richieste di attività sulle prestazioni di volo

I dati sono stati analizzati sulla base di prove di atterraggio riuscite in condizioni di base e di emergenza. Tutte le misure sono state sottoposte a un test t di campioni accoppiati (fattore all'interno del soggetto: condizione del compito (base, emergenza)). Tutti i test t sono stati eseguiti con un livello alfa impostato a 0,05. Quattro partecipanti si sono schiantati durante la pro...

Discussione

Il metodo di tracciamento oculare qui descritto consente la valutazione dell'elaborazione delle informazioni in un ambiente di simulatore di volo tramite un eye tracker indossabile. La valutazione delle caratteristiche spaziali e temporali del comportamento dello sguardo fornisce informazioni sull'elaborazione delle informazioni umane, che è stata ampiamente studiata utilizzando paradigmi di laboratorio altamente controllati 4,7,28

Divulgazioni

Non esistono interessi finanziari concorrenti.

Riconoscimenti

Questo lavoro è sostenuto in parte dalla Canadian Graduate Scholarship (CGS) del Natural Sciences and Engineering Research Council (NSERC) del Canada e dall'Exploration Grant (00753) del New Frontiers in Research Fund. Tutte le opinioni, i risultati, le conclusioni o le raccomandazioni espresse in questo materiale sono dell'autore o degli autori e non riflettono necessariamente quelle degli sponsor.

Materiali

| Name | Company | Catalog Number | Comments |

| flight simulator | ALSIM | AL-250 | fixed fully immersive flight simulation training device |

| laptop | Hp | Lenovo | eye tracking data collection laptop; requirements: Windows 10 and python 3.0 |

| portable eye-tracker | AdHawk | MindLink eye tracking glasses (250 Hz, <2° gaze error, front-facing camera); eye tracking batch script is made available with AdHawk device purchase |

Riferimenti

- de Brouwer, A. J., Flanagan, J. R., Spering, M. Functional use of eye movements for an acting system. Trends Cogn Sci. 25 (3), 252-263 (2021).

- Ayala, N., Kearns, S., Cao, S., Irving, E., Niechwiej-Szwedo, E. Investigating the role of flight phase and task difficulty on low-time pilot performance, gaze dynamics and subjective situation awareness during simulated flight. J Eye Mov Res. 17 (1), (2024).

- Land, M. F., Hayhoe, M. In what ways do eye movements contribute to everyday activities. Vision Res. 41 (25-26), 3559-3565 (2001).

- Ayala, N., Zafar, A., Niechwiej-Szwedo, E. Gaze behavior: a window into distinct cognitive processes revealed by the Tower of London test. Vision Res. 199, 108072 (2022).

- Ayala, N. The effects of task difficulty on gaze behavior during landing with visual flight rules in low-time pilots. J Eye Mov Res. 16, 10 (2023).

- Glaholt, M. G. . Eye tracking in the cockpit: a review of the relationships between eye movements and the aviators cognitive state. , (2014).

- Hodgson, T. L., Bajwa, A., Owen, A. M., Kennard, C. The strategic control of gaze direction in the Tower-of-London task. J Cognitive Neurosci. 12 (5), 894-907 (2000).

- van De Merwe, K., Van Dijk, H., Zon, R. Eye movements as an indicator of situation awareness in a flight simulator experiment. Int J Aviat Psychol. 22 (1), 78-95 (2012).

- Kok, E. M., Jarodzka, H. Before your very eyes: The value and limitations of eye tracking in medical education. Med Educ. 51 (1), 114-122 (2017).

- Di Stasi, L. L., et al. Gaze entropy reflects surgical task load. Surg Endosc. 30, 5034-5043 (2016).

- Laubrock, J., Krutz, A., Nübel, J., Spethmann, S. Gaze patterns reflect and predict expertise in dynamic echocardiographic imaging. J Med Imag. 10 (S1), S11906-S11906 (2023).

- Brams, S., et al. Does effective gaze behavior lead to enhanced performance in a complex error-detection cockpit task. PloS One. 13 (11), e0207439 (2018).

- Peißl, S., Wickens, C. D., Baruah, R. Eye-tracking measures in aviation: A selective literature review. Int J Aero Psych. 28 (3-4), 98-112 (2018).

- Ziv, G. Gaze behavior and visual attention: A review of eye tracking studies in aviation. Int J Aviat Psychol. 26 (3-4), 75-104 (2016).

- Ke, L., et al. Evaluating flight performance and eye movement patterns using virtual reality flight simulator. J. Vis. Exp. (195), e65170 (2023).

- Krejtz, K., et al. Gaze transition entropy. ACM Transactions on Applied Perception. 13 (1), 1-20 (2015).

- Taylor, R. M., Selcon, S. J. Cognitive quality and situational awareness with advanced aircraft attitude displays. Proceedings of the Human Factors Society Annual Meeting. 34 (1), 26-30 (1990).

- Ayala, N., et al. Does fiducial marker visibility impact task performance and information processing in novice and low-time pilots. Computers & Graphics. 199, 103889 (2024).

- Recarte, M. &. #. 1. 9. 3. ;., Pérez, E., Conchillo, &. #. 1. 9. 3. ;., Nunes, L. M. Mental workload and visual impairment: Differences between pupil, blink, and subjective rating. Spanish J Psych. 11 (2), 374-385 (2008).

- Zheng, B., et al. Workload assessment of surgeons: correlation between NASA TLX and blinks. Surg Endosc. 26, 2746-2750 (2012).

- Shannon, C. E. A mathematical theory of communication. The Bell System Technical Journal. 27 (3), 379-423 (1948).

- Shiferaw, B., Downey, L., Crewther, D. A review of gaze entropy as a measure of visual scanning efficiency. Neurosci Biobehav R. 96, 353-366 (2019).

- Ciuperca, G., Girardin, V. Estimation of the entropy rate of a countable Markov chain. Commun Stat-Theory and Methods. 36 (14), 2543-2557 (2007).

- Federal aviation administration. . Airplane flying handbook. , (2021).

- Brown, D. L., Vitense, H. S., Wetzel, P. A., Anderson, G. M. Instrument scan strategies of F-117A Pilots. Aviat, Space, Envir Med. 73 (10), 1007-1013 (2002).

- Lu, T., Lou, Z., Shao, F., Li, Y., You, X. Attention and entropy in simulated flight with varying cognitive loads. Aerosp Medicine Hum Perf. 91 (6), 489-495 (2020).

- Dehais, F., Peysakhovich, V., Scannella, S., Fongue, J., Gateau, T. "Automation surprise" in aviation: Real-time solutions. , 2525-2534 (2015).

- Kowler, E. Eye movements: The past 25 years. J Vis Res. 51 (13), 1457-1483 (2011).

- Zafar, A., et al. Investigation of camera-free eye-tracking glasses compared to a video-based system. Sensors. 23 (18), 7753 (2023).

- Leube, A., Rifai, K. Sampling rate influences saccade detection in mobile eye tracking of a reading task. J Eye Mov Res. 10 (3), (2017).

- Diaz-Piedra, C., et al. The effects of flight complexity on gaze entropy: An experimental study with fighter pilots. Appl Ergon. 77, 92-99 (2019).

- Shiferaw, B. A., et al. Stationary gaze entropy predicts lane departure events in sleep-deprived drivers. Sci Rep. 8 (1), 1-10 (2018).

- Parker, A. J., Kirkby, J. A., Slattery, T. J. Undersweep fixations during reading in adults and children. J Exp Child Psychol. 192, 104788 (2020).

- Ayala, N., Kearns, S., Irving, E., Cao, S., Niechwiej-Szwedo, E. The effects of a dual task on gaze behavior examined during a simulated flight in low-time pilots. Front Psychol. 15, 1439401 (2024).

- Ayala, N., Heath, M. Executive dysfunction after a sport-related concussion is independent of task-based symptom burden. J Neurotraum. 37 (23), 2558-2568 (2020).

- Huddy, V. C., et al. Gaze strategies during planning in first-episode psychosis. J Abnorm Psychol. 116 (3), 589 (2007).

- Irving, E. L., Steinbach, M. J., Lillakas, L., Babu, R. J., Hutchings, N. Horizontal saccade dynamics across the human life span. Invest Opth Vis Sci. 47 (6), 2478-2484 (2006).

- Yep, R., et al. Interleaved pro/anti-saccade behavior across the lifespan. Front Aging Neurosci. 14, 842549 (2022).

- Manoel, E. D. J., Connolly, K. J. Variability and the development of skilled actions. Int J Psychophys. 19 (2), 129-147 (1995).

Ristampe e Autorizzazioni

Richiedi autorizzazione per utilizzare il testo o le figure di questo articolo JoVE

Richiedi AutorizzazioneEsplora altri articoli

This article has been published

Video Coming Soon