Un abonnement à JoVE est nécessaire pour voir ce contenu. Connectez-vous ou commencez votre essai gratuit.

Method Article

L’oculométrie au cours d’une tâche aéronautique complexe pour obtenir des informations sur le traitement de l’information

Dans cet article

Résumé

L’oculométrie est une méthode non invasive pour sonder le traitement de l’information. Cet article décrit comment l’oculométrie peut être utilisée pour étudier le comportement du regard lors d’une tâche d’urgence de simulation de vol chez des pilotes à temps partiel (c’est-à-dire <350 heures de vol).

Résumé

L’oculométrie a été largement utilisée comme indicateur pour mieux comprendre les processus cognitifs, perceptuels et sensorimoteurs qui sous-tendent la performance des compétences. Des travaux antérieurs ont montré que les mesures du regard traditionnelles et avancées démontrent de manière fiable des différences robustes dans l’expertise du pilote, la charge cognitive, la fatigue et même la conscience de la situation (SA).

Cette étude décrit la méthodologie d’utilisation d’un système de suivi oculaire portable et d’un algorithme de cartographie du regard qui capture les mouvements naturels de la tête et des yeux (c’est-à-dire le regard) dans un simulateur de vol immobile haute fidélité. La méthode décrite dans cet article décrit les analyses du regard basées sur les zones d’intérêt (AOI), qui fournissent plus de contexte lié à l’endroit où les participants regardent, et la durée du temps de séjour, qui indique l’efficacité avec laquelle ils traitent les informations fixées. Le protocole illustre l’utilité d’un oculomètre portable et d’un algorithme de vision par ordinateur pour évaluer les changements de comportement du regard en réponse à une urgence inattendue en vol.

Les résultats représentatifs ont démontré que le regard était considérablement affecté lorsque l’événement d’urgence a été introduit. Plus précisément, l’allocation d’attention, la dispersion du regard et la complexité de la séquence du regard ont diminué de manière significative et sont devenues très concentrées sur le fait de regarder à l’extérieur de la fenêtre avant et de l’anémomètre pendant le scénario d’urgence (toutes les valeurs p < 0,05). L’utilité et les limites de l’utilisation d’un oculomètre portable dans un environnement de simulation de vol immobile haute fidélité pour comprendre les caractéristiques spatio-temporelles du comportement du regard et sa relation avec le traitement de l’information dans le domaine de l’aviation sont discutées.

Introduction

Les humains interagissent principalement avec le monde qui les entoure en bougeant d’abord leurs yeux et leur tête pour concentrer leur ligne de vue (c’est-à-dire leur regard) sur un objet ou un lieu d’intérêt spécifique. Cela est particulièrement vrai dans les environnements complexes tels que les cockpits d’avion où les pilotes sont confrontés à de multiples stimuli concurrents. Les mouvements du regard permettent de collecter des informations visuelles à haute résolution qui permettent aux humains d’interagir avec leur environnement de manière sûre et flexible1, ce qui est d’une importance primordiale dans l’aviation. Des études ont montré que les mouvements oculaires et le comportement du regard donnent un aperçu des processus perceptifs, cognitifs et moteurs sous-jacents à travers diverses tâches 1,2,3. De plus, l’endroit où nous regardons a une influence directe sur la planification et l’exécution des mouvements des membres supérieurs3. Par conséquent, l’analyse du comportement du regard pendant les tâches aéronautiques fournit une méthode objective et non invasive, qui pourrait révéler comment les modèles de mouvements oculaires sont liés à divers aspects du traitement de l’information et de la performance.

Plusieurs études ont démontré une association entre le regard et la performance des tâches dans divers paradigmes de laboratoire, ainsi que dans des tâches complexes du monde réel (c’est-à-dire l’exploitation d’un avion). Par exemple, les zones pertinentes pour la tâche ont tendance à être fixées plus fréquemment et pendant des durées totales plus longues, ce qui suggère que le lieu de fixation, la fréquence et le temps d’attente sont des indicateurs de l’attribution de l’attention dans les tâches neurocognitives et aéronautiques 4,5,6. Les personnes très performantes et les experts présentent des biais de fixation significatifs envers les domaines critiques par rapport aux moins performants ou aux novices 4,7,8. Les aspects spatio-temporels du regard sont capturés par des changements dans les modèles de temps de séjour dans diverses zones d’intérêt (AOI) ou des mesures de distribution de fixation (c’est-à-dire l’entropie du regard stationnaire : SGE). Dans le contexte des paradigmes basés sur le laboratoire, la durée moyenne de fixation, la longueur du chemin de balayage et la complexité de la séquence du regard (c’est-à-dire l’entropie de transition du regard : GTE) ont tendance à augmenter en raison de l’augmentation du balayage et du traitement nécessaires pour résoudre des problèmes et élaborer des objectifs/solutions de tâches plus difficiles 4,7.

À l’inverse, des études aéronautiques ont démontré que la longueur du chemin de balayage et la complexité de la séquence du regard diminuent avec la complexité de la tâche et la charge cognitive. Cette divergence met en évidence le fait que la compréhension des composantes de la tâche et des exigences du paradigme utilisé est essentielle à l’interprétation précise des mesures du regard. Dans l’ensemble, les recherches menées à ce jour soutiennent que les mesures du regard fournissent un aperçu significatif et objectif du traitement de l’information spécifique à la tâche qui sous-tend les différences de difficulté de tâche, de charge cognitive et de performance de la tâche. Avec les progrès de la technologie de suivi oculaire (c’est-à-dire la portabilité, l’étalonnage et le coût), l’examen du comportement du regard dans la nature est un domaine de recherche émergent avec des applications tangibles pour faire progresser la formation professionnelle dans les domaines de la médecine 9,10,11 et de l’aviation 12,13,14.

Les travaux actuels visent à examiner plus en détail l’utilité de l’utilisation de mesures basées sur le regard pour mieux comprendre le traitement de l’information en utilisant spécifiquement un oculomètre portable lors d’une tâche de simulation de vol d’urgence chez les pilotes à temps faible. Cette étude s’appuie sur des travaux antérieurs qui ont utilisé un oculomètre stabilisé (c’est-à-dire EyeLink II) pour examiner les différences dans les paramètres du comportement du regard en fonction de la difficulté de vol (c’est-à-dire les changements dans les conditions météorologiques)5. Les travaux présentés dans ce manuscrit s’inscrivent également dans le prolongement d’autres travaux qui ont décrit les approches méthodologiques et analytiques de l’utilisation de l’oculométrie dans un système de réalité virtuelle15. Notre étude a utilisé un simulateur immobile de plus grande fidélité et rapporte une analyse supplémentaire des données de mouvement oculaire (c’est-à-dire l’entropie). Ce type d’analyse a été rapporté dans des articles précédents ; Cependant, l’une des limites de la littérature actuelle est le manque de normalisation dans la déclaration des étapes analytiques. Par exemple, il est d’une importance cruciale de rendre compte de la définition des zones d’intérêt, car cela influence directement les valeurs d’entropie résultantes16.

En résumé, les travaux actuels ont examiné les mesures traditionnelles et dynamiques du comportement du regard pendant que la difficulté de la tâche était manipulée par l’introduction d’un scénario d’urgence en vol (c’est-à-dire une panne totale inattendue du moteur). On s’attendait à ce que l’introduction d’un scénario d’urgence en vol donne un aperçu des changements de comportement du regard sous-jacents au traitement de l’information dans des conditions de tâche plus difficiles. L’étude rapportée ici fait partie d’une étude plus vaste examinant l’utilité du suivi oculaire dans un simulateur de vol pour éclairer la formation des pilotes basée sur les compétences. Les résultats présentés ici n’ont pas été publiés auparavant.

Protocole

Le protocole suivant peut être appliqué à des études impliquant un oculomètre portable et un simulateur de vol. La présente étude porte sur des données de suivi oculaire enregistrées parallèlement à des tâches complexes liées à l’aviation dans un simulateur de vol (voir le tableau des matériaux). Le simulateur était configuré pour être représentatif d’un Cessna 172 et était équipé du tableau de bord nécessaire (configuration de l’indicateur de vapeur), d’un système avionique/GPS, d’un panneau audio/lumières, d’un panneau de disjoncteurs et d’une unité de commande de vol (FCU) (voir la figure 1). Le simulateur de vol utilisé dans cette étude peut être certifié à des fins de formation et utilisé par l’école de pilotage locale pour former les compétences requises pour intervenir dans divers scénarios d’urgence, comme une panne moteur, dans un environnement à faible risque. Les participants à cette étude étaient tous agréés ; Par conséquent, ils ont déjà fait l’expérience du scénario du simulateur de panne moteur au cours de leur formation. Cette étude a été approuvée par le Bureau d’éthique de la recherche de l’Université de Waterloo (43564 ; Date : 17 novembre 2021). Tous les participants (N = 24 ; 14 hommes, 10 femmes ; âge moyen = 22 ans ; plage d’heures de vol : 51-280 h) ont fourni un consentement éclairé écrit.

Figure 1 : Environnement du simulateur de vol. Une illustration de l’environnement du simulateur de vol. Le point de vue du participant sur le poste de pilotage reproduisait celui d’un pilote aux commandes d’un Cessna 172, préréglé pour une approche vent arrière à la base jusqu’à l’aéroport international de Waterloo, à Breslau, en Ontario, en Californie. Les cases orange représentent les dix principaux domaines d’intérêt utilisés dans les analyses du regard. Il s’agit notamment de (1) la vitesse, (2) l’assiette, (3) l’altimètre, (4) le coordinateur de virage, (5) le cap, (6) la vitesse verticale et (7) les indicateurs de puissance, ainsi que les (8) fenêtres avant, (9) gauche et (10) droite. Cette figure a été modifiée à partir d’Ayala et al.5. Veuillez cliquer ici pour voir une version agrandie de cette figure.

1. Sélection des participants et consentement éclairé

- Dépister le participant à l’aide d’un questionnaire d’auto-évaluation basé sur les critères d’inclusion/exclusion 2,5 : possession d’au moins une licence de pilote privé (PPL), vision normale ou corrigée à la normale, et aucun diagnostic antérieur de trouble neuropsychiatrique/neurologique ou de trouble d’apprentissage.

- Informer le participant des objectifs et des procédures de l’étude au moyen d’un exposé détaillé tenu par l’expérimentateur et l’instructeur de vol superviseur/technicien de simulateur. Examiner les risques décrits dans le document de consentement approuvé par le comité d’éthique de l’établissement. Répondez à toutes les questions sur les risques potentiels. Obtenez un consentement éclairé écrit avant de commencer toute procédure d’étude.

2. Configuration matérielle/logicielle requise et mise en service

- Simulateur de vol (généralement complété par le technicien du simulateur)

- Allumez le simulateur et les écrans du projecteur. Si l’un des projecteurs ne s’allume pas en même temps que les autres, redémarrez le simulateur.

- Sur l’écran d’instructions, appuyez sur l’onglet Préréglages et vérifiez que les préréglages de position et/ou de météo requis sont disponibles. Si nécessaire, créez un nouveau type de préréglage ; Consultez le technicien pour obtenir de l’aide.

- Ordinateur portable de collection

- Retournez l’ordinateur portable et connectez-vous avec vos informations d’identification.

- Lorsque vous y êtes invité, sélectionnez un profil préexistant ou créez-en un si vous testez un nouveau participant. Vous pouvez également sélectionner l’option Invité pour écraser son dernier étalonnage.

- Pour créer un profil, faites défiler jusqu’à la fin de la liste des profils et cliquez sur Ajouter.

- Définissez l’ID de profil sur l’ID du participant. Cet ID de profil sera utilisé pour baliser le dossier, qui contient les données de suivi oculaire une fois l’enregistrement terminé.

- Calibrage des lunettes

REMARQUE : Les lunettes doivent rester connectées à l’ordinateur portable pour enregistrer. L’étalonnage avec la boîte ne doit être effectué qu’une seule fois au début de la collecte des données.- Ouvrez l’étui de l’eye tracker et sortez les lunettes.

- Connectez le câble USB vers micro-USB de l’ordinateur portable aux lunettes. Si vous y êtes invité sur l’ordinateur portable, mettez à jour le micrologiciel.

- Localisez la boîte d’étalonnage noire à l’intérieur du boîtier de l’eye tracker.

- Sur l’ordinateur portable de collection, dans le hub de suivi oculaire, choisissez Outils | Étalonnage de l’appareil.

- Placez les lunettes à l’intérieur de la boîte et appuyez sur Démarrer dans la fenêtre contextuelle pour commencer l’étalonnage.

- Retirez les lunettes de la boîte une fois l’étalonnage terminé.

- Ajustement de l’embout nasal

- Sélectionnez l’embout porte-aux-nez.

- Demandez au participant de s’asseoir dans le cockpit et de mettre les lunettes.

- Dans le hub de suivi oculaire, accédez à Fichier | Paramètres | Sorcier du nez.

- Vérifiez l’ajustement de votre boîte à lunettes sur le côté gauche de l’écran. Si l’ajustement est excellent, passez à l’étape suivante. Sinon, cliquez sur la case.

- Dites au participant de suivre les instructions de recommandation d’ajustement affichées à l’écran : réglez l’embout nasal, ajustez les lunettes pour qu’elles s’assoient confortablement et regardez droit devant vous vers l’ordinateur portable.

- Si nécessaire, remplacez l’embout nasal. Pincez l’embout nasal en son milieu, faites-le glisser hors des verres, puis glissez-en un autre à l’intérieur. Continuez à tester les différents embouts jusqu’à ce que celui qui convient le mieux au participant soit identifié.

- Appels du contrôle de la circulation aérienne (ATC)

REMARQUE : Si l’étude nécessite des appels ATC, demandez au participant d’apporter son propre casque d’écoute ou d’utiliser le casque de laboratoire. L’étalonnage du globe oculaire n’est effectué qu’après que le participant a mis le casque, car celui-ci peut déplacer les lunettes sur la tête, ce qui affecte la précision de l’étalonnage.- Vérifiez que le casque est branché à la prise jack située sous le tableau de bord gauche.

- Demandez au participant de mettre le casque. Demandez-leur de ne pas y toucher ou de ne pas l’enlever jusqu’à ce que l’enregistrement soit terminé.

REMARQUE : Un recalibrage est nécessaire chaque fois que le casque (et, par conséquent, les lunettes) est déplacé. - Faites une vérification radio.

- Calibrage du globe oculaire

REMARQUE : Chaque fois que le participant déplace les lunettes sur sa tête, il doit répéter l’étalonnage du globe oculaire. Demandez au participant de ne pas toucher les lunettes jusqu’à ce que leurs essais soient terminés.- Dans le hub de suivi oculaire, accédez à la boîte de paramètres à gauche de l’écran.

- Vérifiez le mode d’étalonnage et choisissez le regard fixe ou la tête fixe en conséquence.

- Vérifiez que les points d’étalonnage sont une grille de 5 x 5 , pour un total de 25 points.

- Vérifiez le mode de validation et assurez-vous qu’il correspond au mode d’étalonnage.

- Examinez les résultats du suivi oculaire et vérifiez que tout ce qui doit être enregistré pour l’étude est vérifié à l’aide des cases à cocher.

- Cliquez sur File | Paramètres | Avancé et vérifiez que la fréquence d’échantillonnage est de 250 Hz.

- Cochez la case Calibrer votre suivi oculaire à l’écran à l’aide de la souris. Les instructions d’étalonnage varient en fonction du mode. Pour suivre l’étude en cours, utilisez le mode de calibrage du regard fixe : demandez aux participants de bouger la tête de manière à ce que la boîte se chevauche avec le carré noir et qu’ils s’alignent. Ensuite, demandez au participant de concentrer son regard sur le réticule dans le carré noir et d’appuyer sur la barre d’espace.

- Appuyez sur la case Valider votre configuration . Les instructions seront les mêmes qu’à l’étape 2.6.3. Vérifiez que le chiffre de validation MAE (Mean Absolute Error) est de <1°. Si ce n’est pas le cas, répétez les étapes 2.6.3 et 2.6.4.

- Appuyez sur Enregistrer l’étalonnage pour enregistrer l’étalonnage dans le profil chaque fois que l’étalonnage et la validation sont terminés.

- Dans le hub de suivi oculaire, accédez à la boîte de paramètres à gauche de l’écran.

- Utilisation de l’iPad

REMARQUE : l’iPad est situé à gauche du tableau de bord (voir Figure 1). Il est utilisé pour les questionnaires, généralement après le vol.- Allumez l’iPad et assurez-vous qu’il est connecté à Internet.

- Ouvrez une fenêtre dans Safari et entrez le lien du questionnaire de l’étude.

3. Collecte des données

REMARQUE : Répétez ces étapes pour chaque essai. Il est recommandé de placer l’ordinateur portable sur le banc à l’extérieur du cockpit.

- Sur l’ordinateur du simulateur de vol, dans l’écran d’instructions , appuyez sur Préréglages, puis choisissez le préréglage de position souhaité à simuler. Appuyez sur le bouton Appliquer et regardez les écrans entourant le simulateur pour vérifier que la modification a lieu.

- Répétez l’étape 3.1 pour appliquer le préréglage Météo .

- Donnez au participant des instructions spécifiques concernant l’essai ou sa trajectoire de vol. Cela inclut de leur dire de modifier tous les paramètres du tableau de bord avant de commencer.

- Dans l’écran d’instructions, appuyez sur le bouton orange STOPPED pour démarrer la collecte de données. La couleur passera au vert et le texte indiquera FLYING. Assurez-vous de donner un signal verbal au participant afin qu’il sache qu’il peut commencer à piloter l’avion. Le repère recommandé est « 3, 2, 1, vous avez des commandes » lorsque le bouton d’arrêt orange est enfoncé.

- Dans l’ordinateur portable de collection, appuyez sur Démarrer l’enregistrement afin que les données de l’oculomètre soient synchronisées avec les données du simulateur de vol.

- Lorsque le participant a terminé son circuit et atterri, attendez que l’avion s’arrête de bouger.

REMARQUE : Il est important d’attendre car pendant le post-traitement ; Les données sont tronquées lorsque la vitesse sol s’établit à 0. Cela donne de la cohérence pour le critère final de tous les essais. - Dans l’écran d’instructions, appuyez sur le bouton vert FLY . La couleur redeviendra orange et le texte indiquera STOPPED. Donnez un signal verbal au cours de cette étape lorsque la collecte de données est sur le point de se terminer. Le signal recommandé est « 3, 2, 1, stop ».

- Demandez au participant de remplir le(s) questionnaire(s) post-essai sur l’iPad. Actualisez la page pour la prochaine version d’essai.

REMARQUE : La présente étude a utilisé le questionnaire d’auto-évaluation SART (Situation Awareness Rating Technique) comme seul questionnaire post-procès17.

4. Traitement et analyse des données

- Données du simulateur de vol

REMARQUE : Le fichier .csv copié à partir du simulateur de vol contient plus de 1 000 paramètres qui peuvent être contrôlés dans le simulateur. Les principales mesures de rendement d’intérêt sont énumérées et décrites dans le tableau 1.- Pour chaque participant, calculez le taux de réussite à l’aide de l’équation (1) en prenant le pourcentage dans toutes les conditions de la tâche. Les essais échoués sont identifiés par des critères prédéterminés programmés dans le simulateur qui mettent fin automatiquement à l’essai au toucher des roues en raison de l’orientation de l’avion et de la vitesse verticale. Effectuer une vérification après l’essai pour s’assurer que ce critère était conforme aux limites réelles de l’aéronef (c.-à-d. que les dommages au train d’atterrissage du Cessna 172 ou l’écrasement sont évidents à des vitesses verticales > 700 pieds/min [pi/min] au moment du toucher des roues).

Taux de réussite = (1)

(1)

REMARQUE : Des valeurs de taux de réussite plus faibles indiquent que les résultats sont moins bons, car elles sont associées à une réduction des tentatives d’atterrissage réussies. - Pour chaque essai, calculez le temps d’achèvement en fonction de l’horodatage, qui indique que l’avion s’est arrêté sur la piste (c’est-à-dire GroundSpeed = 0 nœuds).

REMARQUE : Un temps d’achèvement plus court n’est pas toujours synonyme de meilleures performances. Il faut faire preuve de prudence pour comprendre comment les conditions de la tâche (c.-à-d. vents supplémentaires, scénarios d’urgence, etc.) devraient avoir une incidence sur le temps d’achèvement. - Pour chaque essai, déterminez la dureté d’atterrissage en fonction de la vitesse verticale de l’aéronef (pi/min) au moment où l’aéronef touche la piste. Assurez-vous que cette valeur est prise au même horodatage que celui associé au premier changement de statut AircraftOnGround de 0 (en vol) à 1 (au sol).

REMARQUE : Les valeurs comprises entre -700 pi/min et 0 pi/min sont considérées comme sûres, les valeurs plus proches de 0 représentant des atterrissages plus doux (c.-à-d. meilleurs). Les valeurs négatives représentent la vitesse verticale vers le bas ; Les valeurs positives représentent la vitesse verticale ascendante. - Pour chaque essai, calculez l’erreur d’atterrissage (°) en fonction de la différence entre les coordonnées de toucher des roues et le point de référence sur la piste (centre des repères de 500 pieds). À l’aide du point de référence, calculer l’erreur d’atterrissage à l’aide de l’équation (2).

Différence = √((Δ Latitude)2 + (Δ Longitude)2) (2)

REMARQUE : Les valeurs inférieures à 1° sont normales 5,15. Des valeurs élevées indiquent une erreur d’atterrissage plus importante associée à des points d’atterrissage de l’avion plus éloignés de la zone d’atterrissage. - Calculez les moyennes de tous les participants pour chaque variable de résultat de performance pour chaque condition de tâche. Signalez ces valeurs.

- Pour chaque participant, calculez le taux de réussite à l’aide de l’équation (1) en prenant le pourcentage dans toutes les conditions de la tâche. Les essais échoués sont identifiés par des critères prédéterminés programmés dans le simulateur qui mettent fin automatiquement à l’essai au toucher des roues en raison de l’orientation de l’avion et de la vitesse verticale. Effectuer une vérification après l’essai pour s’assurer que ce critère était conforme aux limites réelles de l’aéronef (c.-à-d. que les dommages au train d’atterrissage du Cessna 172 ou l’écrasement sont évidents à des vitesses verticales > 700 pieds/min [pi/min] au moment du toucher des roues).

- Données de connaissance de la situation

- Pour chaque essai, calculez le score SA en fonction des scores SART autodéclarés pour les 10 dimensions de SA17.

- Utilisez le questionnaire SART17 pour déterminer les réponses subjectives des participants concernant la difficulté globale de la tâche, ainsi que leur impression de la quantité de ressources attentionnelles dont ils disposaient et qu’ils ont dépensées pendant l’exécution de la tâche.

- À l’aide d’une échelle de Likert à 7 points, demandez aux participants d’évaluer leur expérience perçue sur des questions d’approfondissement, y compris la complexité de la situation, la division de l’attention, la capacité mentale de réserve et la quantité et la qualité de l’information.

- Combinez ces échelles dans des dimensions plus grandes de demandes attentionnelles (demande), d’offre attentionnelle (offre) et de compréhension de la situation (compréhension).

- Utilisez ces cotes pour calculer une mesure de l’AS basée sur l’équation (3) :

SA = Comprendre - (Offre-Demande) (3)

REMARQUE : Des scores plus élevés sur les échelles combinés pour fournir une mesure de la compréhension suggèrent que le participant a une bonne compréhension de la tâche à accomplir. De même, des scores élevés dans le domaine de l’approvisionnement suggèrent que le participant dispose d’une quantité importante de ressources attentionnelles à consacrer à une tâche donnée. En revanche, un score de demande élevé suggère que la tâche nécessite une quantité importante de ressources attentionnelles pour être accomplie. Il est important de préciser qu’il est préférable de comparer ces scores entre les conditions (c.-à-d. conditions faciles ou difficiles) au lieu d’être utilisés comme des mesures autonomes.

- Une fois la collecte de données terminée, calculez les moyennes pour tous les participants pour chaque condition de tâche (c.-à-d. de base, urgence). Signalez ces valeurs.

- Pour chaque essai, calculez le score SA en fonction des scores SART autodéclarés pour les 10 dimensions de SA17.

- Données de suivi oculaire

- Utilisez un script batch de suivi oculaire pour définir manuellement les zones d’intérêt à utiliser dans le mappage du regard. Le script ouvrira une nouvelle fenêtre pour la sélection d’images clés qui devrait afficher clairement toutes les AOI clés qui seront analysées. Faites défiler la vidéo et choisissez une image qui montre clairement toutes les AOI.

- En suivant les instructions à l’écran, tracez un rectangle sur une région de l’image qui sera visible tout au long de la vidéo, unique et stable.

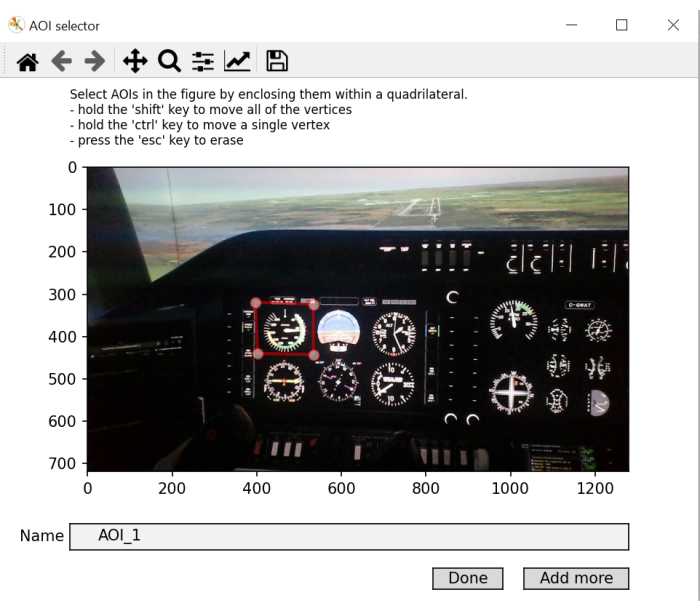

REMARQUE : Le but de cette étape est de générer une image de coordonnées « à l’écran » qui peut être utilisée tout au long de l’enregistrement vidéo, car les mouvements de la tête entraînent une modification de l’emplacement des objets dans l’environnement au cours de l’enregistrement vidéo. - Dessinez un rectangle pour chaque zone d’intérêt de l’image, un à la fois. Nommez-les en conséquence. Cliquez sur Ajouter plus pour ajouter une nouvelle AOI et appuyez sur Terminé sur la dernière. Si les coordonnées du regard lors d’une fixation donnée atterrissent dans l’espace de l’objet tel que défini dans le cadre de coordonnées « à l’écran », étiquetez cette fixation avec l’étiquette AOI correspondante.

REMARQUE : L’objectif de cette étape est de générer une bibliothèque de coordonnées d’objet qui sont ensuite utilisées comme références lors de la comparaison des coordonnées du regard aux coordonnées à l’écran.

Il y a généralement 10 AOI, mais cela dépend de la façon dont le simulateur de vol est configuré. Le tableau de bord peut être différent. Conformément aux travaux précédents 5,18, la présente étude utilise les zones d’intérêt suivantes : vitesse, attitude, altimètre, coordinateur de virage, cap, vitesse verticale, puissance, fenêtre avant, fenêtre gauche et fenêtre droite (voir Figure 1). - Laissez le script commencer à traiter les AOI et générer des données de fixation. Il génère un tracé montrant les saccades et les fixations au cours de la vidéo.

- Deux nouveaux fichiers seront créés : fixations.csv et aoi_parameters.yaml. Le processeur de lots effectuera le post-traitement des données de regard pour chaque essai et chaque participant.

REMARQUE : Les principales mesures d’intérêt pour le suivi oculaire sont énumérées dans le tableau 2 et sont calculées pour chaque zone d’intérêt pour chaque essai. - Pour chaque essai, calculez les métriques de regard traditionnelles 4,5 pour chaque AOI sur la base des données générées dans le fichier fixation.csv.

REMARQUE : Ici, nous nous concentrons sur le temps de séjour ( %) ( %), qui est calculé en divisant la somme des fixations pour une AOI particulière par la somme de toutes les fixations et en multipliant le quotient par 100 pour obtenir le pourcentage de temps passé dans une AOI spécifique. Il n’y a pas d’interprétation négative/positive inhérente aux temps de séjour calculés. Ils donnent une indication de l’endroit où l’attention est principalement allouée. Des durées de fixation moyennes plus longues sont le signe d’une augmentation des demandes de traitement. - Pour chaque essai, calculez le taux de clignotement à l’aide de l’équation (4) :

Taux de clignements des yeux = Nombre total de clignements/temps d’achèvement (4)

REMARQUE : Des travaux antérieurs ont montré que le taux de clignement des yeux est inversement lié à la charge cognitive 2,6,13,19,20. - Pour chaque essai, calculer l’EGS à l’aide de l’équation (5)21 :

(5)

(5)

Où v est la probabilité de voir laième zone d’intérêt et V est le nombre de zones d’intérêt.

REMARQUE : Des valeurs SGE plus élevées sont associées à une plus grande dispersion de fixation, tandis que des valeurs plus faibles indiquent une répartition plus ciblée des fixations22. - Pour chaque essai, calculer le GTE à l’aide de l’équation (6)23 :

(6)

(6)

Où V est la probabilité de voir laième zone d’intérêt, et M est la probabilité de voir la jèmezone d’intérêt compte tenu de la visualisation précédente de laième zone d’intérêt.

REMARQUE : Des valeurs GTE plus élevées sont associées à des chemins de balayage visuel plus imprévisibles et complexes, tandis que des valeurs GTE plus faibles indiquent des chemins de balayage visuel plus prévisibles et réguliers. - Calculez les moyennes de tous les participants pour chaque variable de sortie de suivi oculaire (et AOI si indiqué) et chaque condition de tâche. Signalez ces valeurs.

| Terme | Définition |

| Succès ( %) | Pourcentage d’essais à l’atterrissage réussis |

| Délai(s) de réalisation | Durée entre le début du scénario d’atterrissage et l’arrêt complet de l’avion sur la piste |

| Dureté à l’atterrissage (fpm) | Le taux de descente au point d’atterrissage |

| Erreur d’atterrissage (°) | La différence entre le centre de l’avion et le centre de la marque de piste de 500 pieds au point d’atterrissage |

Tableau 1 : Variables de résultat du rendement du simulateur. Variables dépendantes des performances de l’avion et leurs définitions.

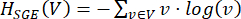

Figure 2 : Trajectoire de vol du scénario d’atterrissage. Schéma (A) du circuit d’atterrissage effectué lors de tous les essais et (B) de la piste avec les balises de 500 pieds qui ont été utilisées comme point de référence pour la zone d’atterrissage (c.-à-d. cercle orange central). Veuillez cliquer ici pour voir une version agrandie de cette figure.

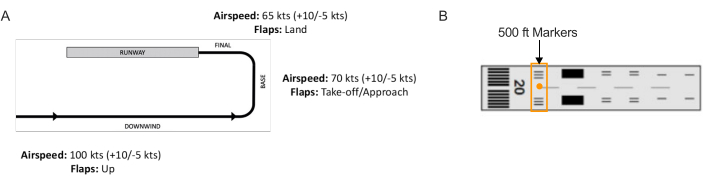

Figure 3 : Cartographie de la zone d’intérêt. Une illustration du script batch montrant une fenêtre pour la sélection de cadres. La sélection d’une image optimale implique le choix d’une image vidéo qui comprend la plupart ou toutes les zones d’intérêt à cartographier. Veuillez cliquer ici pour voir une version agrandie de cette figure.

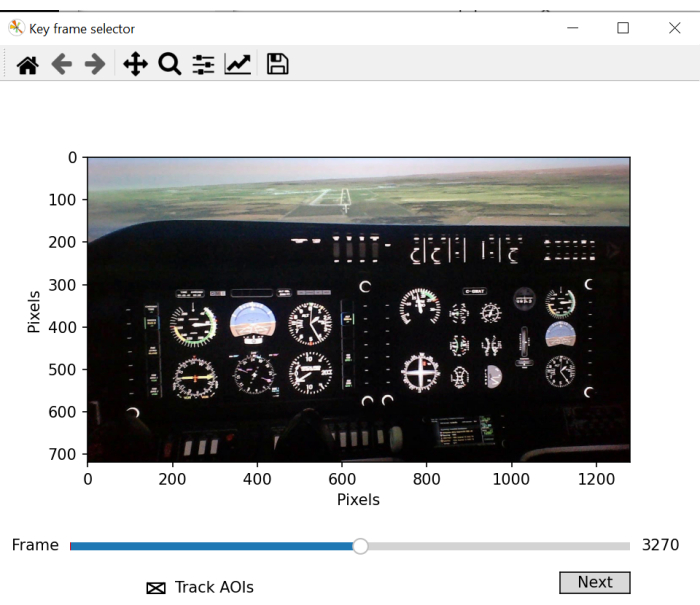

Figure 4 : Génération des coordonnées de cartographie de zone d’intérêt « à l’écran ». Une illustration du script batch montrant une fenêtre pour la sélection des coordonnées « à l’écran ». Cette étape implique la sélection d’une région carrée/rectangulaire qui reste visible tout au long de l’enregistrement, qui est unique à l’image et qui reste statique. Veuillez cliquer ici pour voir une version agrandie de cette figure.

Figure 5 : Identification de la zone d’intérêt à cartographier. Une illustration de la fenêtre de script par lots qui permet de sélectionner et d’étiqueter les zones d’intérêt. Abréviation : ZI = zones d’intérêt. Veuillez cliquer ici pour voir une version agrandie de cette figure.

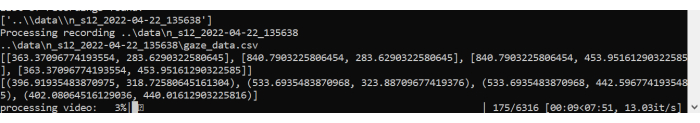

Figure 6 : Traitement de scripts par lots. Une illustration du script batch de traitement de la vidéo et du mapping du regard des fixations réalisées tout au long de l’essai. Veuillez cliquer ici pour voir une version agrandie de cette figure.

| Terme | Définition |

| Temps de séjour ( %) | Pourcentage de la somme de toutes les durées de fixation accumulées sur une zone d’intérêt par rapport à la somme des durées de fixation accumulées sur l’ensemble des zones d’intérêt |

| Durée moyenne de fixation (ms) | Durée moyenne d’une fixation sur une zone d’intérêt, de l’entrée à la sortie |

| Taux de clignotement (clignotements/s) | Nombre de clignotements par seconde |

| SGE (embouts) | Dispersion de fixation |

| GTE (bits) | Complexité de la séquence de balayage |

| Nombre de combats | Nombre d’événements de tunnel cognitif (>10 s) |

| Durée totale du combat (s) | Temps total des événements de tunneling cognitif |

Tableau 2 : Variables de résultat du suivi oculaire. Variables dépendantes du comportement du regard et leurs définitions.

Résultats

L’impact des exigences de la tâche sur les performances de vol

Les données ont été analysées sur la base d’essais d’atterrissage réussis dans des conditions de base et d’urgence. Toutes les mesures ont été soumises à un test t sur échantillons appariés (facteur intra-sujet : condition de la tâche (de base, d’urgence)). Tous les tests t ont été effectués avec un niveau alpha fixé à 0,05. Quatre participants se sont écrasés...

Discussion

La méthode de suivi oculaire décrite ici permet d’évaluer le traitement de l’information dans un environnement de simulateur de vol au moyen d’un suivi oculaire portable. L’évaluation des caractéristiques spatiales et temporelles du comportement du regard donne un aperçu du traitement de l’information humaine, qui a été largement étudié à l’aide de paradigmes de laboratoire hautement contrôlés 4,7,28...

Déclarations de divulgation

Il n’existe pas d’intérêts financiers concurrents.

Remerciements

Ces travaux sont financés en partie par la Bourse d’études supérieures du Canada (BESC) du Conseil de recherches en sciences naturelles et en génie (CRSNG) du Canada et la Subvention d’exploration (00753) du Fonds Nouvelles frontières en recherche. Les opinions, constatations, conclusions ou recommandations exprimées dans ce document sont celles de l’auteur ou des auteurs et ne reflètent pas nécessairement celles des commanditaires.

matériels

| Name | Company | Catalog Number | Comments |

| flight simulator | ALSIM | AL-250 | fixed fully immersive flight simulation training device |

| laptop | Hp | Lenovo | eye tracking data collection laptop; requirements: Windows 10 and python 3.0 |

| portable eye-tracker | AdHawk | MindLink eye tracking glasses (250 Hz, <2° gaze error, front-facing camera); eye tracking batch script is made available with AdHawk device purchase |

Références

- de Brouwer, A. J., Flanagan, J. R., Spering, M. Functional use of eye movements for an acting system. Trends Cogn Sci. 25 (3), 252-263 (2021).

- Ayala, N., Kearns, S., Cao, S., Irving, E., Niechwiej-Szwedo, E. Investigating the role of flight phase and task difficulty on low-time pilot performance, gaze dynamics and subjective situation awareness during simulated flight. J Eye Mov Res. 17 (1), (2024).

- Land, M. F., Hayhoe, M. In what ways do eye movements contribute to everyday activities. Vision Res. 41 (25-26), 3559-3565 (2001).

- Ayala, N., Zafar, A., Niechwiej-Szwedo, E. Gaze behavior: a window into distinct cognitive processes revealed by the Tower of London test. Vision Res. 199, 108072 (2022).

- Ayala, N. The effects of task difficulty on gaze behavior during landing with visual flight rules in low-time pilots. J Eye Mov Res. 16, 10 (2023).

- Glaholt, M. G. . Eye tracking in the cockpit: a review of the relationships between eye movements and the aviators cognitive state. , (2014).

- Hodgson, T. L., Bajwa, A., Owen, A. M., Kennard, C. The strategic control of gaze direction in the Tower-of-London task. J Cognitive Neurosci. 12 (5), 894-907 (2000).

- van De Merwe, K., Van Dijk, H., Zon, R. Eye movements as an indicator of situation awareness in a flight simulator experiment. Int J Aviat Psychol. 22 (1), 78-95 (2012).

- Kok, E. M., Jarodzka, H. Before your very eyes: The value and limitations of eye tracking in medical education. Med Educ. 51 (1), 114-122 (2017).

- Di Stasi, L. L., et al. Gaze entropy reflects surgical task load. Surg Endosc. 30, 5034-5043 (2016).

- Laubrock, J., Krutz, A., Nübel, J., Spethmann, S. Gaze patterns reflect and predict expertise in dynamic echocardiographic imaging. J Med Imag. 10 (S1), S11906-S11906 (2023).

- Brams, S., et al. Does effective gaze behavior lead to enhanced performance in a complex error-detection cockpit task. PloS One. 13 (11), e0207439 (2018).

- Peißl, S., Wickens, C. D., Baruah, R. Eye-tracking measures in aviation: A selective literature review. Int J Aero Psych. 28 (3-4), 98-112 (2018).

- Ziv, G. Gaze behavior and visual attention: A review of eye tracking studies in aviation. Int J Aviat Psychol. 26 (3-4), 75-104 (2016).

- Ke, L., et al. Evaluating flight performance and eye movement patterns using virtual reality flight simulator. J. Vis. Exp. (195), e65170 (2023).

- Krejtz, K., et al. Gaze transition entropy. ACM Transactions on Applied Perception. 13 (1), 1-20 (2015).

- Taylor, R. M., Selcon, S. J. Cognitive quality and situational awareness with advanced aircraft attitude displays. Proceedings of the Human Factors Society Annual Meeting. 34 (1), 26-30 (1990).

- Ayala, N., et al. Does fiducial marker visibility impact task performance and information processing in novice and low-time pilots. Computers & Graphics. 199, 103889 (2024).

- Recarte, M. &. #. 1. 9. 3. ;., Pérez, E., Conchillo, &. #. 1. 9. 3. ;., Nunes, L. M. Mental workload and visual impairment: Differences between pupil, blink, and subjective rating. Spanish J Psych. 11 (2), 374-385 (2008).

- Zheng, B., et al. Workload assessment of surgeons: correlation between NASA TLX and blinks. Surg Endosc. 26, 2746-2750 (2012).

- Shannon, C. E. A mathematical theory of communication. The Bell System Technical Journal. 27 (3), 379-423 (1948).

- Shiferaw, B., Downey, L., Crewther, D. A review of gaze entropy as a measure of visual scanning efficiency. Neurosci Biobehav R. 96, 353-366 (2019).

- Ciuperca, G., Girardin, V. Estimation of the entropy rate of a countable Markov chain. Commun Stat-Theory and Methods. 36 (14), 2543-2557 (2007).

- Federal aviation administration. . Airplane flying handbook. , (2021).

- Brown, D. L., Vitense, H. S., Wetzel, P. A., Anderson, G. M. Instrument scan strategies of F-117A Pilots. Aviat, Space, Envir Med. 73 (10), 1007-1013 (2002).

- Lu, T., Lou, Z., Shao, F., Li, Y., You, X. Attention and entropy in simulated flight with varying cognitive loads. Aerosp Medicine Hum Perf. 91 (6), 489-495 (2020).

- Dehais, F., Peysakhovich, V., Scannella, S., Fongue, J., Gateau, T. "Automation surprise" in aviation: Real-time solutions. , 2525-2534 (2015).

- Kowler, E. Eye movements: The past 25 years. J Vis Res. 51 (13), 1457-1483 (2011).

- Zafar, A., et al. Investigation of camera-free eye-tracking glasses compared to a video-based system. Sensors. 23 (18), 7753 (2023).

- Leube, A., Rifai, K. Sampling rate influences saccade detection in mobile eye tracking of a reading task. J Eye Mov Res. 10 (3), (2017).

- Diaz-Piedra, C., et al. The effects of flight complexity on gaze entropy: An experimental study with fighter pilots. Appl Ergon. 77, 92-99 (2019).

- Shiferaw, B. A., et al. Stationary gaze entropy predicts lane departure events in sleep-deprived drivers. Sci Rep. 8 (1), 1-10 (2018).

- Parker, A. J., Kirkby, J. A., Slattery, T. J. Undersweep fixations during reading in adults and children. J Exp Child Psychol. 192, 104788 (2020).

- Ayala, N., Kearns, S., Irving, E., Cao, S., Niechwiej-Szwedo, E. The effects of a dual task on gaze behavior examined during a simulated flight in low-time pilots. Front Psychol. 15, 1439401 (2024).

- Ayala, N., Heath, M. Executive dysfunction after a sport-related concussion is independent of task-based symptom burden. J Neurotraum. 37 (23), 2558-2568 (2020).

- Huddy, V. C., et al. Gaze strategies during planning in first-episode psychosis. J Abnorm Psychol. 116 (3), 589 (2007).

- Irving, E. L., Steinbach, M. J., Lillakas, L., Babu, R. J., Hutchings, N. Horizontal saccade dynamics across the human life span. Invest Opth Vis Sci. 47 (6), 2478-2484 (2006).

- Yep, R., et al. Interleaved pro/anti-saccade behavior across the lifespan. Front Aging Neurosci. 14, 842549 (2022).

- Manoel, E. D. J., Connolly, K. J. Variability and the development of skilled actions. Int J Psychophys. 19 (2), 129-147 (1995).

Réimpressions et Autorisations

Demande d’autorisation pour utiliser le texte ou les figures de cet article JoVE

Demande d’autorisationExplorer plus d’articles

This article has been published

Video Coming Soon